Ако искате да стартирате големи езикови модели или LLM на вашия компютър, един от най-лесните начини да го направите е чрез Ollama. Ollama е мощна платформа с отворен код, която предлага адаптивно и лесно достъпно AI изживяване. Това улеснява изтеглянето, инсталирането и взаимодействието с различни LLM, без да е необходимо да разчитате на облачни платформи или да изисквате технически опит.

В допълнение към горните предимства, Ollama е доста лек и се актуализира редовно, което го прави доста подходящ за изграждане и управление на LLM на локални машини. Така не се нуждаете от външни сървъри или сложни конфигурации. Ollama също поддържа множество операционни системи, включително Windows, Linux и macOS, както и различни Docker среди.

Изтегляне и инсталиране на Ollama

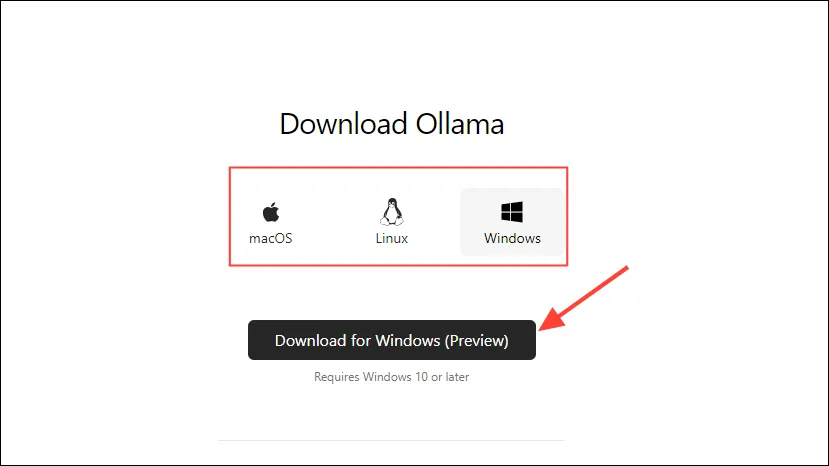

- Първо посетете страницата за изтегляне на Ollama и изберете вашата операционна система, преди да щракнете върху бутона „Изтегляне“.

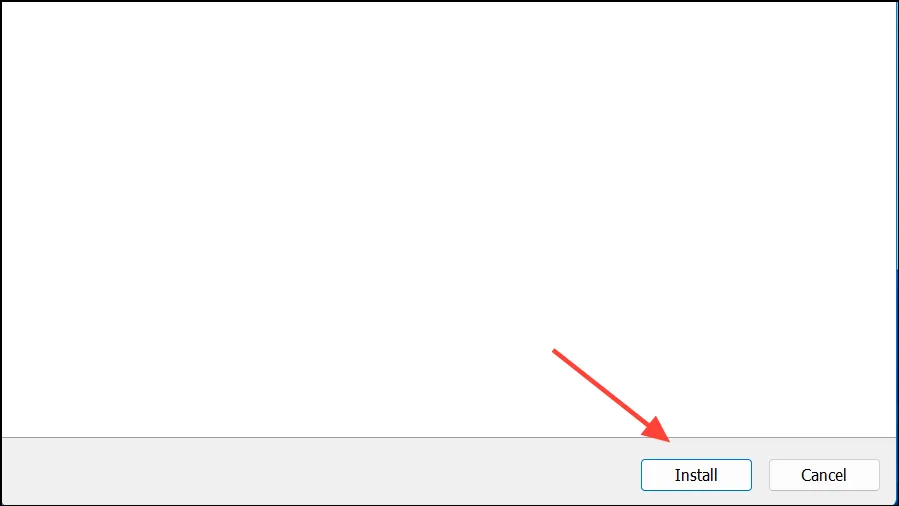

- След като изтеглянето приключи, отворете го и го инсталирайте на вашето устройство. Инсталаторът ще се затвори автоматично, след като инсталацията приключи.

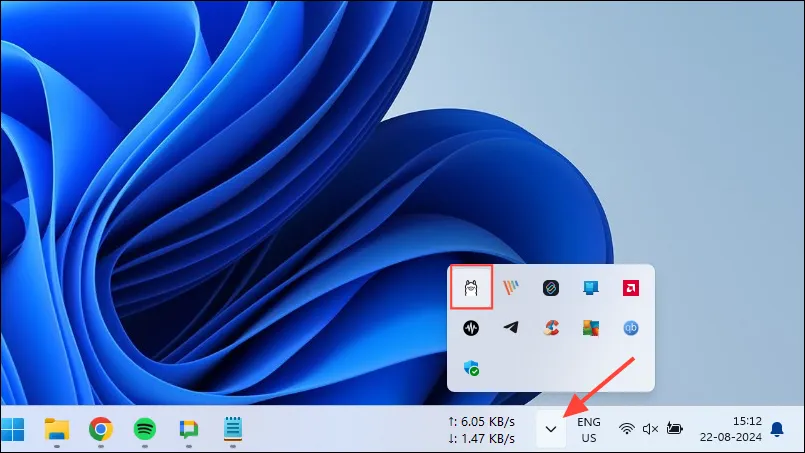

- В Windows можете да проверите дали Ollama работи или не, като щракнете върху бутона за препълване на лентата на задачите, за да видите скритите икони.

Персонализиране и използване на Ollama

След като Ollama бъде инсталиран на вашия компютър, първото нещо, което трябва да направите, е да промените мястото, където съхранява данните си. По подразбиране мястото за съхранение е, C:\Users\%username%\.ollama\modelsно тъй като AI моделите могат да бъдат доста големи, вашето C устройство може да се запълни бързо. За да направите това,

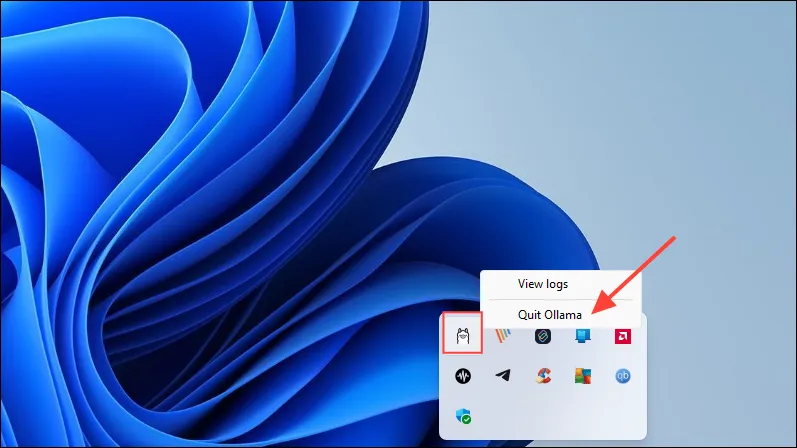

- Първо щракнете върху иконата на Ollama в лентата на задачите и щракнете върху „Изход от Ollama“.

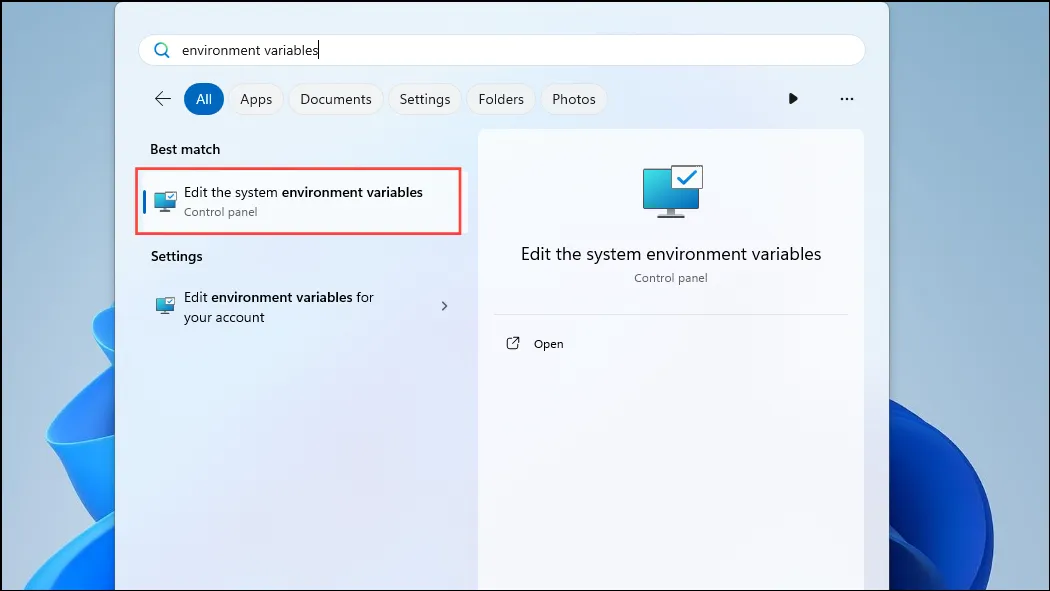

- След като Ollama излезе, отворете менюто „Старт“, въведете

environment variablesи щракнете върху „Редактиране на променливите на системната среда“.

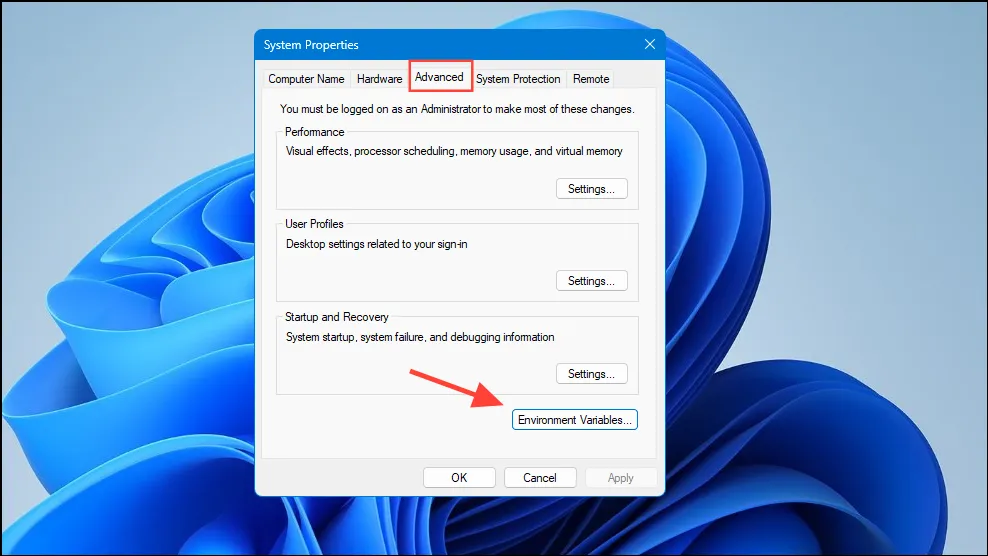

- Когато се отвори диалоговият прозорец Системни променливи, щракнете върху бутона „Променливи на средата“ в раздела „Разширени“.

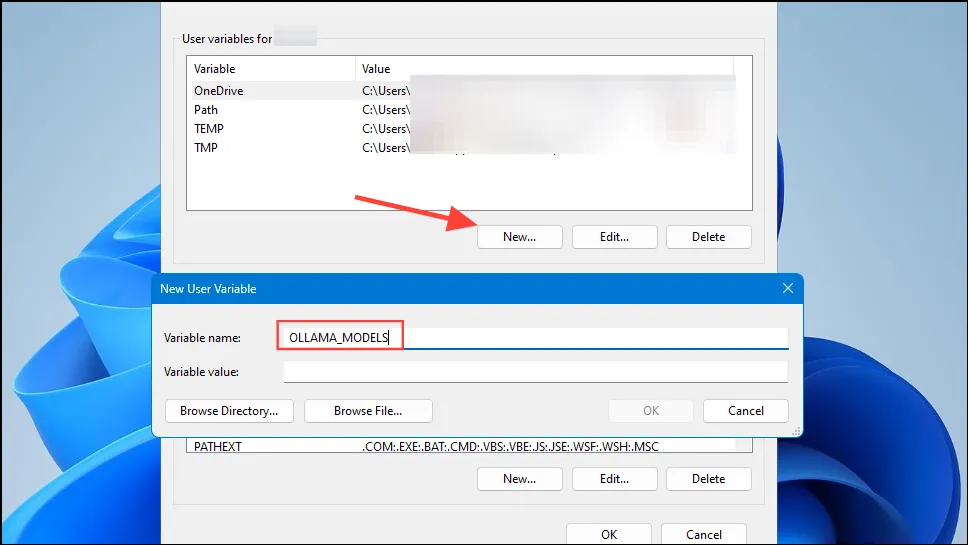

- Кликнете върху бутона „Нов“ за вашия потребителски акаунт и създайте променлива с име

OLLAMA_MODELSв полето „Име на променлива“.

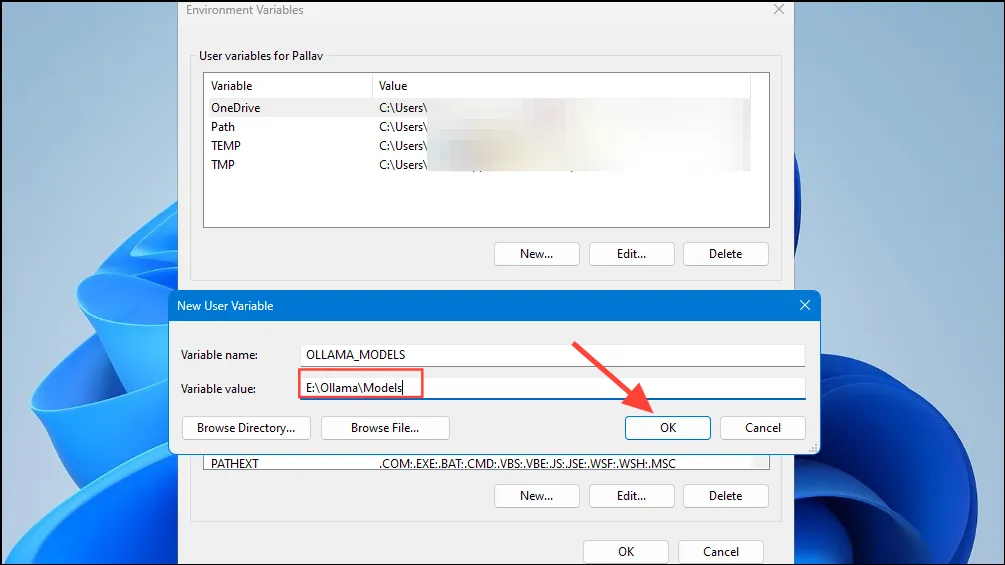

- След това въведете местоположението на директорията, където искате Ollama да съхранява своите модели в полето „Стойност на променливата“. След това щракнете върху бутона „OK“, преди да стартирате Ollama от менюто „Старт“.

- Сега сте готови да започнете да използвате Ollama и можете да направите това с Llama 3 8B на Meta, най-новият AI модел с отворен код от компанията. За да стартирате модела, стартирайте команден ред, Powershell или Windows Terminal прозорец от менюто „Старт“.

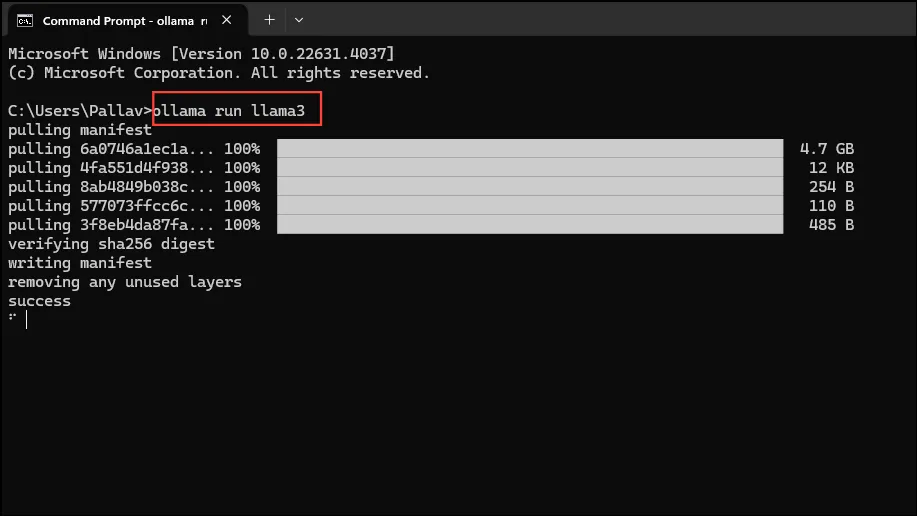

- След като се отвори прозорецът на командния ред, въведете

ollama run llama3и натиснете Enter. Моделът е близо 5 GB, така че изтеглянето му ще отнеме време.

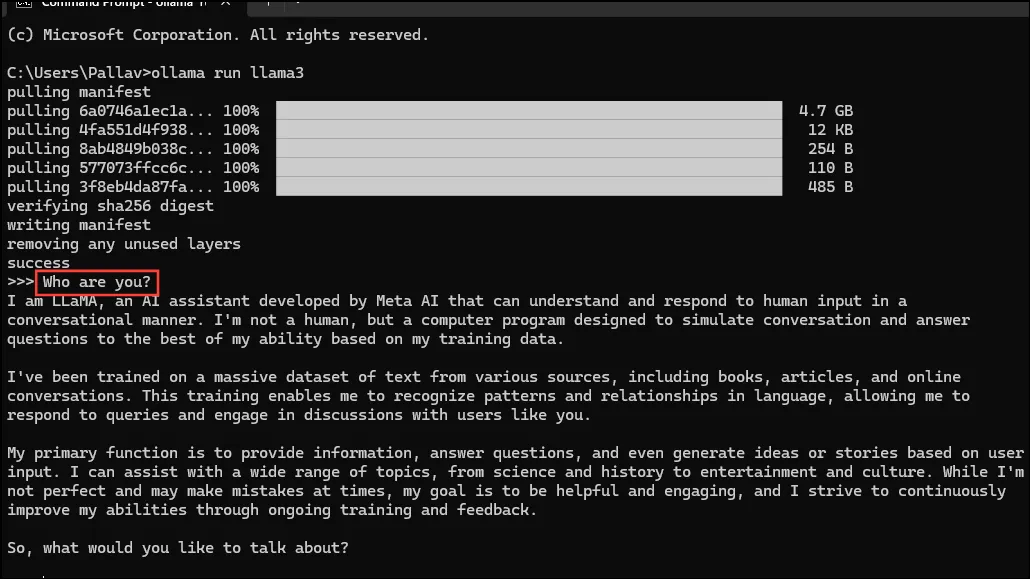

- След като изтеглянето приключи, можете да започнете да използвате Llama 3 8B и да разговаряте с него директно в прозореца на командния ред. Например, можете да попитате модела

Who are you?и да натиснете Enter, за да получите отговор.

- Сега можете да продължите разговора и да задавате въпроси на AI моделите по различни теми. Само имайте предвид, че Llama 3 може да прави грешки и да халюцинира, така че трябва да внимавате, когато го използвате.

- Можете също така да изпробвате други модели, като посетите страницата на библиотеката с модели Ollama. Освен това има различни команди, които можете да изпълните, за да изпробвате различни функции, предлагани от Ollama.

- Можете също така да извършвате различни операции, докато изпълнявате модел, като например задаване на променливи на сесията, показване на информация за модела, запазване на сесия и др.

- Ollama също ви позволява да се възползвате от мултимодални AI модели за разпознаване на изображения. Например моделът LLava може да разпознава изображения, генерирани от DALLE-3. Може да описва изображения в детайли.

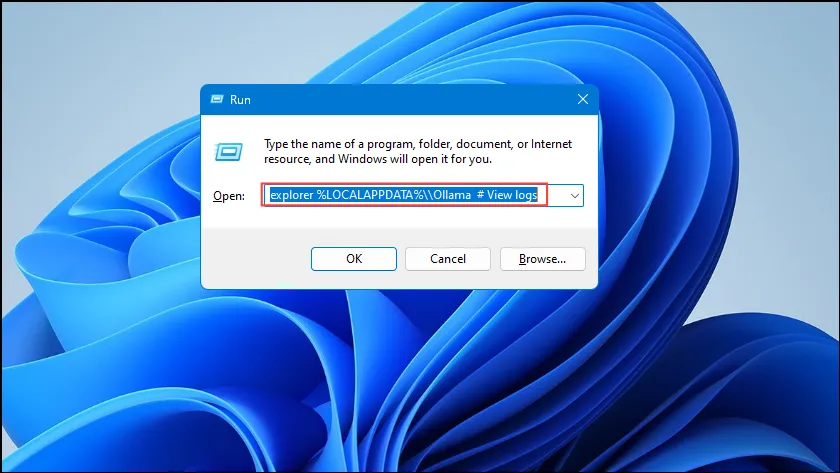

- Ако попаднете на грешки, докато изпълнявате Ollama, можете да проверите регистрационните файлове, за да разберете какъв е проблемът. Използвайте

Win + Rпрекия път, за да отворите диалоговия прозорец Run и след това въведетеexplorer %LOCALAPPDATA%\\Ollama # View logsв него, преди да натиснете Enter.

- Можете също да използвате други команди като

explorer %LOCALAPPDATA%\\Programs\\Ollamaиexplorer %HOMEPATH%\\.ollamaза проверка на двоичните файлове, модела и мястото за съхранение на конфигурацията.

Неща, които трябва да знаете

- Ollama автоматично открива вашия графичен процесор, за да изпълнява AI модели, но в машини с множество графични процесори може да избере грешния. За да избегнете това, отворете контролния панел на Nvidia и задайте дисплея на „Само Nvidia GPU“.

- Режимът на дисплея може да не е наличен на всяка машина и също така липсва, когато свържете компютъра си към външни дисплеи.

- В Windows можете да проверите дали Ollama използва правилния GPU с помощта на диспечера на задачите, който ще покаже използването на GPU и ще ви уведоми кой от тях се използва.

- Въпреки че инсталирането на Ollama на macOS и Linux е малко по-различно от Windows, процесът на стартиране на LLM през него е доста подобен.

Вашият коментар