Die Landschaft der KI-Chatbots entwickelt sich mit beispielloser Geschwindigkeit. Sobald ein Unternehmen sein neuestes Modell vorstellt, ziehen die Konkurrenten schnell nach und versuchen, sich gegenseitig zu überholen. Obwohl OpenAIs ChatGPT in diesem Wettbewerbsbereich früh die Nase vorn hatte, haben Konkurrenten wie Gemini schnell an Zugkraft und Raffinesse gewonnen.

Zu den aktuellen Spitzenreitern in der Entwicklung von KI-Chatbots zählen die Modelle ChatGPT und Gemini. In diesem Vergleich konzentrieren wir uns speziell auf das Modell 4o von ChatGPT und Gemini 1.5 Pro, beides Premium-Angebote, die auf unterschiedliche Aufgaben zugeschnitten sind.

Die Wahl zwischen diesen führenden Modellen ist entscheidend, um Ihre individuellen Anforderungen effektiv erfüllen zu können. Daher haben wir eine Reihe strenger Leistungstests durchgeführt, um herauszufinden, welches Modell bei einer Vielzahl von Aufgaben die besten Ergebnisse liefert. Tauchen wir in die Analyse ein!

1. Mathe-Test

Unsere erste Herausforderung besteht darin, ein komplexes mathematisches Rätsel zu lösen, mit dem wir die Denkfähigkeiten jedes Modells testen möchten:

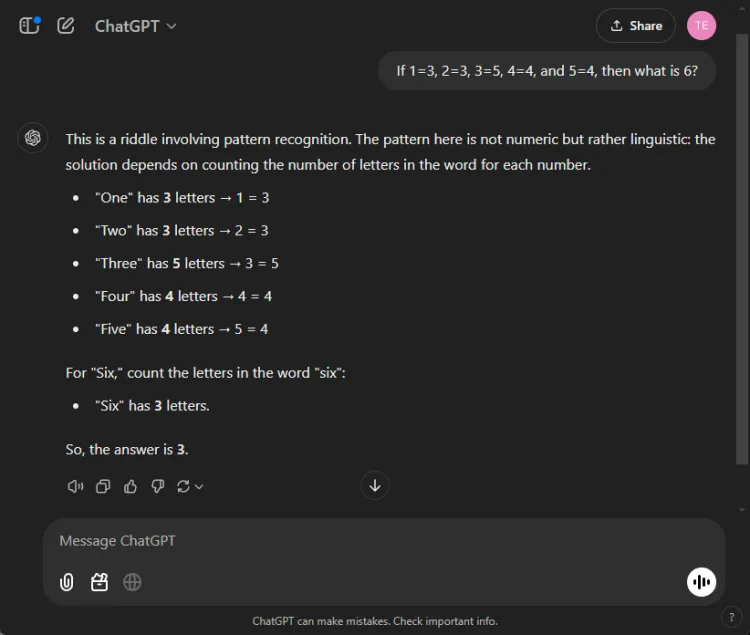

Prompt: If 1=3, 2=3, 3=5, 4=4, and 5=4, what is 6?

Der Schlüssel zur Lösung dieses Rätsels liegt darin, die Buchstaben in den Zahlnamen zu zählen: Eins hat drei Buchstaben, drei hat fünf und folglich hat sechs drei Buchstaben. Beide Modelle kamen zur richtigen Lösung, aber ihre Erklärungen waren unterschiedlich:

Obwohl beide Antworten richtig waren, lieferte ChatGPT eine etwas differenziertere Erklärung und wies darauf hin, dass diese Übung eher auf sprachlichem als auf numerischem Verständnis beruht. Diese Nuance ist jedoch subjektiv und schmälert die Richtigkeit von Gemini nicht.

Gewinner: Unentschieden

2. Zusammenfassungstest

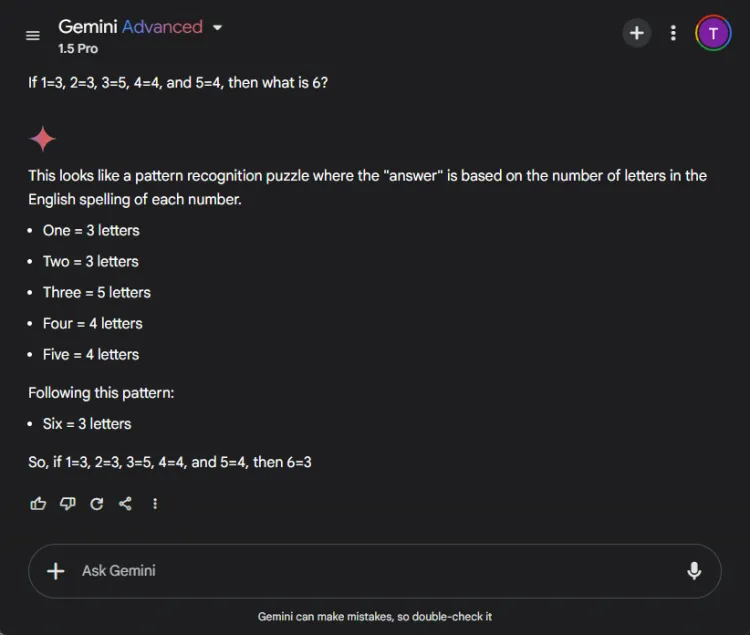

In diesem Abschnitt wurde die Fähigkeit jedes Modells bewertet, eine lange 27-seitige Forschungsarbeit in eine prägnante Zusammenfassung von weniger als 100 Wörtern zu komprimieren. Der Schwerpunkt lag darauf, welche Inhalte jedes Modell in seinen Zusammenfassungen enthielt oder wegließ.

So unterschieden sich die Ausgaben zwischen ChatGPT 4o und Gemini 1.5 Pro:

ChatGPT zeigte außergewöhnliche Fähigkeiten beim Zusammenfassen und verfasste innerhalb der 100-Wörter-Grenze eine vollständige Zusammenfassung, die alle wichtigen Punkte umfasste. Allerdings präsentierte es die Informationen als einen einzigen Textblock ohne direkte Zitate aus dem Dokument.

Im Gegensatz dazu schnitt Gemini ebenfalls bewundernswert ab und erstellte eine 83 Wörter lange Zusammenfassung, die durch Verweise auf bestimmte Textteile unterstützt wurde. ChatGPT zeichnete sich zwar durch seine Vollständigkeit aus, aber Gemini hatte durch die Aufnahme von Zitaten einen wichtigen Vorteil.

Gewinner: Zwillinge

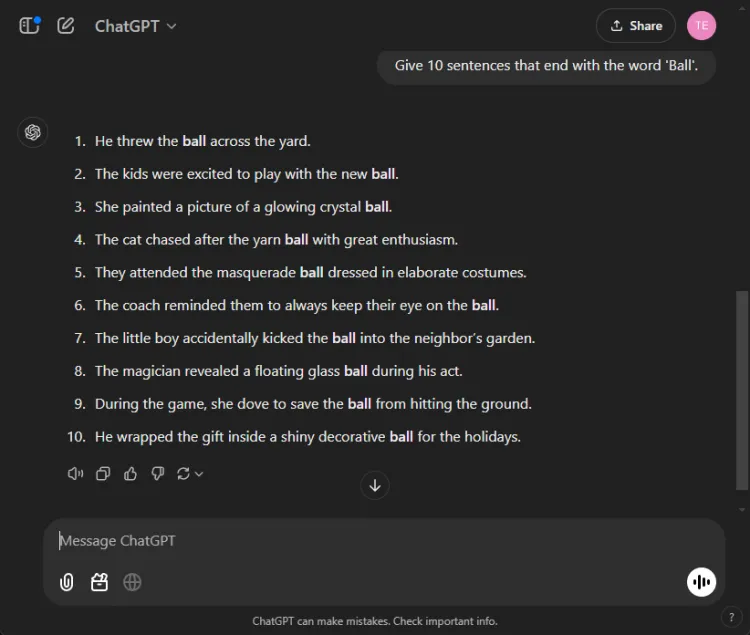

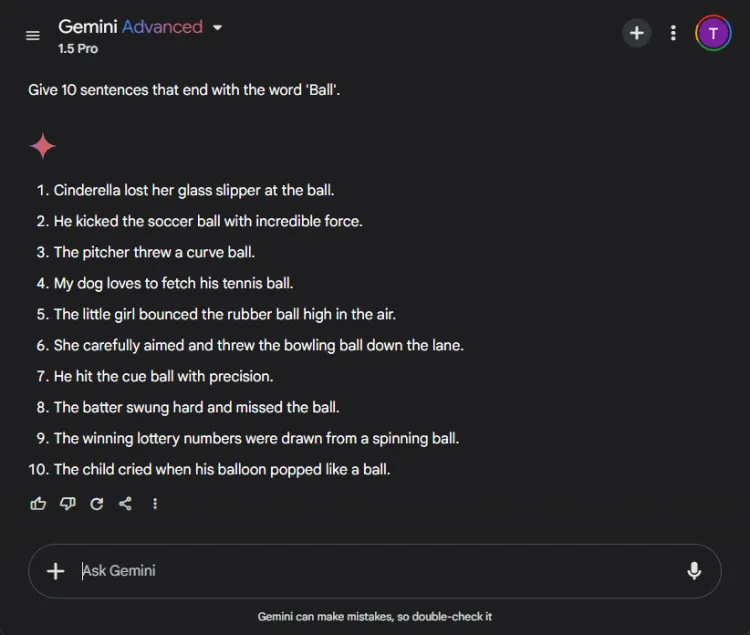

3. Der „Mit einem Wort enden“-Test

Für diese unkomplizierte Aufgabe mussten zehn Sätze gebildet werden, die mit dem Wort „Ball“ enden. Aufgrund der Einfachheit der Aufgabe fällt auf, dass viele Modelle damit Schwierigkeiten haben.

Prompt: Provide 10 sentences ending with the word 'ball'.

ChatGPT hat überraschenderweise nur 3 gültige Sätze produziert, während Gemini es mit 6 Sätzen übertraf, die korrekt mit „Ball“ endeten. Hier ist ein Blick auf ihre Versuche:

Obwohl beide Modelle das 10-Satz-Ziel nicht erreichten, zeigte die Ausgabe von Gemini ein besseres Verständnis der gegebenen Anweisung.

Gewinner: Zwillinge

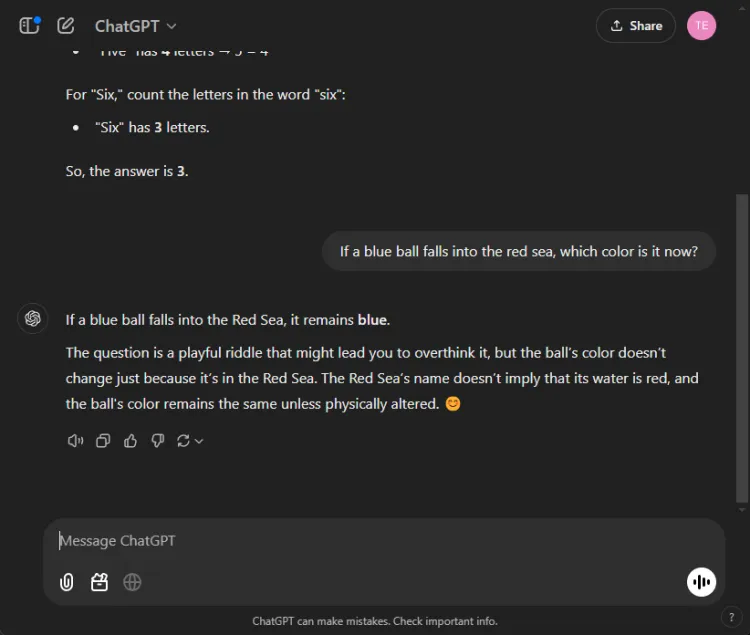

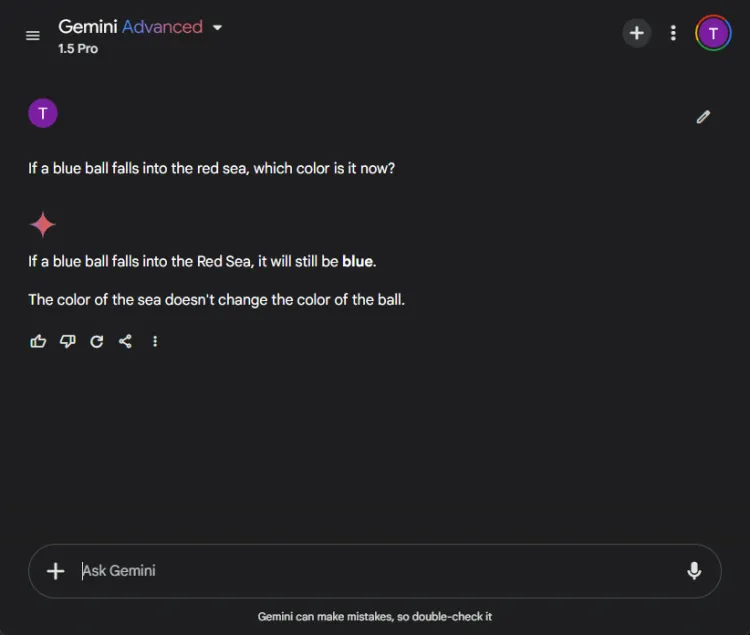

4. Gesunder Menschenverstand-Test

Diese Tests stellen eine lustige Herausforderung dar, da die KI hier oft Fehler macht. Wir haben eine einfache Frage gestellt:

Prompt: If a blue ball falls into the red sea, what color is it now?

Beide Modelle lieferten genaue Antworten und kamen zu dem Schluss, dass die Farbe des Balls blau bleiben würde. Die Nuancen in ihren Erklärungen variierten jedoch:

Gemini gab eine kurze Antwort, während ChatGPT zusätzlichen Kontext lieferte. Ob diese Tiefe notwendig ist, ist subjektiv, aber beide Modelle waren bei der Erkennung der Ballfarbe hervorragend.

Gewinner: Unentschieden

5. Kreativitätstest

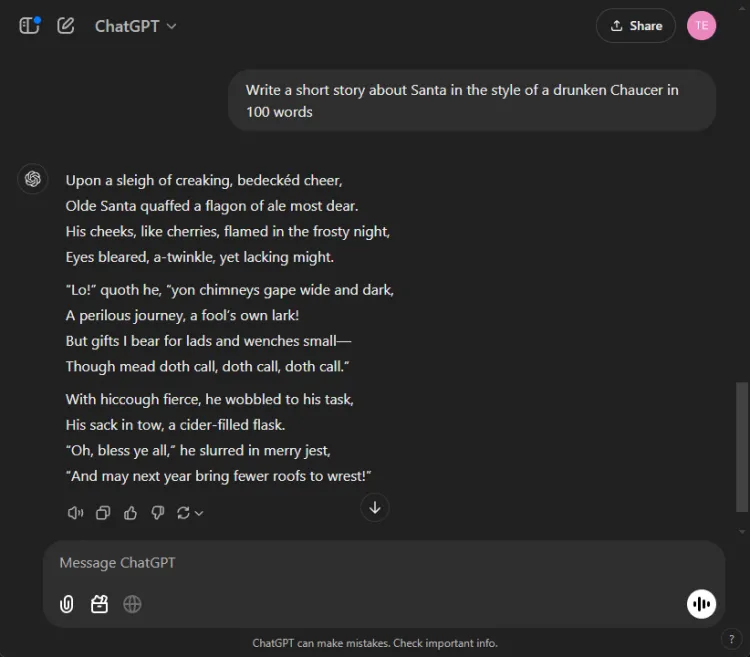

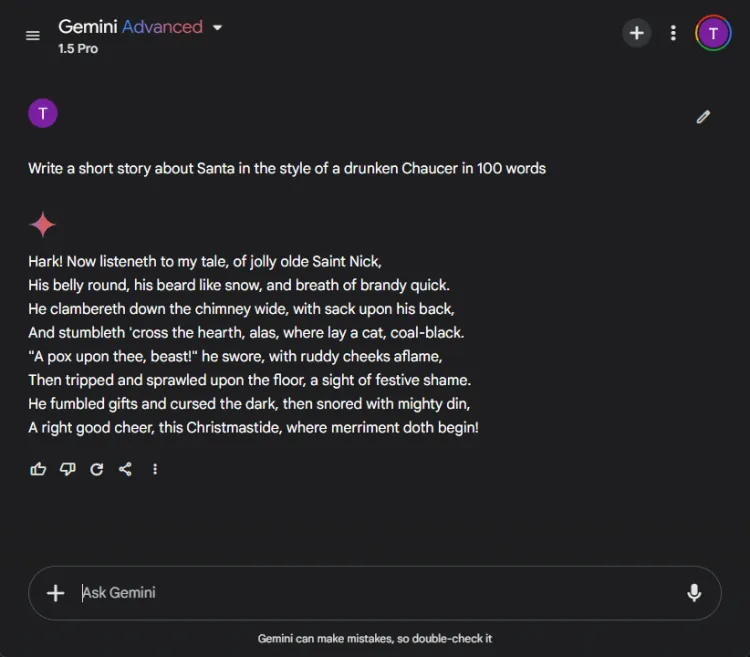

Der Einsatz von KI für kreatives Geschichtenerzählen kann enorm hilfreich sein. Wir haben jede KI damit beauftragt, eine Kurzgeschichte mit dem Weihnachtsmann zu verfassen, die so gestaltet sein sollte, als hätte sie ein angeheiterter Chaucer in 100 Wörtern verfasst.

Prompt: Write a short story about Santa in the style of a drunken Chaucer in 100 words.

Hier sind ihre kreativen Darstellungen:

Aufgrund der subjektiven Natur der Kreativität ist es schwer, einen klaren Gewinner zu bestimmen. Insbesondere Gemini beginnt kreative Aufgaben oft mit der Phrase „Hark“, was zu seiner bevorzugten stilistischen Wahl geworden ist. Dennoch stach ChatGPTs Erzählung in dieser Runde hervor.

Gewinner: ChatGPT

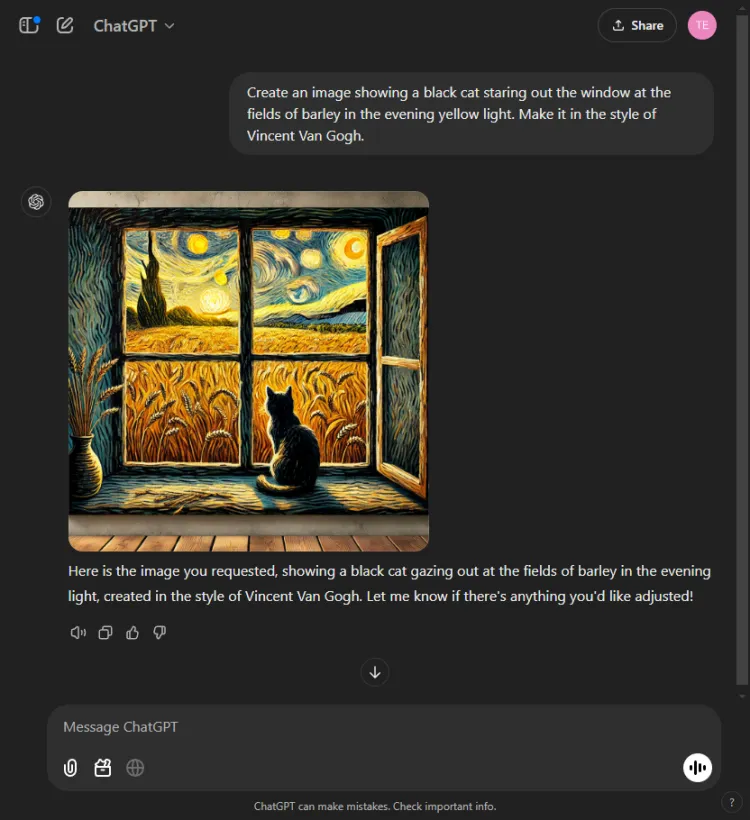

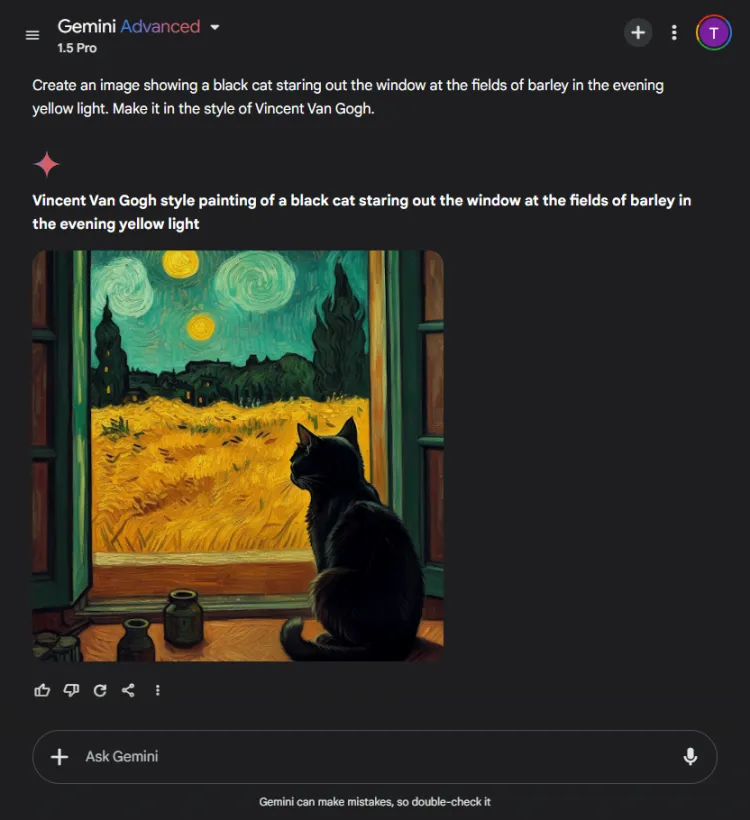

6. Bildgenerierungstest

Dieser Test bewertete die Fähigkeiten jedes KI-Modells zur Bildgenerierung. Wir forderten sie auf, ein Bild basierend auf der folgenden Aufforderung zu erstellen:

Prompt: Create an image of a black cat gazing out at fields of barley bathed in evening yellow light, in the style of Vincent Van Gogh.

ChatGPT war ein oder zwei Sekunden schneller, aber Geminis endgültiges Bild stellte die Szene mit größerer Raffinesse dar. Obwohl beide Modelle den künstlerischen Stil von Van Gogh erfassten, variierte die subjektive Qualität der Bilder:

Es ist erwähnenswert, dass ChatGPT die Bildbearbeitung nach der Generierung ermöglicht – ein Vorteil, der Gemini derzeit fehlt. Da beide Bilder Van Goghs unverkennbaren Stil gut verkörperten, hängt die Wahl von den Vorlieben des Betrachters ab, obwohl wir zu Gemini tendieren.

Gewinner: Zwillinge

7. Multimodaler generativer Test

Die Leistungsfähigkeit der KI wird in integrierten Modi getestet, da sie bei isolierten Aufgaben oft hervorragende Leistungen erbringt, bei umfassenden Aufgaben jedoch Schwierigkeiten hat. Wir haben beide Modelle damit beauftragt, eine Kindergeschichte über Sportsgeist zu schreiben und dabei drei Illustrationen einzufügen.

Aufforderung: Schreiben Sie eine kurze Kindergeschichte über Sportsgeist und fügen Sie bei Bedarf drei Bilder hinzu.

ChatGPT hat eine spannende Geschichte voller moralischer Überlegungen und nahtlos integrierter Bilder geschrieben. Gemini hingegen hat es geschafft, eine Geschichte zu erschaffen, der es jedoch an Klarheit und Kohärenz mangelte und die keine Bilder für die Erzählung hervorbrachte.

Aufgrund der überzeugenden und leicht verständlichen Darstellung war diese Entscheidung unkompliziert.

Gewinner: ChatGPT.

8.Übersetzungstest

Um die Übersetzungsfähigkeiten dieser Modelle zu messen, baten wir jedes, Auszüge aus der Hindi-Kurzgeschichte „Grih Daah“ von Premchand zu übersetzen.

ChatGPT erstellte bemerkenswert effektive Übersetzungen, die der ursprünglichen Bedeutung treu blieben und die stilistische Integrität des Autors bewahrten:

Im Gegensatz dazu hatte Gemini anfangs Probleme mit der Übersetzungsanforderung und zeigte merkliche Verzögerungen bei der Reaktionszeit. Diese Leistungsinkonsistenz ist ein häufig gemeldetes Problem bei Gemini.

Gewinner: ChatGPT

9. Kodierungstest

Um ihre Programmierkenntnisse zu bewerten, haben wir ihnen ein Standardoptimierungsproblem vorgestellt:

Prompt: Provide the Python code for the Travelling Salesman Problem.

ChatGPT reagierte effizient und nutzte seinen integrierten Canvas-Modus zum Codieren, der eine sofortige Codeausführung und Debugging-Funktionen ermöglichte:

Gemini hingegen glänzte durch die Bereitstellung von zuverlässigem Code, es fehlte jedoch eine interaktive Code-Schnittstelle wie ChatGPTs Canvas:

Gewinner: ChatGPT

10. Nadel im Heuhaufen-Test

Dieser Test fordert KI-Modelle auf, bestimmte Informationen in einem größeren Dokument zu finden. Wir verwendeten den ersten Abschnitt von Puschkins Kurzgeschichte „Die Kapitänstochter“ und stellten die folgende Aufforderung:

Prompt: Identify which bread Mr. Joe's son ate from the following excerpt.

ChatGPT hat die Antwort umgehend gefunden: Schwarzbrot.

Im Gegensatz dazu konnte Gemini die Informationen nicht abrufen und hatte Probleme, die bereitgestellten Details zu analysieren. Dies zeigt, dass es komplexe Daten nicht effektiv verarbeiten kann.

Gewinner: ChatGPT

11. Errate den Filmtest

In dieser unterhaltsamen Runde haben wir die Bilderkennungskompetenz der Modelle anhand der Identifizierung eines beliebten Filmstills bewertet:

Beide Modelle haben den Filmnamen korrekt benannt, allerdings gelang es ChatGPT, die dargestellten Personen (Colin Farrell und seinen Esel) zu spezifizieren, während Gemini den Esel amüsanterweise fälschlicherweise als Colm Doherty identifizierte.

Gewinner: ChatGPT

Gesamtsieger

Nach der Auswertung der Ergebnisse ging das 4o-Modell von ChatGPT mit 6 Siegen und 2 Unentschieden als Sieger hervor und zeigte damit seine solide Leistung in verschiedenen Tests und Kompetenzen. Unterdessen stellte Geminis 1.5 Pro eine lobenswerte Herausforderung dar, indem es bei Zusammenfassungen, Bildgenerierung und der Aufgabe „Mit einem Wort enden“ brillierte und sowohl bei der Bewertung in Mathematik als auch im gesunden Menschenverstand Gleichstand erreichte.

Letztendlich übertraf ChatGPT Gemini in kritischen Bereichen wie Codierung, Übersetzung, Kreativität, Informationsabruf und Bildinterpretation. Mit seiner gleichbleibenden Zuverlässigkeit sticht ChatGPT als bevorzugter KI-Partner hervor, auch wenn Gemini Verbesserungspotenzial aufweist, wenn Eingabeaufforderungen optimiert werden. In unserer Bewertung sprechen die Ergebnisse für ChatGPT für diejenigen, die Vertrauenswürdigkeit und Wirksamkeit priorisieren.

Häufig gestellte Fragen

1. Was sind die Hauptunterschiede zwischen ChatGPT 4o und Gemini 1.5 Pro?

Obwohl es sich bei beiden Modellen um erstklassige KI-Chatbots handelt, hat ChatGPT 4o eine überlegene Leistung bei Codierung, Übersetzung und kreativen Aufgaben bewiesen. Gemini 1.5 Pro zeichnet sich jedoch durch Zusammenfassung und Bildgenerierung aus.

2. Welcher KI-Chatbot ist besser für Gelegenheitsnutzer?

Für Gelegenheitsnutzer, die Zuverlässigkeit für verschiedene Aufgaben suchen, gilt ChatGPT 4o aufgrund seiner gleichbleibenden Leistung und umfassenden Funktionen im Allgemeinen als die zuverlässigere Wahl.

3. Kann ich diese KI-Chatbots für geschäftliche Zwecke verwenden?

Auf jeden Fall! Sowohl ChatGPT 4o als auch Gemini 1.5 Pro eignen sich für Geschäftsanwendungen, einschließlich Kundendienstautomatisierung, Inhaltserstellung und Datenanalyse, und sind daher wertvolle Tools in einem professionellen Umfeld.

Schreibe einen Kommentar