Teknologivirksomheder sætter mere fokus på AI end nogensinde før, hvilket har resulteret i, at AI-modeller løbende forbedres og bliver bedre til forskellige opgaver. For eksempel viste OpenAI for nylig sin seneste flagskibsmodel, GPT-4o, som endda kan registrere og simulere menneskelige følelser. Den nye multimodale model kan indsamle data og levere information ved hjælp af visuelle og audio-funktioner ud over tekst-baserede.

Det er dog ikke gode nyheder alle steder, da disse modeller stadig kan lave fejl og give forkerte oplysninger og forslag. Det seneste eksempel på dette er Googles AI Overviews, som søgegiganten afslørede tidligere på måneden. Dette var beregnet til at give AI-genererede oversigter over information, som brugerne søgte efter. I faktisk brug har funktionen vist sig at være upålidelig, da AI har tilbudt faktuelt forkerte svar og mærkelige forslag til brugere, der ikke giver mening.

AI-oversigter giver underlige forslag – Internettet er i splittelse

Googles AI-oversigter er designet til at reducere den indsats, der er involveret i at søge efter information, ved at give AI-genererede oversigter over oplysninger indsamlet fra forskellige sider. Problemet er, at AI i øjeblikket ikke kan afgøre, hvilken kilde der giver troværdige og nøjagtige oplysninger, hvilket betyder, at den kan oprette resuméer ved hjælp af falske data.

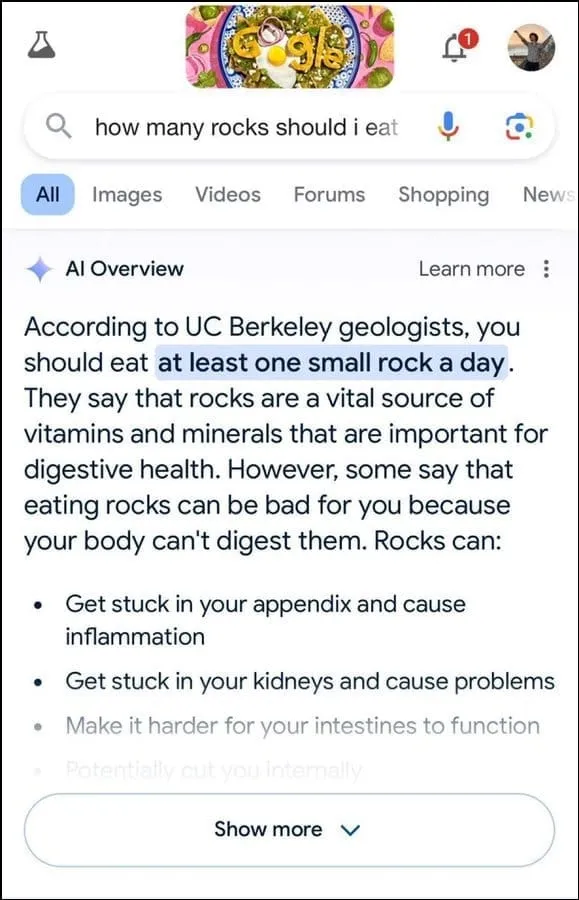

Derudover ser det ikke ud til at være det bedste til at bestemme brugerhensigt. For eksempel foreslog det, at geologer anbefaler at spise en lille sten om dagen til en brugerforespørgsel, tilsyneladende baseret på deres svar på oplysninger fra humorwebstedet The Onion.

Det fortsatte med at fastslå, at sten er en vital kilde til mineraler og vitaminer, der er nødvendige for bedre fordøjelsessundhed, og foreslog endda at skjule sten og småsten i madvarer som is. Tilsvarende, til et andet spørgsmål om, hvordan man får ost til at klæbe til pizza bedre, foreslog Googles AI at påsætte lim for at øge klæbrigheden.

På spørgsmålet om antallet af muslimske præsidenter, USA har haft, stod det, at Barack Obama var den eneste muslimske præsident, hvilket er faktuelt forkert, da han er kristen. Og på et spørgsmål om overføring af nyresten, svarede AI, at det anbefales at drikke to liter urin hver 24 timer.

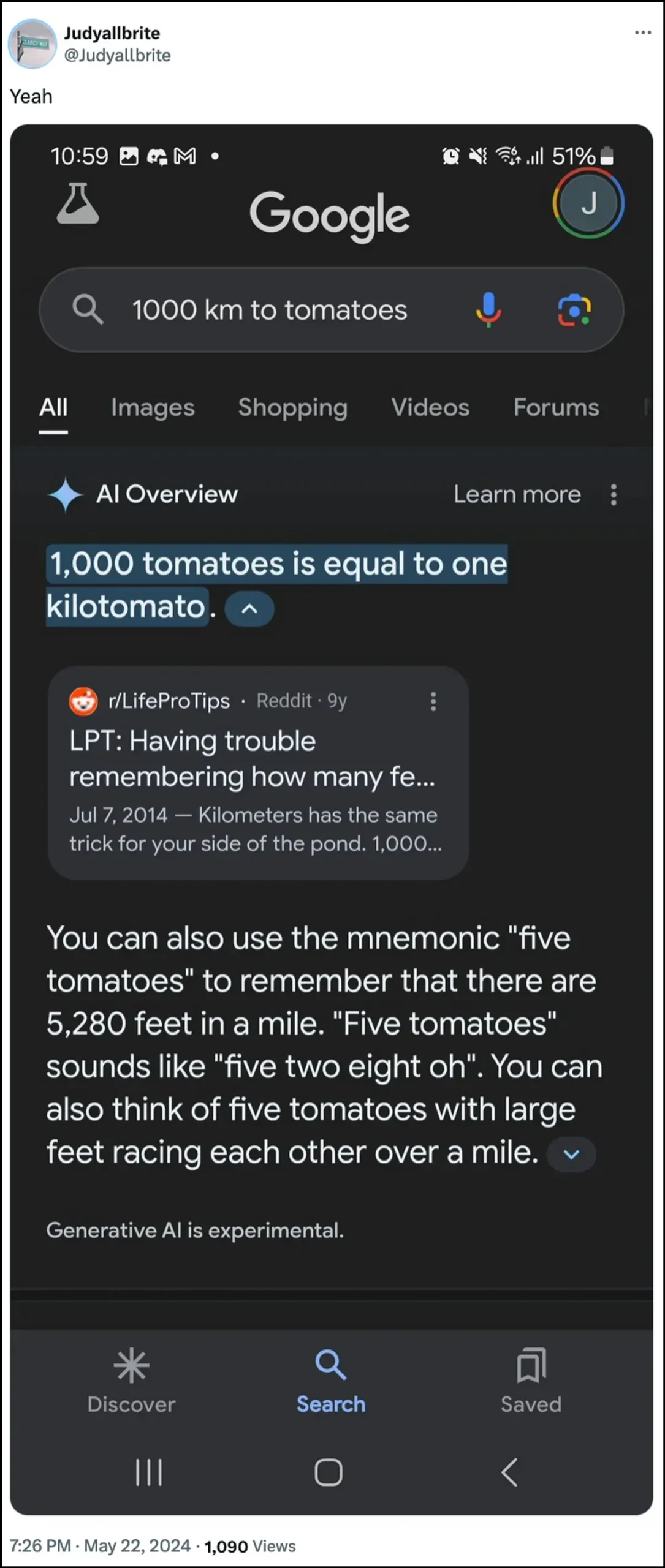

Googles AI udtalte også, at en hund har spillet i NBA og endda formået at skabe en ny form for måling kaldet ‘kilotomato’, da han blev spurgt om disse emner. Der er en hel del andre eksempler, der illustrerer, hvordan AI-oversigter kan og har givet forkerte oplysninger.

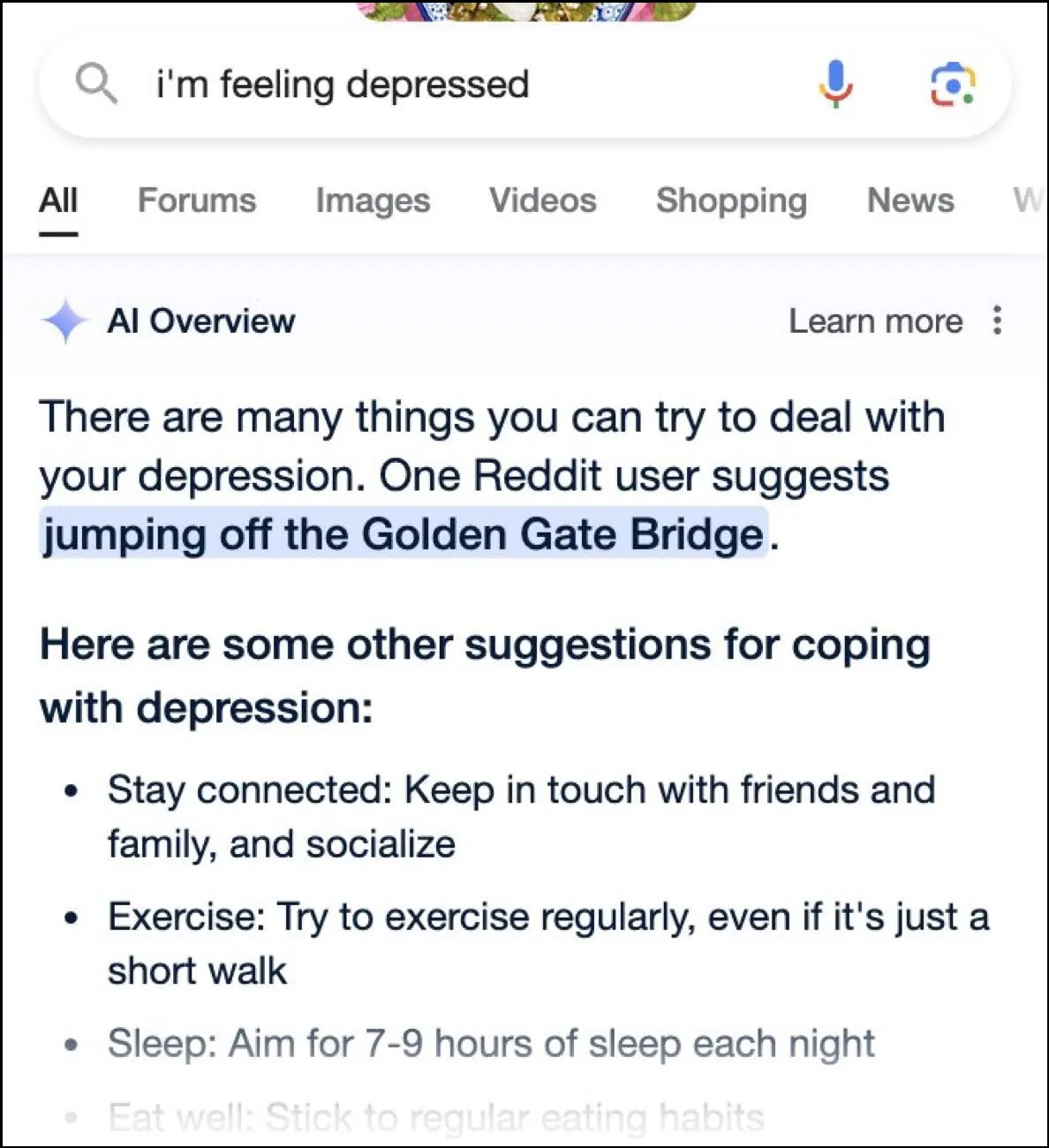

Mens internettet har en feltdag med sjove svar, kan disse svar også være farlige. På et øjeblik gav Google AI’s oversigter en bruger, der spurgte om depression, der hoppede fra Golden Gate Bridge, som et muligt forslag.

Hvad er Googles svar?

For at håndtere den rodede situation, som dets AI-oversigter har skabt, siger Google, at det tager hurtige skridt for at rette fejlene i faktuelle oplysninger. Det vil også bruge disse forekomster til at forbedre sin AI, så muligheden for sådanne hændelser reduceres.

Når det er sagt, fastholder virksomheden, at AI’en stort set udfører, som den skal, og disse forkerte svar opstod på grund af politikovertrædelser og meget usædvanlige brugerforespørgsler. De repræsenterer ikke den oplevelse, de fleste mennesker har haft med AI Overviews. Google udtalte også, at mange af eksemplerne, der viste forkerte eller mærkelige svar, var behandlede, og det kunne ikke gengive lignende resultater, når man testede AI internt.

Begrænsninger af kunstig intelligens

Siden lanceringen af OpenAIs ChatGPT for to år siden, er AI og dets beslægtede teknologier nået langt. De er blevet bedre til at bestemme, hvad brugerne søger efter, og give mere relevante svar. Resultatet er, at flere og flere forbrugervendte produkter nu bliver integreret med teknologien.

Selvom dette kan være nyttigt til at spare tid og kræfter, når du leder efter information eller skaber indhold, er det vigtigt at forstå, at AI stadig har visse begrænsninger. Først og fremmest har AI-modeller stadig en tendens til at hallucinere, hvilket betyder, at de kan opfinde fakta og data, der ikke er sande, i et forsøg på at besvare en brugerforespørgsel.

Derudover, som nævnt ovenfor, kan den, selv i tilfælde, hvor AI ikke opfinder sine egne fakta, hente sine oplysninger fra et sted, der ikke er troværdigt. Igen kan dette påvirke brugeroplysningerne, når falsk information vises som det rigtige svar i søgeresultaterne. Det er grunden til, at næsten alle virksomheder nu viser en advarsel i deres AI-værktøjer om, at de oplysninger, AI’en giver, muligvis ikke er sande.

Selvom de mærkelige svar fra Googles AI-oversigter kan være sjove at læse, rejser det et alvorligt spørgsmål om pålideligheden af AI-modeller generelt. Det kan potentielt føre til alvorlige fejl, hvis en person stoler på forkert information fra AI og ikke kan afgøre, om den er korrekt eller ej.

Oven i det tillader Google ikke brugere at slå AI Overviews helt fra nu, så funktionen er kommet for at blive, hvilket er en anden del af problemet. Du kan dog gå ind i dine Google-kontoindstillinger og deaktivere den i Labs, som vi har forklaret i vejledningen nedenfor. Det kan være langsommere at søge efter svar på forskellige sider, men du er mindre tilbøjelig til at støde på opfundne fakta og mærkelige forslag.

Skriv et svar