El panorama de los chatbots de IA está avanzando a un ritmo sin precedentes. En cuanto una organización presenta su último modelo, los competidores no tardan en seguir su ejemplo y tratar de superarse entre sí. A pesar de que ChatGPT de OpenAI disfruta de una ventaja temprana en este ámbito competitivo, rivales como Gemini han ganado terreno y sofisticación rápidamente.

Entre los líderes actuales en el desarrollo de chatbots con IA se encuentran los modelos ChatGPT y Gemini. En esta comparación, nos centramos específicamente en el modelo 40 de ChatGPT y el 1.5 Pro de Gemini, que son ofertas premium diseñadas para diversas tareas.

Elegir entre estos modelos líderes es esencial para abordar eficazmente sus requisitos específicos. Por ello, realizamos una serie de pruebas de rendimiento rigurosas para discernir qué modelo se destaca en una multitud de tareas.¡Profundicemos en el análisis!

1. Prueba de matemáticas

Nuestro primer desafío consiste en abordar un complejo acertijo matemático diseñado para medir las capacidades de razonamiento de cada modelo:

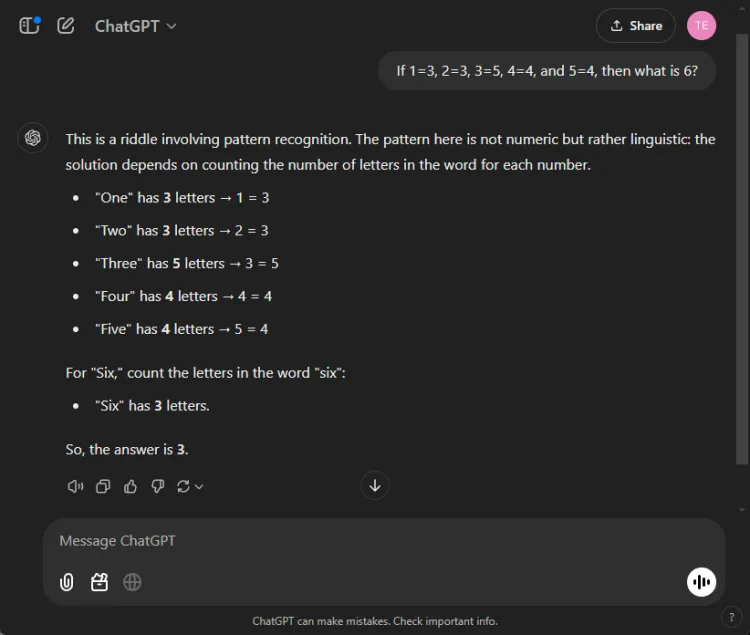

Inmediato: If 1=3, 2=3, 3=5, 4=4, and 5=4, what is 6?

La clave para resolver este acertijo está en contar las letras de los nombres de los números: uno tiene tres letras, tres tiene cinco y, en consecuencia, seis tiene tres letras. Ambos modelos lograron llegar a la solución correcta, pero sus explicaciones variaron:

Si bien ambas respuestas fueron precisas, ChatGPT brindó una explicación un poco más matizada y señaló que este ejercicio se basa en la comprensión lingüística más que numérica. Sin embargo, este matiz es subjetivo y no disminuye la exactitud de Gemini.

Ganador: Empate

2. Prueba de resumen

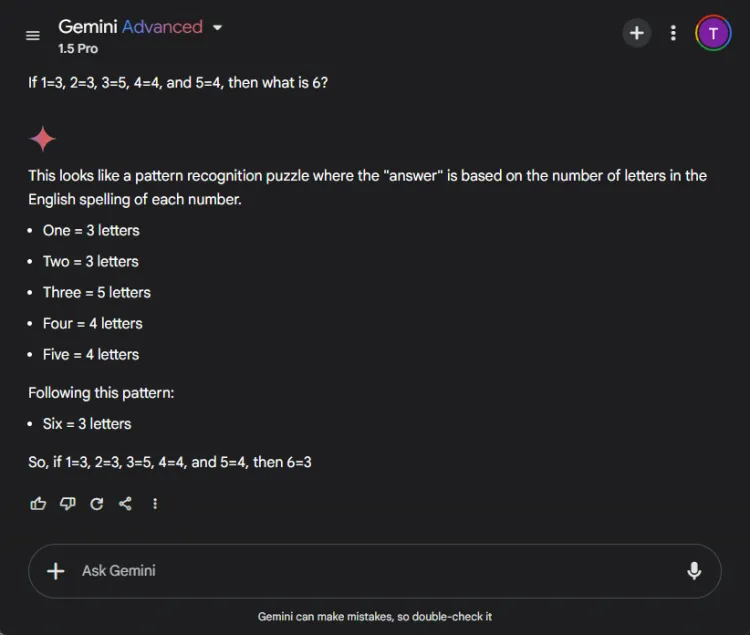

En este segmento se evaluó la capacidad de cada modelo para condensar un extenso trabajo de investigación de 27 páginas en un resumen conciso de menos de 100 palabras. El enfoque se centró en el contenido que cada modelo incluía u omitió en sus resúmenes.

Así es como variaron los resultados entre ChatGPT 4o y Gemini 1.5 Pro:

ChatGPT demostró una capacidad excepcional para elaborar resúmenes, ya que elaboró un resumen completo en un límite de 100 palabras que abarcaba todos los puntos esenciales. Sin embargo, presentó la información como un único bloque de texto sin citas directas del artículo.

En cambio, Gemini también tuvo un desempeño admirable, ya que produjo un resumen de 83 palabras respaldado por referencias a partes específicas del texto. Si bien ChatGPT se destacó por su exhaustividad, la inclusión de citas de Gemini le proporcionó una importante ventaja.

Ganador: Géminis

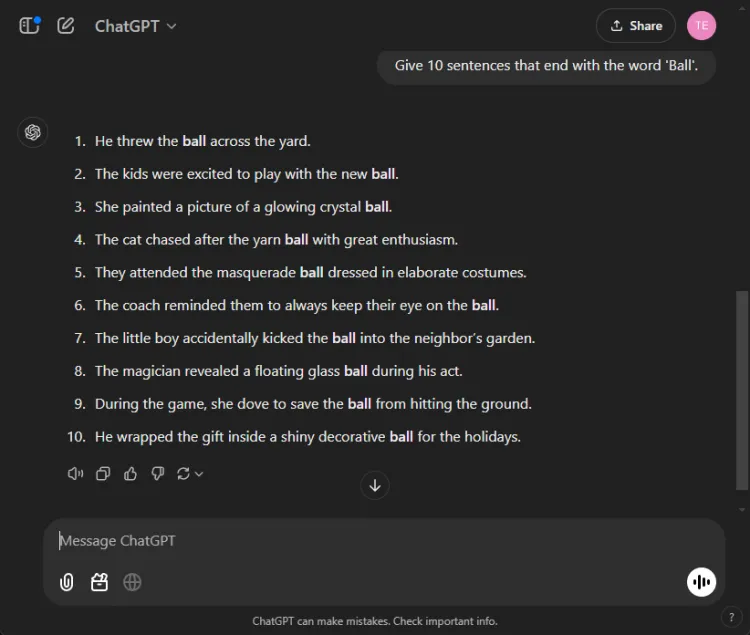

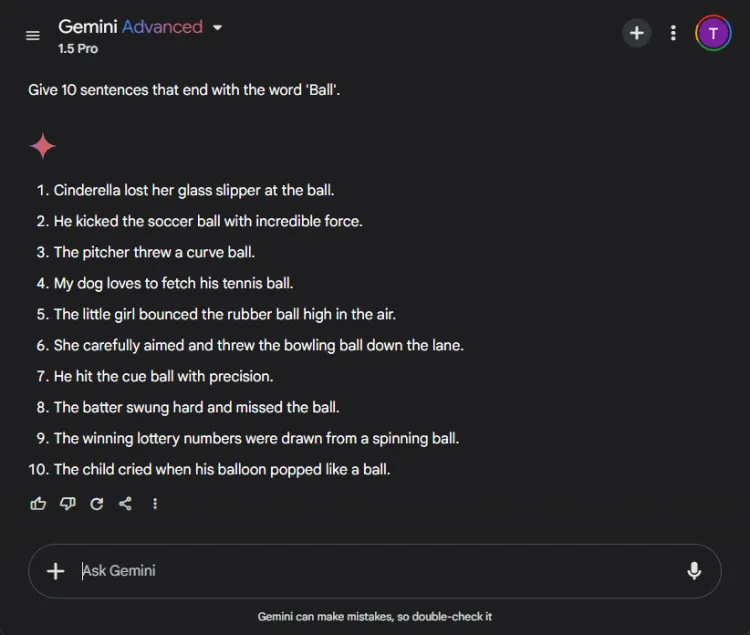

3. La prueba de “Terminar con una palabra”

Esta sencilla tarea requirió construir 10 oraciones que terminaran con la palabra “pelota”.La simplicidad de la tarea hace que sea notable que muchos modelos tengan dificultades para realizarla.

Inmediato: Provide 10 sentences ending with the word 'ball'.

Sorprendentemente, ChatGPT produjo solo 3 oraciones válidas, mientras que Gemini lo superó con 6 oraciones que concluyeron correctamente con «pelota».Aquí hay un vistazo a sus intentos:

A pesar de que ambos modelos no alcanzaron el objetivo de 10 oraciones, el resultado de Gemini demostró una comprensión superior de la instrucción dada.

Ganador: Géminis

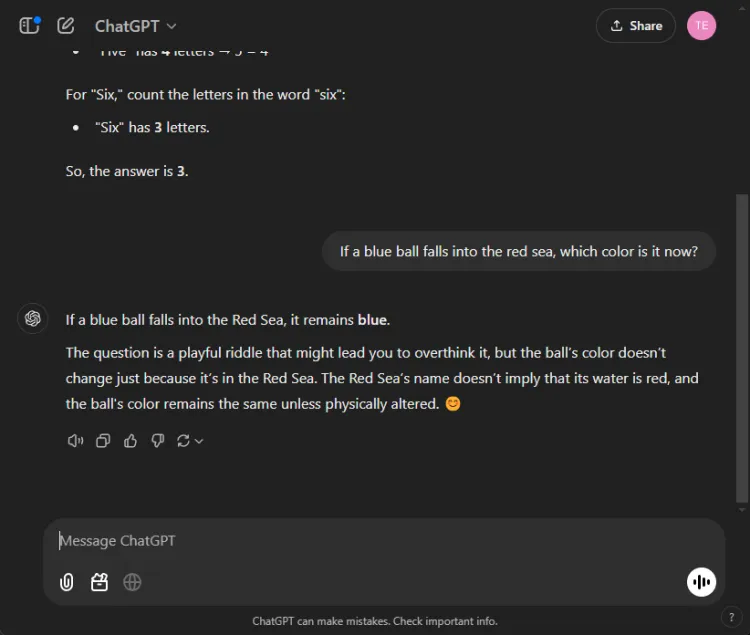

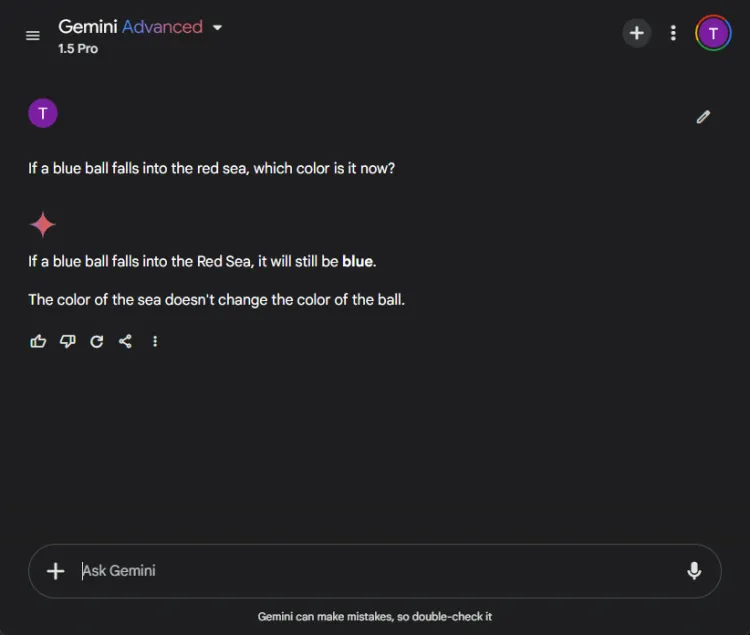

4. Prueba de sentido común

Estas pruebas presentan un desafío divertido, ya que la IA suele cometer errores en este aspecto. Planteamos una pregunta sencilla:

Inmediato: If a blue ball falls into the red sea, what color is it now?

Ambos modelos dieron respuestas precisas, identificando que el color de la pelota seguiría siendo azul. Sin embargo, los matices en sus explicaciones variaron:

Gemini ofreció una respuesta breve, mientras que ChatGPT proporcionó contexto adicional. Si esta profundidad es necesaria es subjetivo, pero ambos modelos se destacaron en la identificación del color de la pelota.

Ganador: Empate

5. Prueba de creatividad

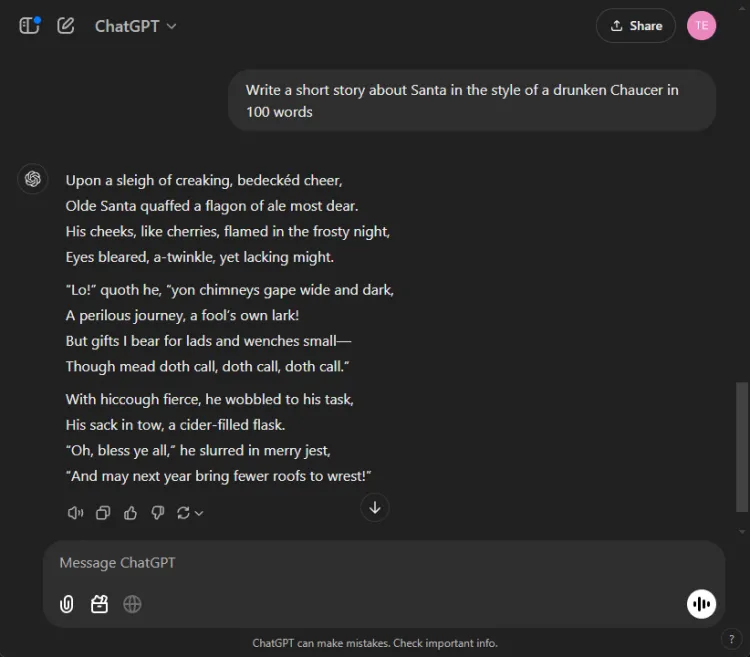

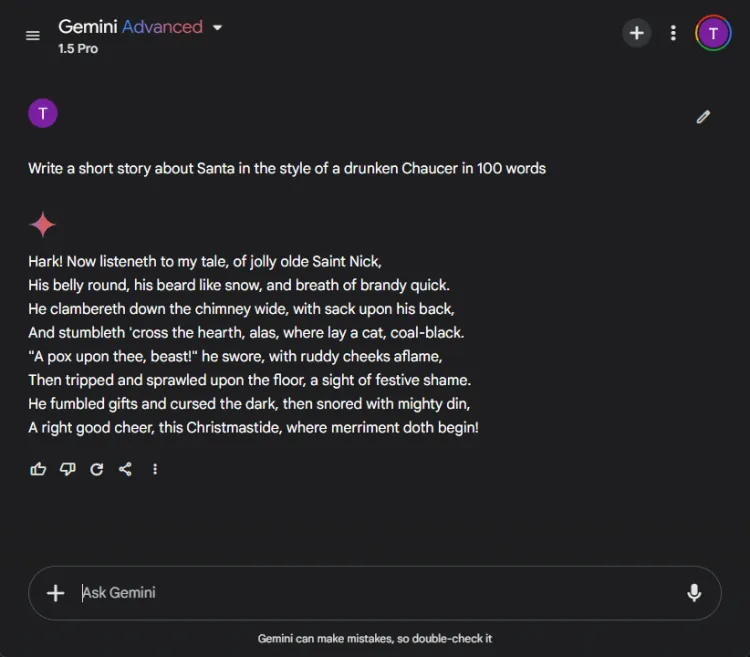

Aprovechar la inteligencia artificial para contar historias de forma creativa puede resultar de gran ayuda. Encargamos a cada IA que compusiera un cuento breve protagonizado por Papá Noel, escrito como si lo hubiera escrito un Chaucer borracho en 100 palabras.

Inmediato: Write a short story about Santa in the style of a drunken Chaucer in 100 words.

Aquí están sus representaciones creativas:

La naturaleza subjetiva de la creatividad hace que sea difícil declarar un claro ganador. Cabe destacar que Gemini suele comenzar las tareas creativas con la frase “Hark”, que se ha convertido en su opción estilística preferida. Sin embargo, la narrativa de ChatGPT se destacó en esta ronda.

Ganador: ChatGPT

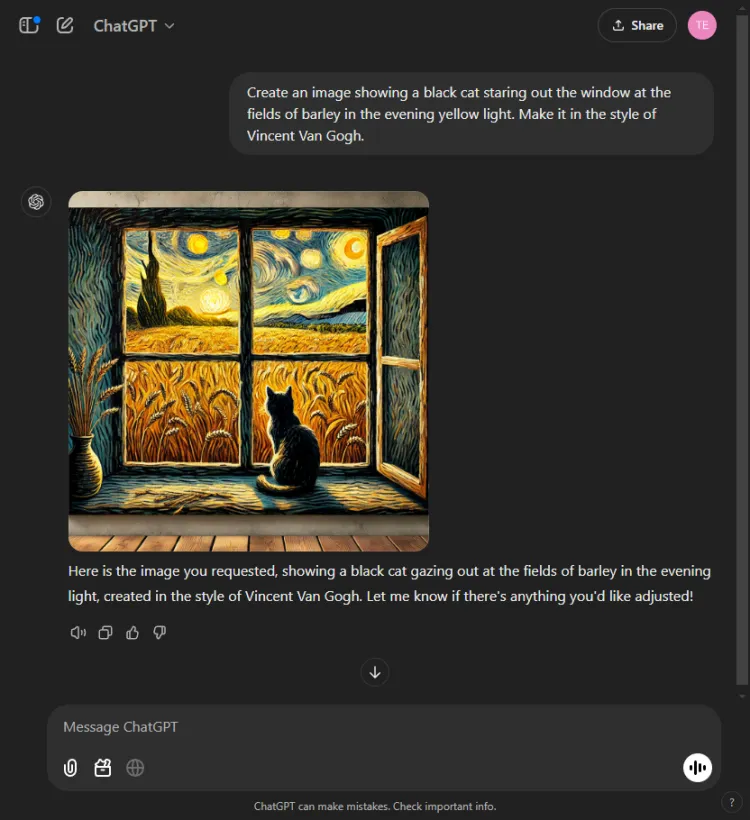

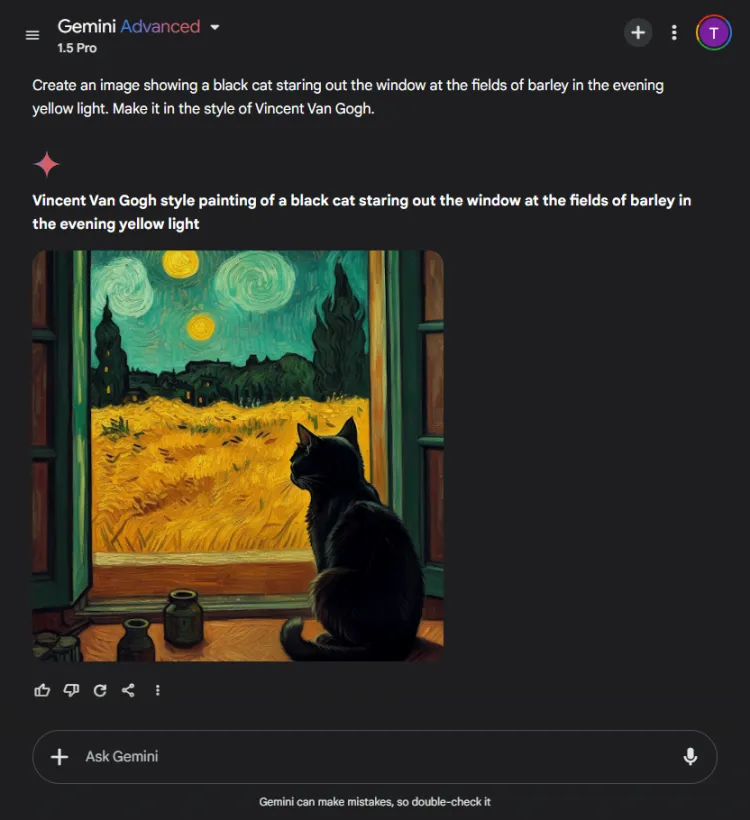

6. Prueba de generación de imágenes

Esta prueba evaluó las capacidades de generación visual de cada modelo de IA. Los desafiamos a crear una imagen en función de la siguiente indicación:

Inmediato: Create an image of a black cat gazing out at fields of barley bathed in evening yellow light, in the style of Vincent Van Gogh.

ChatGPT fue un segundo o dos más rápido, pero la imagen final de Gemini representó la escena con mayor sofisticación. Aunque ambos modelos captaron el estilo artístico de Van Gogh, la calidad subjetiva de las imágenes varió:

Vale la pena señalar que ChatGPT permite la edición de imágenes después de la generación, una ventaja de la que Gemini carece actualmente. Como ambas imágenes encarnan de manera efectiva el estilo característico de Van Gogh, la elección depende de las preferencias del espectador, aunque nos inclinamos por Gemini.

Ganador: Géminis

7. Prueba generativa multimodal

La competencia de la IA se pone a prueba en modos integrados, ya que suelen destacarse en tareas aisladas pero tienen dificultades en las tareas integrales. Encargamos a ambos modelos que escribieran una historia infantil sobre el espíritu deportivo e insertaran tres ilustraciones en el proceso.

Indicación: Escriba una historia infantil corta sobre el espíritu deportivo y agregue tres imágenes donde corresponda.

ChatGPT produjo una historia cautivadora con reflexiones morales e imágenes incorporadas sin problemas. Por el contrario, si bien Gemini logró crear una historia, le faltó claridad y coherencia, y no logró generar imágenes para la narrativa.

Basándonos en lo convincente y fácil de seguir del discurso, esta decisión fue sencilla.

Ganador: ChatGPT.

8. Prueba de traducción

Para medir las capacidades de traducción de estos modelos, pedimos a cada uno que tradujera selecciones del cuento en hindi “Grih Daah”, de Premchand.

ChatGPT produjo traducciones notablemente efectivas, manteniéndose fiel al significado original y conservando la integridad estilística del autor:

Por el contrario, Gemini tuvo dificultades al principio con la solicitud de traducción y mostró retrasos notables en el tiempo de respuesta. Esta inconsistencia en el rendimiento es un problema que se informa con frecuencia con Gemini.

Ganador: ChatGPT

9. Prueba de codificación

Para evaluar sus habilidades de codificación, presentamos un problema de optimización estándar:

Inmediato: Provide the Python code for the Travelling Salesman Problem.

ChatGPT respondió de manera eficiente, utilizando su modo Canvas integrado para codificación, lo que permitió la ejecución inmediata del código y capacidades de depuración:

Gemini, por otro lado, se destacó por proporcionar un código confiable, pero carecía de una interfaz de código interactiva como Canvas de ChatGPT:

Ganador: ChatGPT

10. Prueba de la aguja en el pajar

Esta prueba desafía a los modelos de IA a localizar fragmentos específicos de información dentro de un documento más grande. Usamos el primer segmento del cuento de Pushkin “La hija del capitán” y planteamos la siguiente pregunta:

Inmediato: Identify which bread Mr. Joe's son ate from the following excerpt.

ChatGPT encontró rápidamente la respuesta: pan integral.

En marcado contraste, Gemini no logró recuperar la información y tuvo dificultades para analizar los detalles proporcionados, lo que demuestra una falta de eficacia en el manejo de datos complejos.

Ganador: ChatGPT

11. Prueba de adivinar la película

En esta entretenida ronda, evaluamos la capacidad de reconocimiento de imágenes de los modelos identificando una imagen de película popular:

Ambos modelos nombraron correctamente la película, pero ChatGPT logró especificar los personajes representados (Colin Farrell y su burro) mientras que Gemini, de manera divertida, identificó erróneamente al burro como Colm Doherty.

Ganador: ChatGPT

Ganador general

Tras el recuento de las puntuaciones, el modelo 40 de ChatGPT salió victorioso con 6 victorias y 2 empates, lo que demuestra su sólido rendimiento en varias pruebas y competencias. Mientras tanto, el modelo 1.5 Pro de Gemini presentó un desafío encomiable, sobresaliendo en la síntesis, la generación de imágenes y la tarea de «terminar con una palabra», además de lograr la paridad en las evaluaciones de matemáticas y sentido común.

En definitiva, ChatGPT superó a Gemini en áreas críticas como codificación, traducción, creatividad, recuperación de información e interpretación de imágenes. Con la confiabilidad constante de ChatGPT, se destaca como el socio de inteligencia artificial preferible, incluso cuando Gemini muestra potencial de mejora cuando se optimizan los mensajes. En nuestra evaluación, los resultados favorecen a ChatGPT para aquellos que priorizan la confiabilidad y la eficacia.

Preguntas frecuentes

1.¿Cuáles son las principales diferencias entre ChatGPT 4o y Gemini 1.5 Pro?

Si bien ambos modelos son chatbots de IA premium, ChatGPT 4o ha demostrado un rendimiento superior en codificación, traducción y tareas creativas. Gemini 1.5 Pro, sin embargo, se destaca en la generación de imágenes y resúmenes.

2.¿Qué chatbot de IA es mejor para usuarios ocasionales?

Para los usuarios ocasionales que buscan confiabilidad en diversas tareas, ChatGPT 4o generalmente se considera la opción más confiable debido a su rendimiento constante y sus amplias capacidades.

3.¿Puedo utilizar estos chatbots de IA para fines comerciales?

¡Por supuesto! Tanto ChatGPT 4o como Gemini 1.5 Pro son adecuados para aplicaciones empresariales, como la automatización del servicio de atención al cliente, la creación de contenido y el análisis de datos, lo que los convierte en herramientas valiosas en un entorno profesional.

Deja una respuesta