OpenAI ha recentemente annunciato il suo modello GPT-4o, un nuovo modello di punta del motore che alimenta ChatGPT, il suo famoso chatbot basato sull’intelligenza artificiale rilasciato per la prima volta nel 2022. Questo modello più recente porta l’interazione uomo-computer a un livello completamente nuovo facendola sembrare più veloce e molto più naturale.

In GPT-4o, la “o” sta per “omni”, poiché combina testo, immagine e audio in un unico modello. Sebbene non ci siano miglioramenti nell’intelligenza e nel ragionamento rispetto al modello GPT-4 Turbo, ci sono molti nuovi aggiornamenti. È progettato per fornire risposte più rapide e dal suono più umano e può persino simulare le emozioni. È anche notevolmente più veloce nel comprendere gli input visivi e audio. In questo approfondimento, daremo uno sguardo alle funzionalità offerte da GPT-4o e a come rivoluzionerà il modo in cui interagiamo con gli assistenti AI. Quindi, unisciti a noi e iniziamo!

GPT-4o è significativamente più veloce

Il modello GPT-4o consente a ChatGPT di accettare input in varie forme, inclusi audio, testo, immagini o loro combinazioni. Può anche fornire risposte in diversi formati. La cosa più impressionante, tuttavia, è la velocità con cui fornisce le risposte.

Con il nuovo modello, ChatGPT impiega circa 320 millisecondi o anche meno per rispondere agli input audio, che è vicino al tempo impiegato da una persona per rispondere in una conversazione. Oltre a ciò, le prestazioni di GPT-4o sono simili a quelle di GPT-4 Turbo per quanto riguarda l’uso dell’inglese o la scrittura del codice.

Funziona molto meglio anche quando risponde a input basati su testo in lingue diverse dall’inglese ed è notevolmente più economico nell’API poiché è molto più efficiente del suo predecessore.

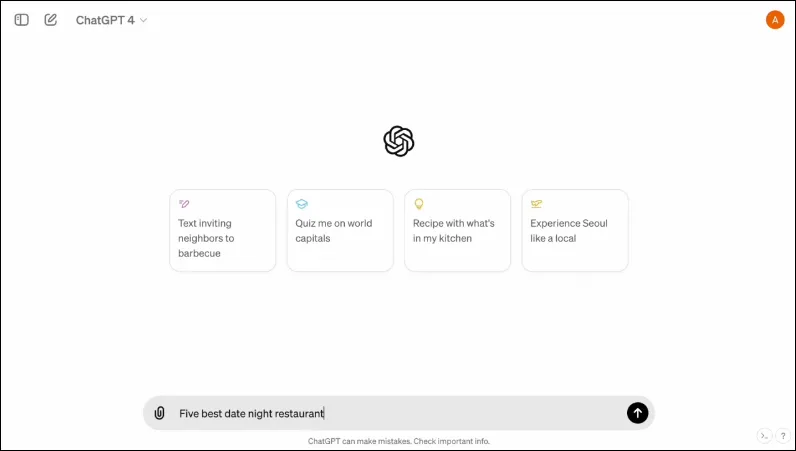

Ha anche una nuova interfaccia, progettata per rendere l’interazione più semplice e ordinata.

È multimodale

La modalità vocale esistente di ChatGPT è composta da tre modelli. Il primo accetta input basato su testo e fornisce output nello stesso formato, mentre il secondo converte l’input audio in testo, che viene accolto da ChatGPT per fornire output basato su testo. L’ultimo modello converte il testo in audio.

Tuttavia, questo progetto comporta una perdita di informazioni poiché il modello non può interagire direttamente con l’input audio o l’output presente che contiene elementi emotivi. Con GPT-4o, OpenAI ha costruito un unico modello multimodale in grado di comprendere diversi tipi di input ed elaborare direttamente l’output richiesto.

Attualmente supporta 50 lingue e sarà disponibile anche come API.

Può simulare le emozioni umane

Quando ChatGPT fu annunciato per la prima volta, per molte persone uno dei maggiori svantaggi del chatbot AI era che non poteva fornire risposte emotive. Con GPT-4o, ChatGPT può simulare le emozioni umane e fornire risposte adeguate che integrino tali emozioni.

Nelle demo condivise da OpenAI, il chatbot può essere visto ridere, cantare e persino mostrare sarcasmo quando richiesto. Questo è molto al di sopra di ciò che qualsiasi altro chatbot AI può fare attualmente e renderà le interazioni degli utenti molto più piacevoli. Secondo OpenAI, il nuovo modello consentirà a ChatGPT di rilevare anche gli stati d’animo degli utenti e fornire risposte adeguate sulla base di tali informazioni.

Combinata con la capacità di utilizzare input visivi, la capacità di fornire risposte emotive è una delle caratteristiche più impressionanti offerte dal nuovo modello.

Il nuovo modello può memorizzare una maggiore quantità di informazioni

Grazie a GPT-4o, ChatGPT ora può comprendere meglio le immagini, come grafici e foto, e anche memorizzare più informazioni sull’utente. Ciò si traduce anche in risposte che possono contenere parti di testo più grandi, il che può essere utile in diversi casi d’uso.

Ad esempio, puoi chiedere al chatbot di tradurre subito parti di testo più grandi e lui potrà aiutarti con la traduzione dal vivo. Poiché può utilizzare input visivi e audio insieme a quelli basati su testo, puoi utilizzarlo per raccogliere informazioni da screenshot, foto e altre immagini.

Poiché può memorizzare una maggiore quantità di informazioni senza che gli utenti debbano ripetere, GPT-4o consente agli utenti di partecipare a conversazioni avanti e indietro con il chatbot AI. Con maggiori informazioni, gli utenti possono aspettarsi che le conversazioni siano più sofisticate.

Misure di salvaguardia nel nuovo modello

Come i modelli GPT esistenti, GPT-4o è progettato tenendo presente alcune misure di sicurezza per garantire la sicurezza. I dati di addestramento sono stati filtrati e il comportamento del modello è stato perfezionato dopo l’addestramento. OpenAI ha anche valutato il modello di intelligenza artificiale rispetto a diversi parametri, come la sicurezza informatica e la persuasione, per evitare incidenti indesiderati.

Oltre a ciò, gli sviluppatori si sono avvalsi dell’aiuto di oltre 70 esperti in vari campi come la disinformazione e la psicologia sociale per identificare e mitigare i rischi che potrebbero verificarsi o aumentare con il nuovo modello. Continueranno inoltre a monitorare l’uso del chatbot per rischi futuri e ad intraprendere le azioni richieste come e quando necessario.

Per cominciare, OpenAI renderà disponibile solo una selezione limitata di preimpostazioni di modelli vocali. Terrà inoltre in considerazione il feedback fornito dagli utenti per migliorare il modello e garantire la completa sicurezza.

Disponibilità GPT-4o

Fino ad ora erano disponibili due versioni di ChatGPT: una versione gratuita che funzionava su GPT 3.5 e una versione a pagamento che funzionava su GPT 4.0 e costava $ 20 al mese. Quest’ultimo può accedere a un modello linguistico più ampio che gli consente di gestire maggiori quantità di dati.

GPT-4o sarà disponibile sia per gli utenti gratuiti che per quelli a pagamento e si prevede che verrà implementato sui dispositivi nelle prossime settimane. Sarà disponibile sui dispositivi mobili tramite l’app esistente, che verrà aggiornata, e sarà disponibile anche una nuova app desktop macOS oltre alla versione web per gli utenti desktop (la versione Windows arriverà entro la fine dell’anno).

Per distinguere tra utenti gratuiti e a pagamento, OpenAI offrirà agli utenti a pagamento una capacità cinque volte maggiore rispetto a quella offerta agli utenti gratuiti. Una volta esaurito il limite, tornerai a ChatGPT 3.5.

L’annuncio di OpenAI riguardante GPT-40 arriva appena un giorno prima della conferenza annuale degli sviluppatori I/O di Google, in cui si prevede che Google faccia i propri annunci relativi all’intelligenza artificiale. OpenAI ha anche promesso che sono in arrivo altri annunci, quindi non c’è dubbio che la competizione tra i due rivali sta appena iniziando a surriscaldarsi.

Anche se non sappiamo quando OpenAI svelerà ulteriori modifiche al suo modello AI, sappiamo che GPT-4o è destinato ai dispositivi che eseguono ChatGPT a livello globale. Quindi, tieni le dita incrociate e attendi che l’aggiornamento venga visualizzato sul tuo dispositivo. Fino alla prossima volta!

Lascia un commento