中国から登場した DeepSeek R1 AI モデルは、特に OpenAI の o1 モデルを上回るという主張により、AI 分野で大きな盛り上がりを見せています。DeepSeek R1 はオンラインで無料ですぐに入手できますが、この利便性はさまざまなプライバシーの懸念を引き起こします。データの保護に熱心でありながら、この AI モデルのパワーを活用したい場合は、デバイス上でローカルに実行するのが最適な選択肢です。

DeepSeek R1 には、1.5B、7B、14B、32B のパラメータを持つ蒸留バージョンや、巨大な 671B フラッグシップ モデルなど、いくつかのモデル バリエーションが用意されています。14B 以上の大型モデルを効果的に操作するには、マシンに堅牢な CPU、GPU、および専用の NPU が搭載されている必要があります。軽量モデルでも、スムーズなエクスペリエンスを実現するには、8 GB の RAM を搭載するだけで十分です。

LM Studio を使用して PC で DeepSeek R1 を実行する

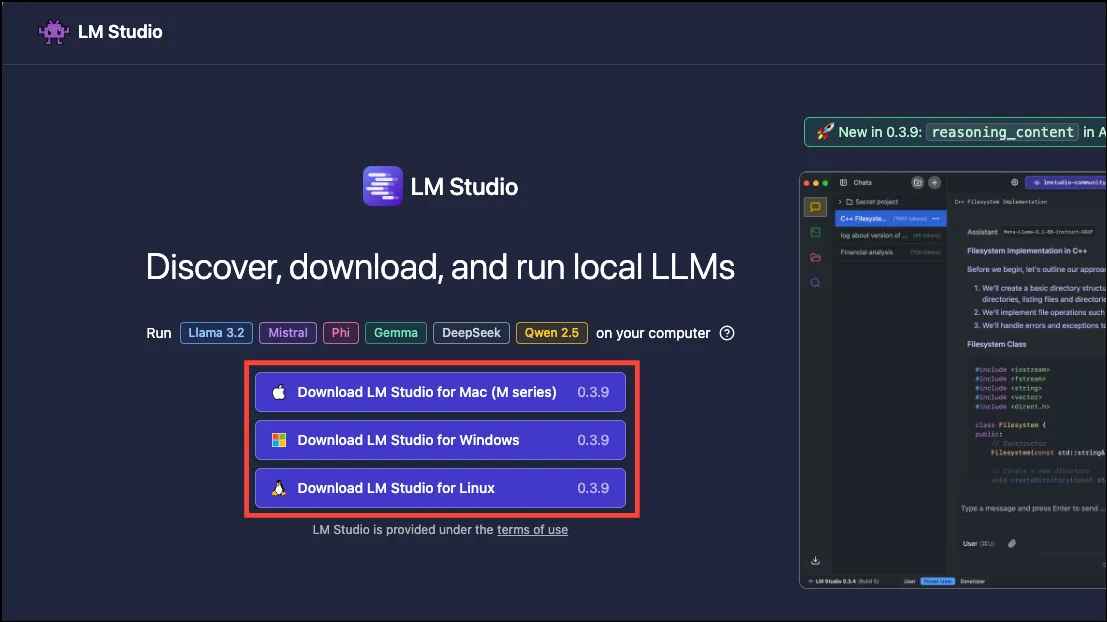

LM Studio は、Windows、macOS、Linux などのさまざまなオペレーティング システムで DeepSeek R1 をローカルに実行するための最もユーザーフレンドリーなオプションの 1 つを提供します。

**LM Studio でサポートされているシステムは次のとおりです:**

- **Mac:** macOS 13.4以降を実行するApple Siliconチップ(M1、M2、M3、M4)と互換性があります

- **Windows:** x64 と ARM アーキテクチャ (Snapdragon X Elite など) の両方をサポートします

- **Linux:** 64ビットアーキテクチャのUbuntu 20.04以降が必要です

LM Studio では、最適なパフォーマンスを得るために最低 16 GB の RAM を推奨していますが、小型モデルの場合は 8 GB でも対応できる可能性があります。192 GB 以上お持ちの場合は、671B のフル モデルを問題なく実行することもできます。

- まず、lmstudio.aiにアクセスし、システムに合わせて「ダウンロード」ボタンを選択します。

- ご使用のオペレーティング システムに応じたインストール ガイドに従ってください。

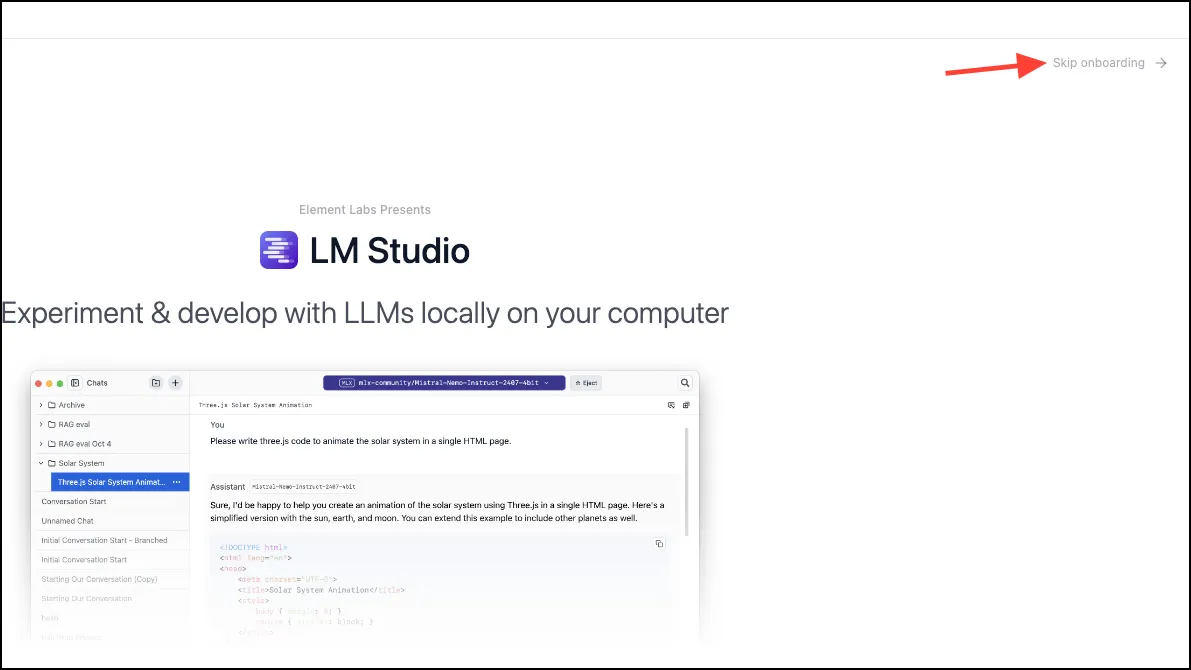

- インストール後、LM Studio を起動し、「オンボーディングをスキップ」を選択します。

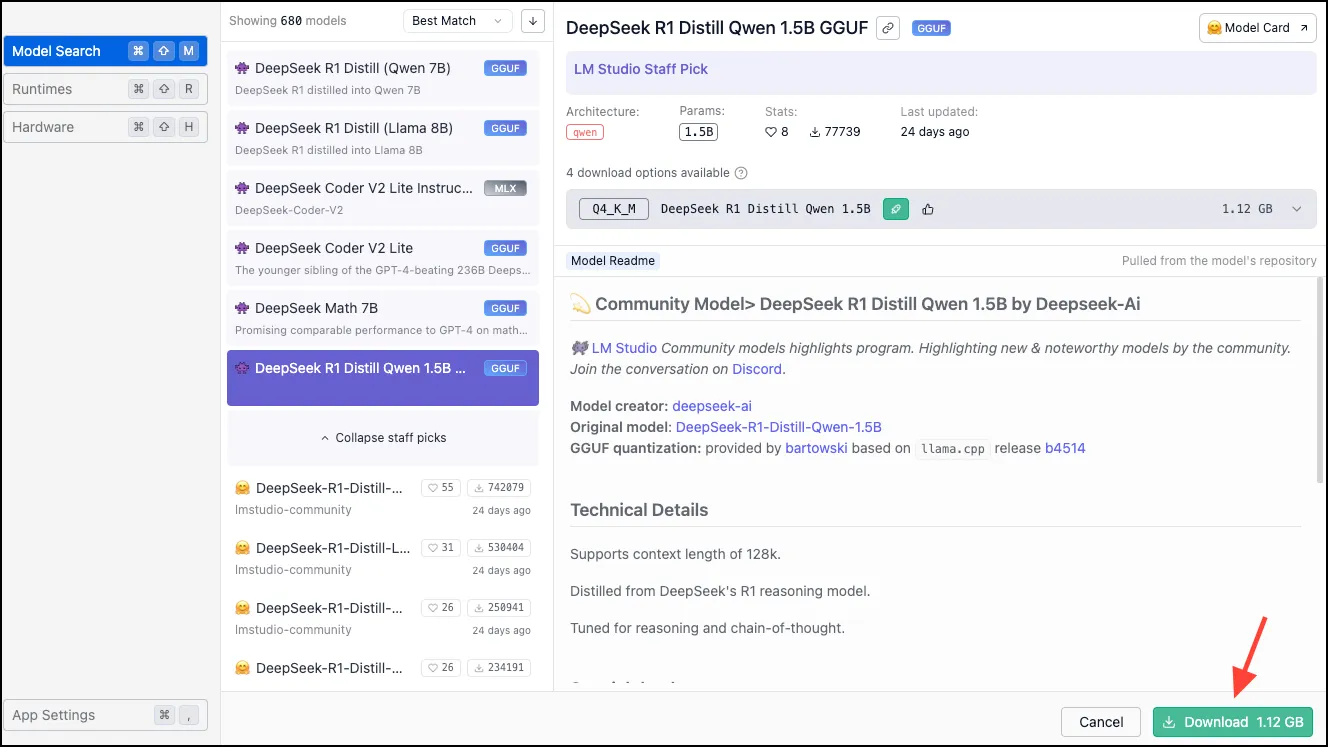

- 左側にあるナビゲーション メニューから「検索」アイコンを選択します。

- 次に、ダウンロードするモデルを検索します。ニーズに応じて、DeepSeek R1 Distill (Qwen 7B) または 1.5B モデルを選択できます。ダウンロード ページで指定されているように、十分なストレージがあることを確認してください。[ダウンロード] ボタンをクリックしてプロセスを開始します。

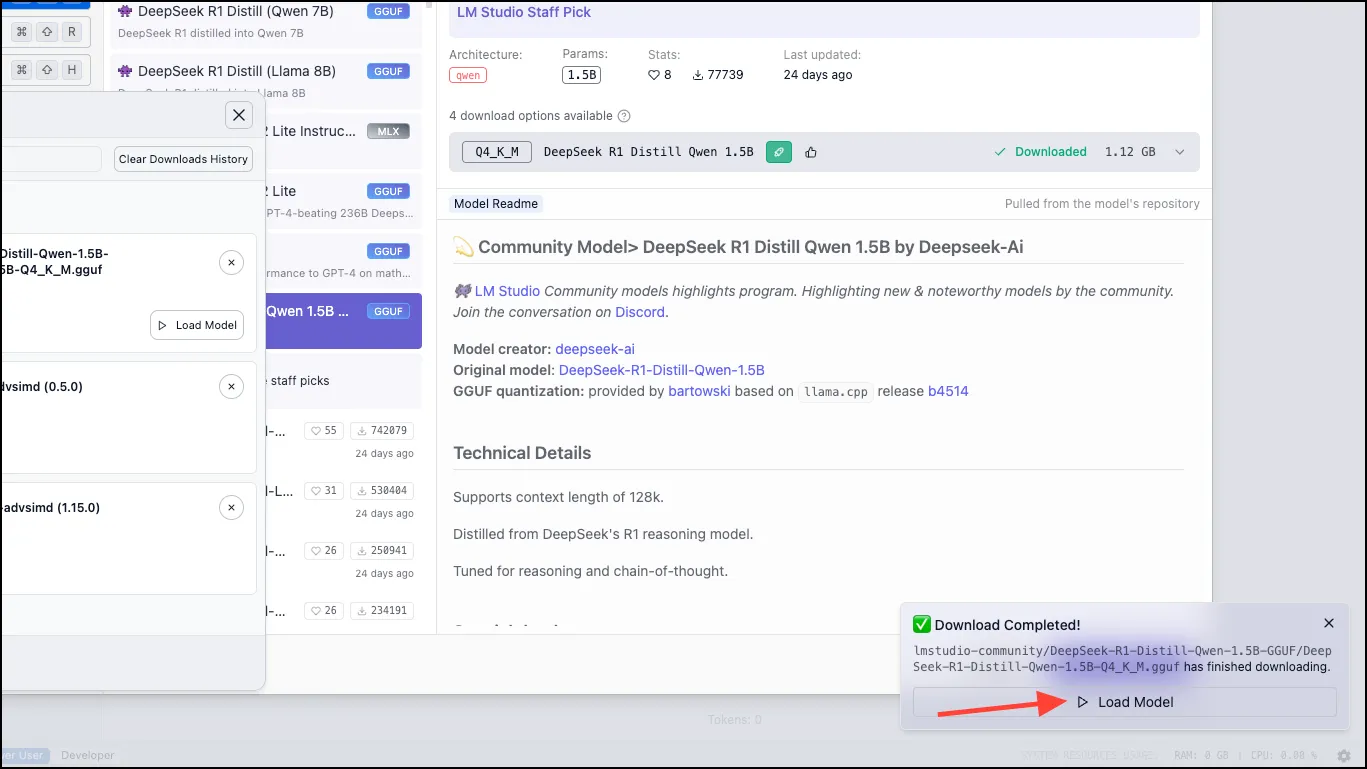

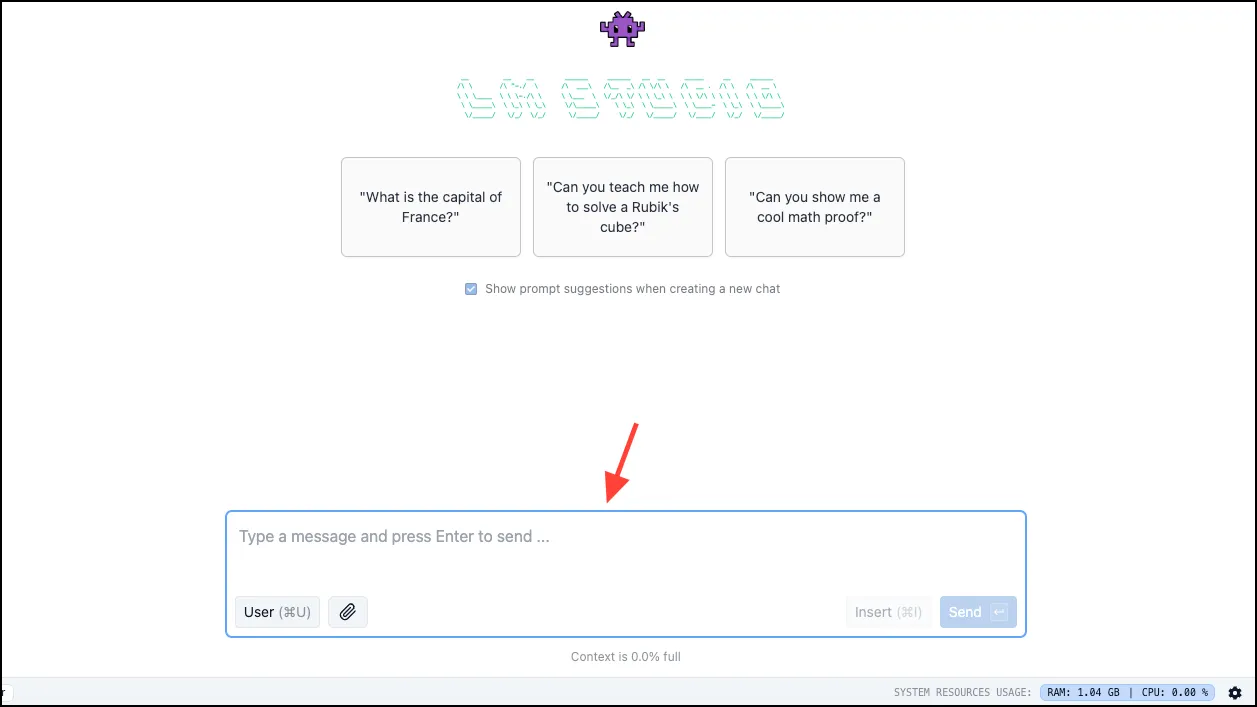

- ダウンロード後、「モデルのロード」ボタンをクリックすると、チャット ウィンドウがポップアップ表示されます。

- チャット ウィンドウにクエリを入力し、ローカルでモデルと対話します。ステータス バーの右下隅に表示されるリソース使用状況メトリックを追跡できます。

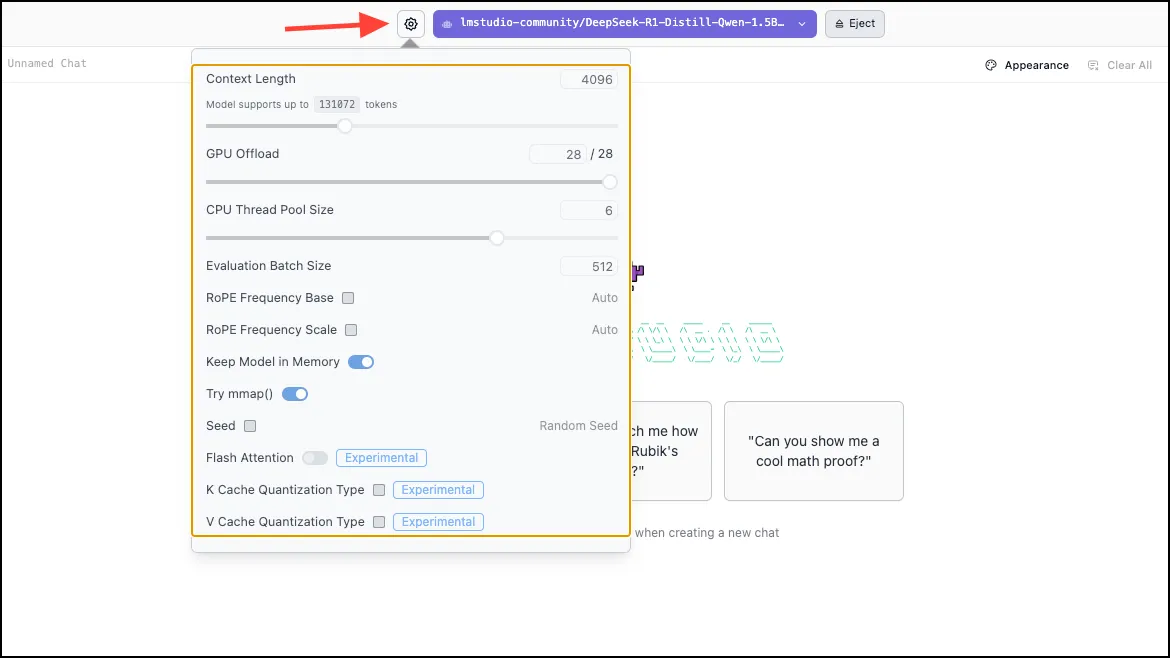

- モデル設定を調整するには、上部のモデル名の横にある「設定」アイコンをクリックします。

LM Studio を使用して DeepSeek R1 を PC 上でローカルに実行するのは簡単で、ターミナル コマンドも必要ありません。この技術を初めて使用する人にとっては理想的なオプションです。Ollama などの代替手段もありますが、ターミナル スキルが必要です。

PocketPal AI を使ってモバイル上で DeepSeek R1 をローカルに実行する

モバイル デバイスで LLM モデルを操作したい場合は、PocketPal AI を強くお勧めします。このアプリは、iOS と Android の両方のプラットフォームで LLM モデルをシームレスに実行できるエクスペリエンスを提供します。

- App Storeまたは Play ストアから PocketPal AI アプリをダウンロードします。

- アプリを起動し、「モデルへ移動」をタップします。

- 画面の右下にある「+」アイコンをタップします。

- 「ハグ顔から追加」を選択します。

- 検索フィールドに「DeepSeek R1」と入力して、インストールするモデルを見つけて選択します。

- 利用可能な GGU ファイルの 1 つに隣接するダウンロード アイコンをクリックします。

- ダウンロードが完了したら、メイン画面に戻り、ダウンロードしたモデルの横にある「ロード」アイコンを選択します。

- モデルが読み込まれ、チャットを開始できるようになります。左側のメニューからチャット履歴にアクセスしたり、モデルの設定を変更したりできます。

これで完了です。デバイスの選択に関係なく、LM Studio または PocketPal AI を利用することで、DeepSeek R1 モデルをローカルで簡単にセットアップして実行できます。

よくある質問

1. DeepSeek R1 を実行するためのシステム要件は何ですか?

DeepSeek R1 を実行するには、1.5B や 7B などの小型モデルでは少なくとも 8 GB の RAM が必要です。大型モデルでは、16 GB 以上が推奨されます。最適なパフォーマンスを得るには、堅牢な CPU と GPU、および十分なストレージ容量も不可欠です。

2. DeepSeek R1 をモバイル デバイスで実行できますか?

はい!iOS と Android の両方で利用可能な PocketPal AI アプリを使用して、モバイル デバイスで DeepSeek R1 を実行できます。このアプリを使用すると、モデルを検索して携帯電話に直接ダウンロードできます。

3. DeepSeek R1 をオンラインで使用する場合、プライバシーに関する懸念はありますか?

はい、DeepSeek R1 をオンラインで実行するとプライバシーに関する懸念が生じる可能性があります。代わりにデバイス上でモデルをローカルに実行することを選択すると、データが外部サーバーに送信されないため、これらのリスクが軽減されます。

コメントを残す