多くのブラウザが AI 機能をブラウザに統合している中、Opera はローカル AI モデルを統合した最初のブラウザになりました。Opera は、約 50 種類のモデル ファミリから 150 種類を超えるローカル大規模言語モデル (LLM) バリアントの実験的なサポートを Opera One ブラウザに追加しています。

言語モデルはローカルなので、ユーザーは自分のデータが LLM のサーバーに送信されることを心配する必要がありません。これは AI を使用するプライベートかつ安全な方法です。

ローカル LLM モデルを使用するには、使用するバージョンに応じて、コンピューターに 2 ~ 10 GB の空き容量が必要です。サポートされている LLM には、Meta の Llama、Microsoft の Phi-2、Google の Gemma、Vicuna、Mistral AI の Mixtral などがあります。Opera の Aria AI の代わりにこれらの言語モデルを使用し、いつでも Aria AI に切り替えることができます。

この機能は現在、Opera One の開発者ストリームでのみ利用可能です。Opera One Developer でローカル AI モデルを有効化して使用する方法は次のとおりです。

Opera One Developerをダウンロード

Opera One Developer をすでにお持ちの場合は、このセクションをスキップして、ローカル LLM モデルの使用に直接進んでください。

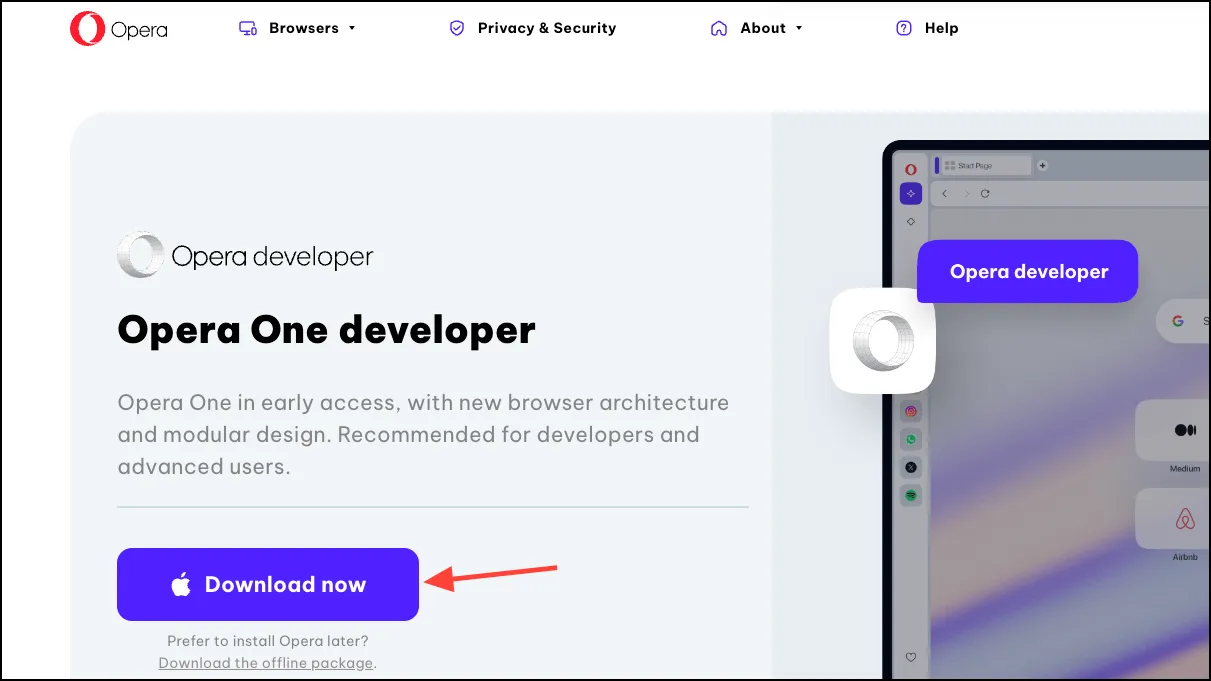

- Opera One Developer をダウンロードするには、このリンクにアクセスしてください。下にスクロールして、Opera One Developer タイルの「今すぐダウンロード」をクリックします。

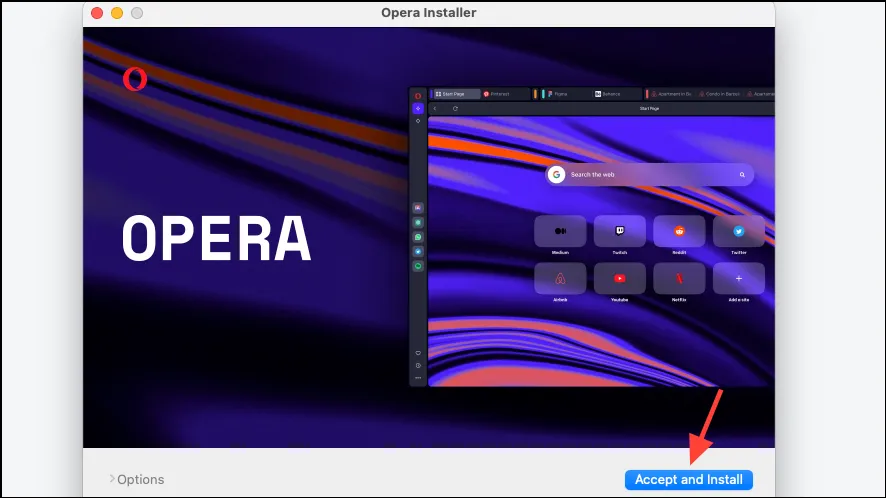

- ファイルをダウンロードしたら開き、インストーラーを実行します。

- 「同意してインストール」をクリックし、画面の指示に従ってブラウザをインストールします。

ローカルAIモデルの設定

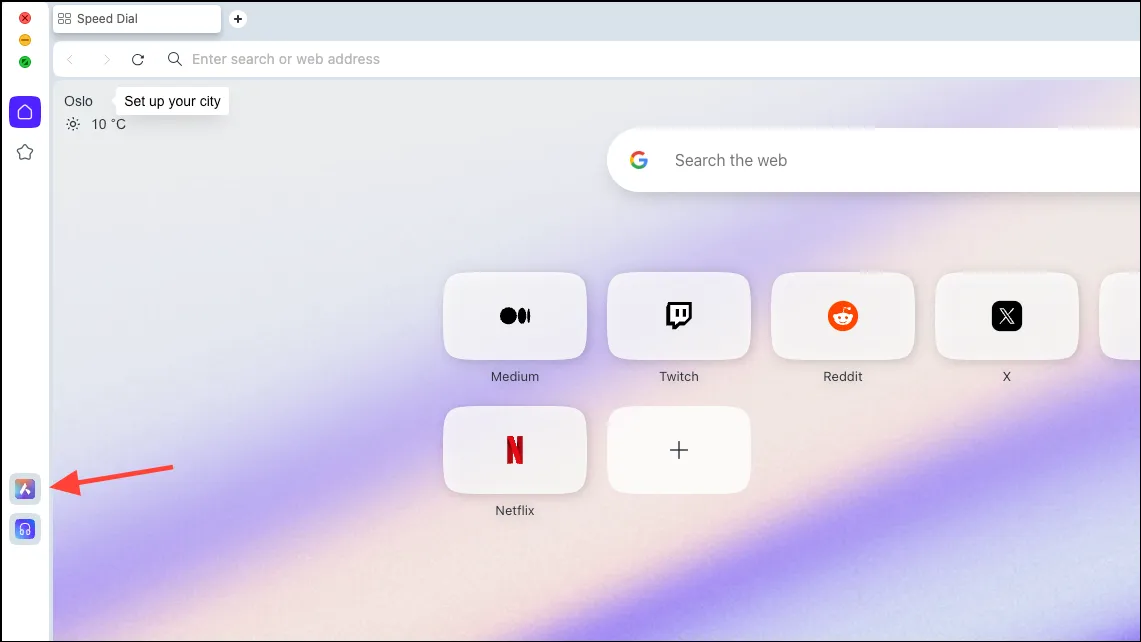

- ブラウザがダウンロードされたら、左側のサイドバーから「Aria AI」アイコンをクリックします。

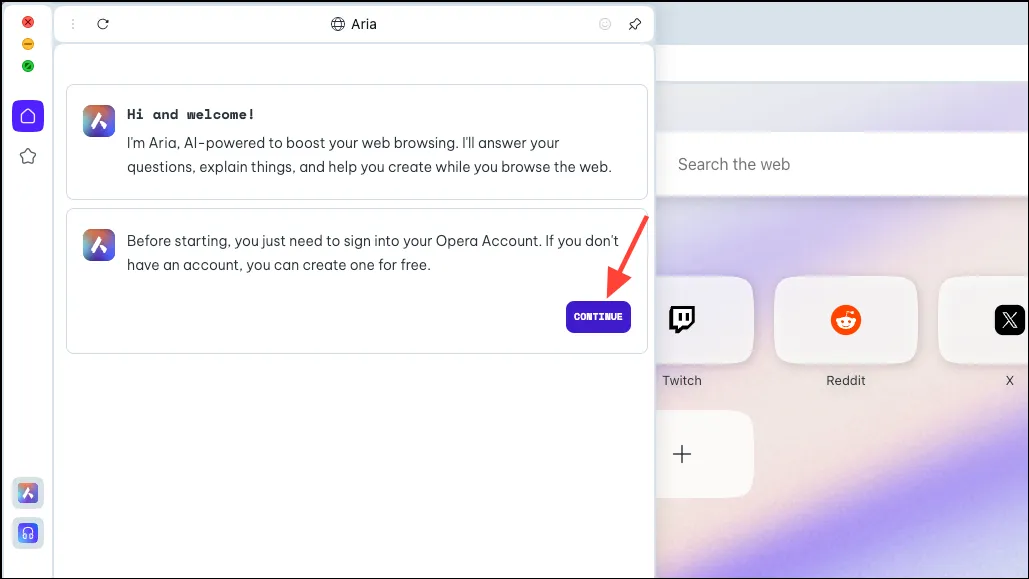

- 「続行」をクリックして続行します。

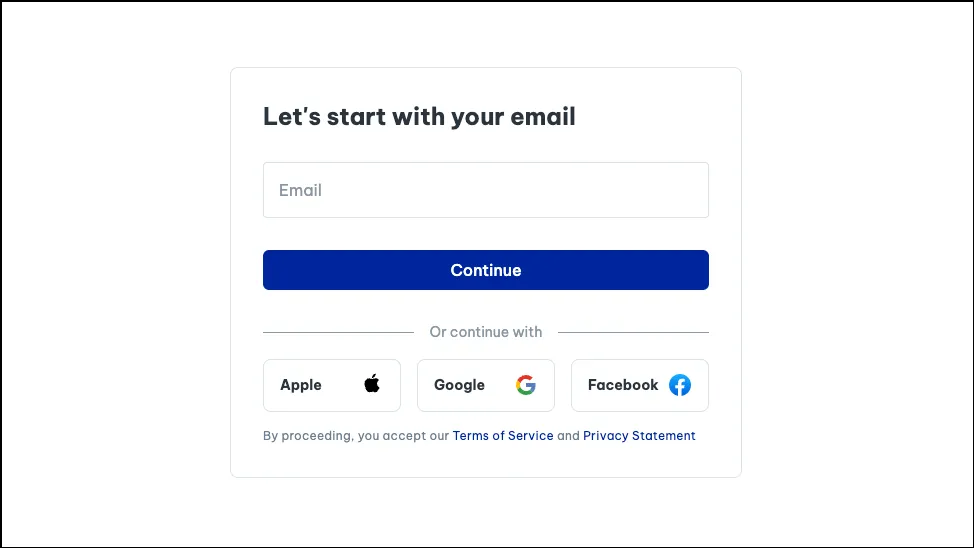

- Aria を初めて使用する場合は、無料の Opera アカウントに登録する必要があります。Opera アカウントを作成するには、メール アドレス、または Apple、Facebook、または Google アカウントを使用できます。

- アカウントを作成すると、Aria とチャットできるようになります。

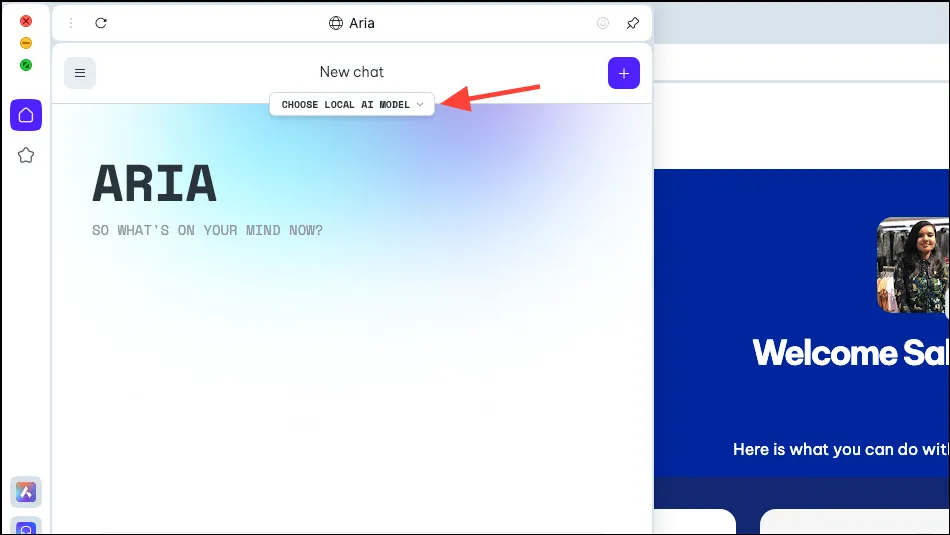

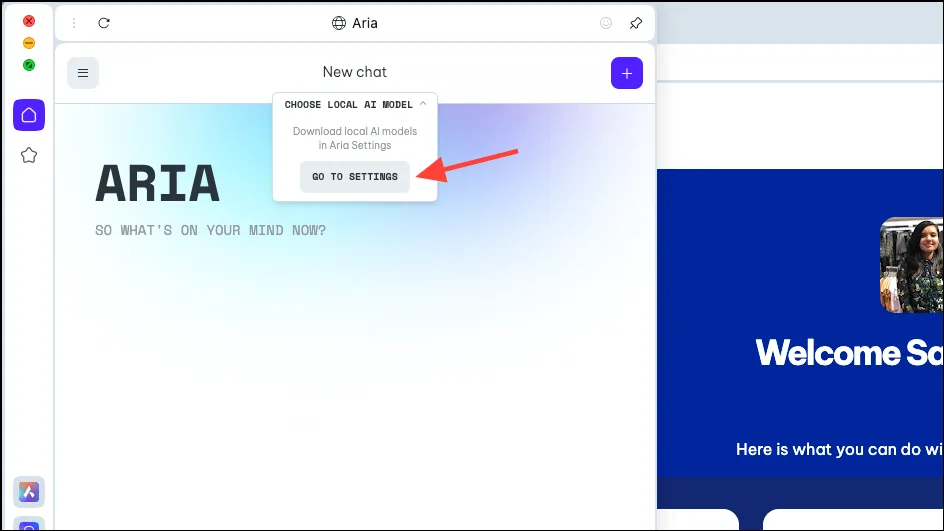

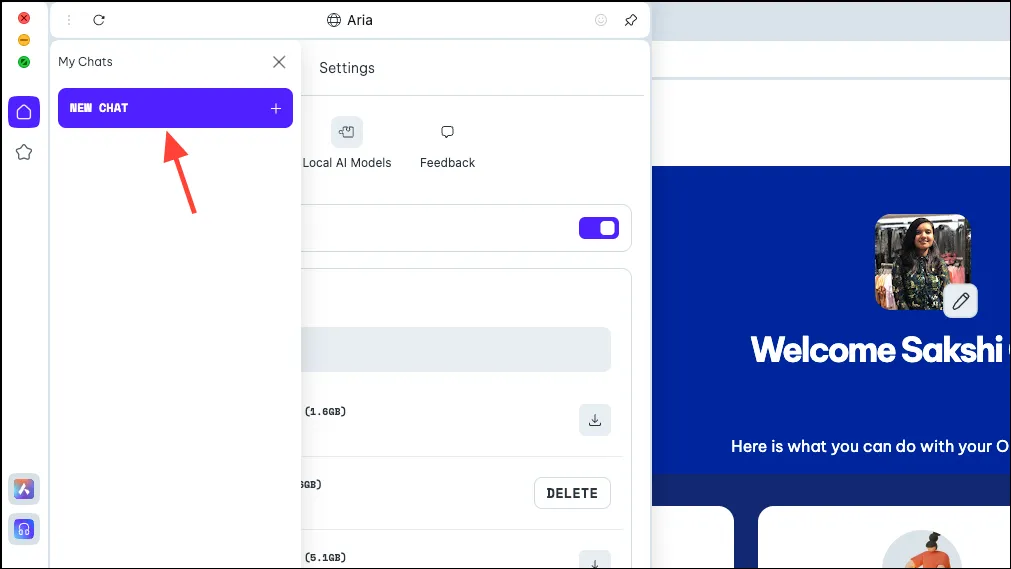

- ここで、Aria パネルに「ローカル AI モデルを選択」オプションが表示されます。それをクリックします。

- ドロップダウンメニューから「設定へ移動」を選択します。

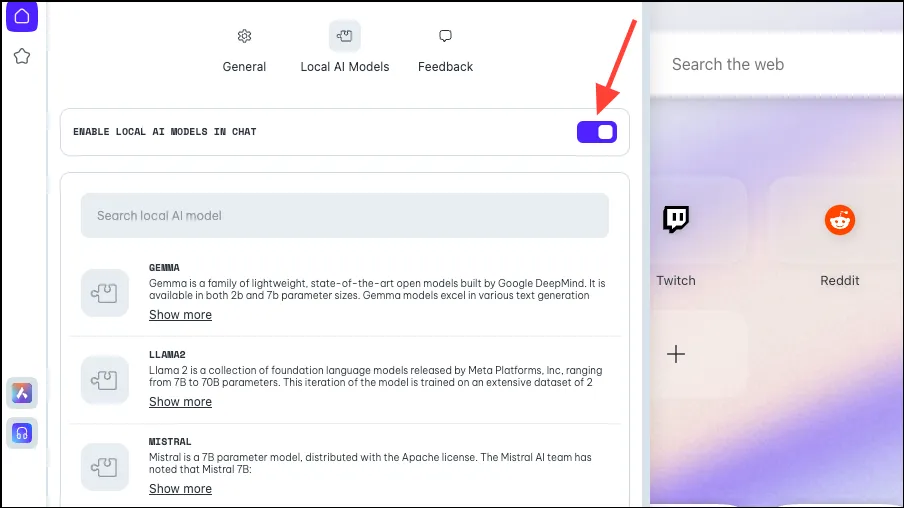

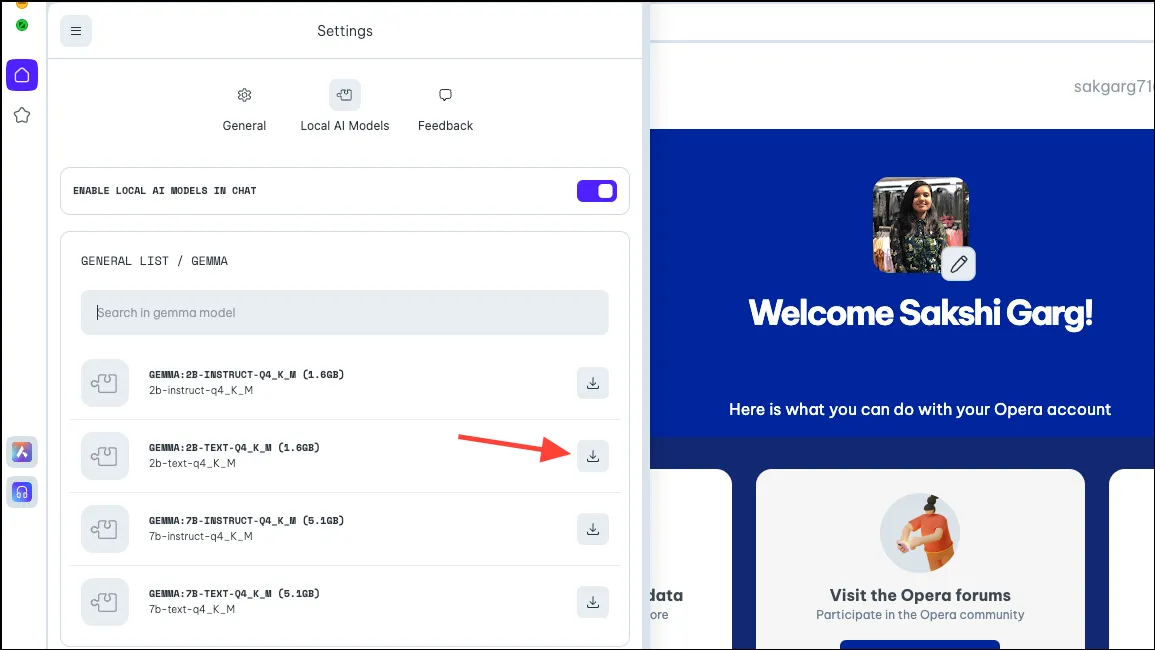

- 「チャットでローカル AI を有効にする」のトグルが有効になっていることを確認します。

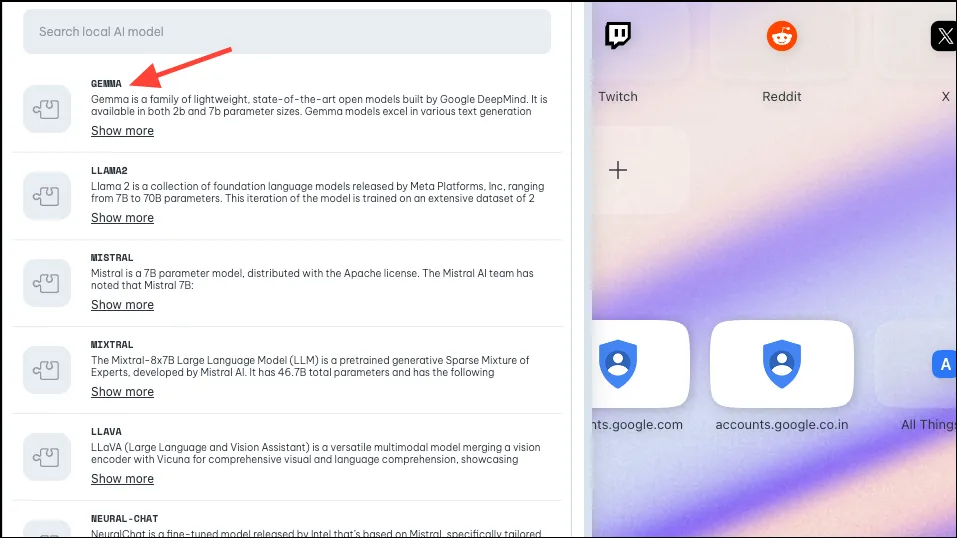

- 次に、クリックまたは検索して、ローカルで使用するためにダウンロードするモデルを選択します。前述のように、Opera はさまざまなバリエーションを持つ約 50 のモデル ファミリのサポートを実装しており、合計は 150 になります。

- そのため、Google の Gemma などの一部のモデルをクリックすると、4 つの異なるバリエーションが表示されます。使用するモデルをダウンロードします。このガイドでは、Gemma の 2B Text モデルをダウンロードします。右側の [ダウンロード] ボタンをクリックします。ダウンロードする前に、モデルに必要な PC の容量を確認できます。

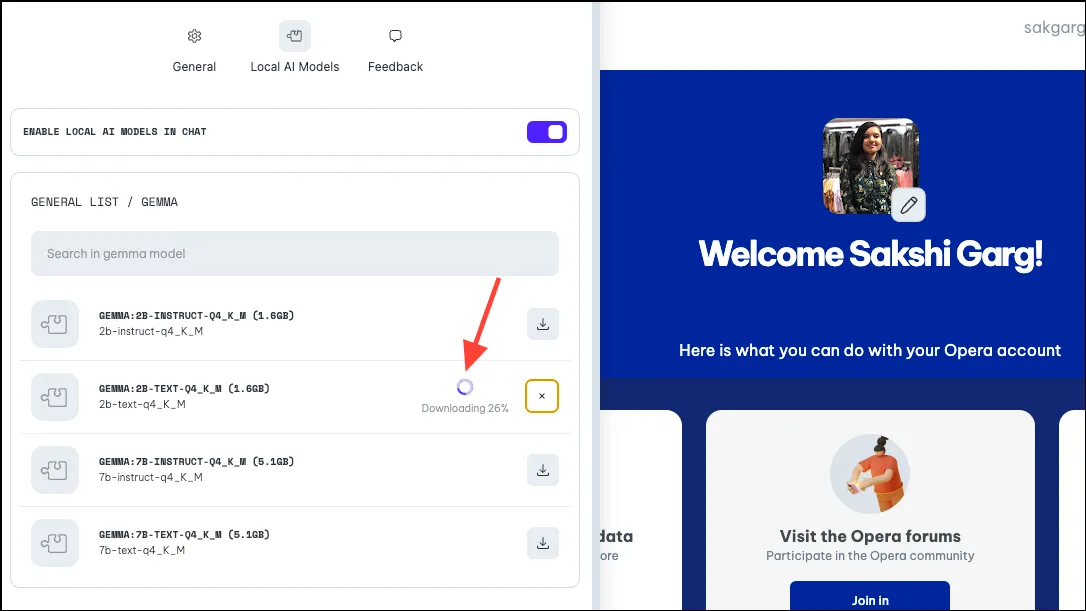

- モデルのサイズとインターネット接続によっては、ダウンロードに時間がかかる場合があります。ダウンロードの進行状況は横に表示されます。

ローカルAIモデルの使用

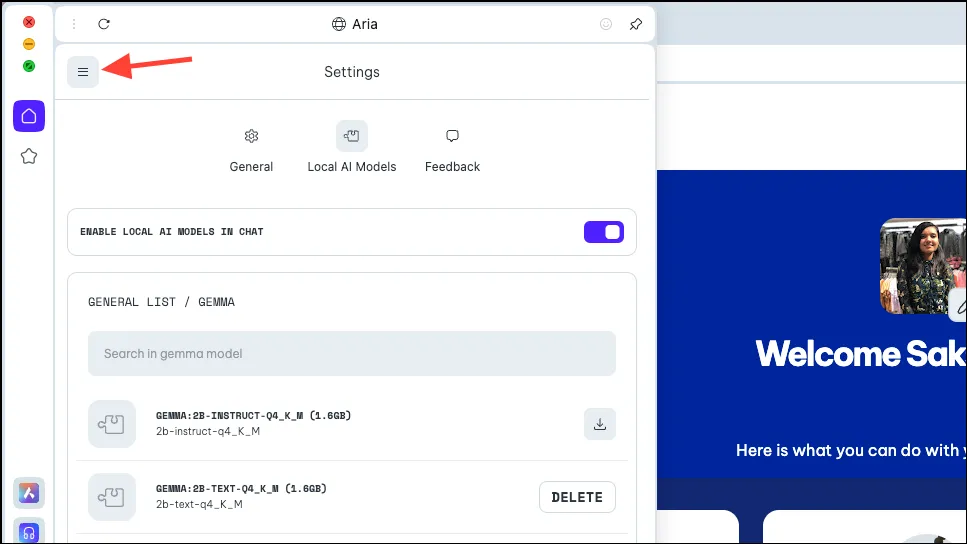

- モデルがダウンロードされたら、パネルの左上にある「メニュー」アイコンをクリックします。

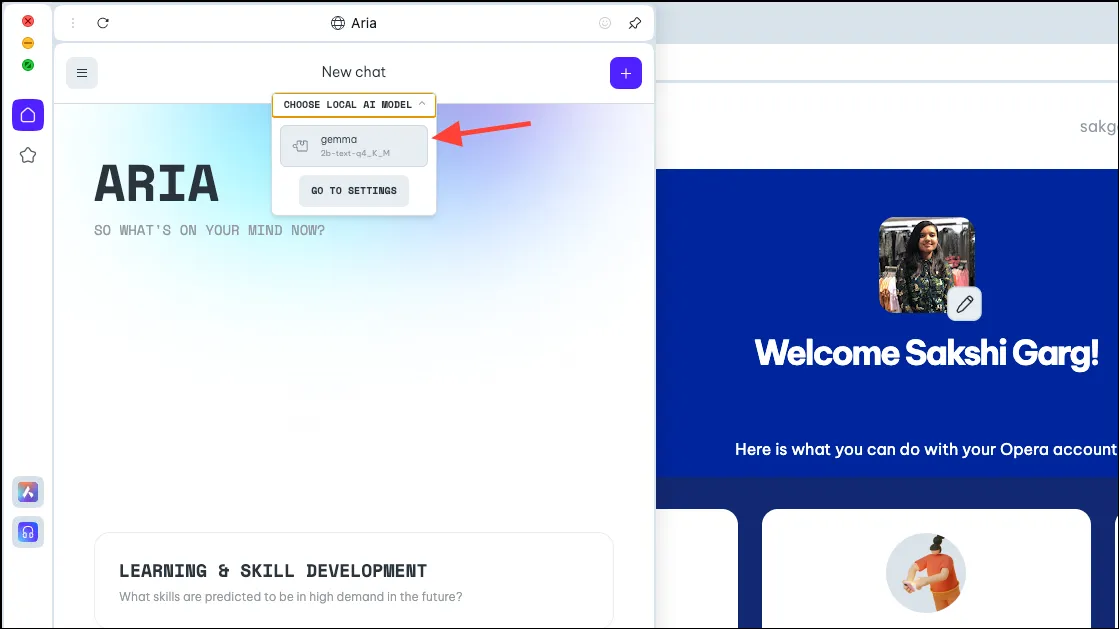

- 表示されるメニューから「新しいチャット」を選択します。

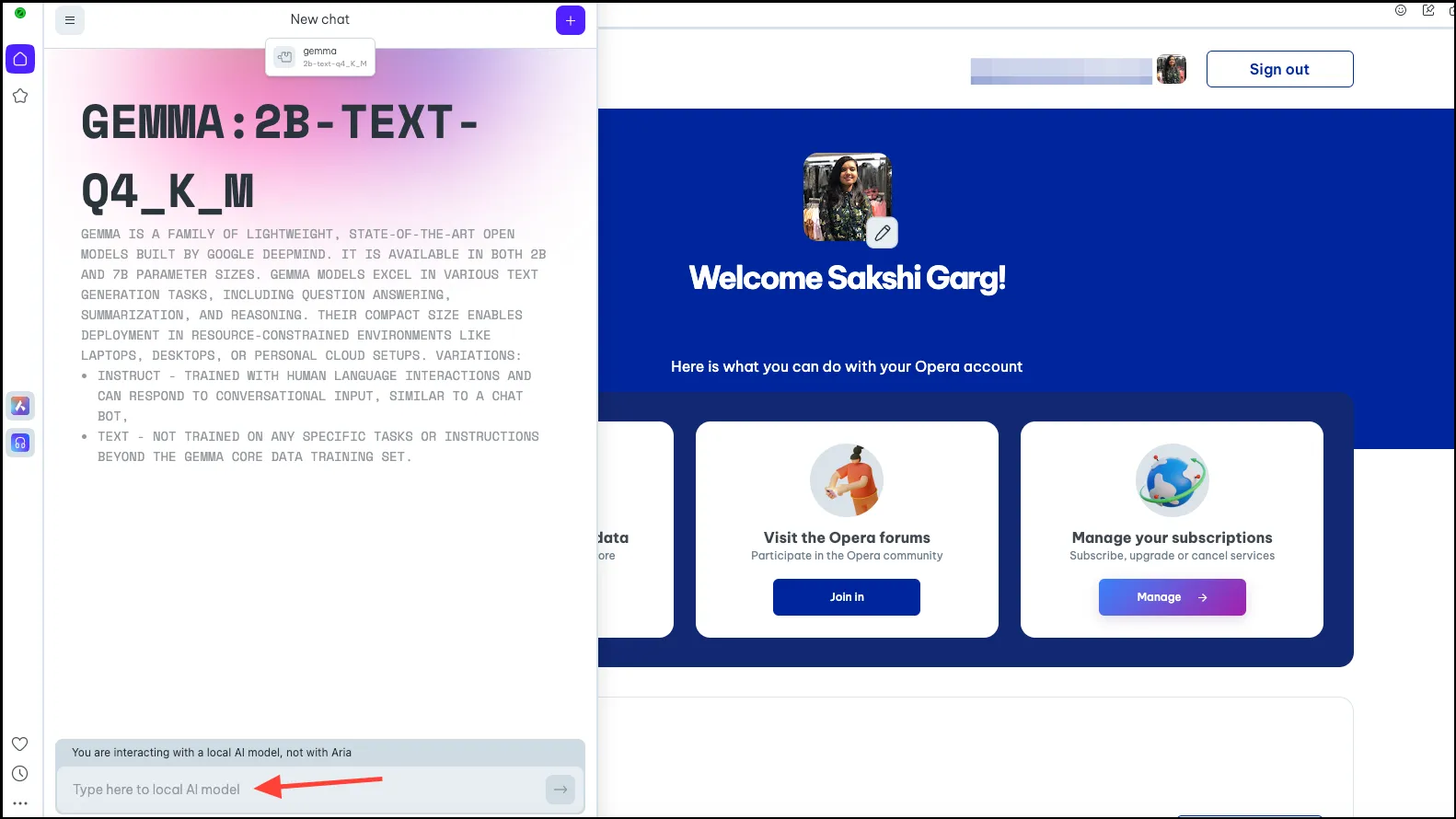

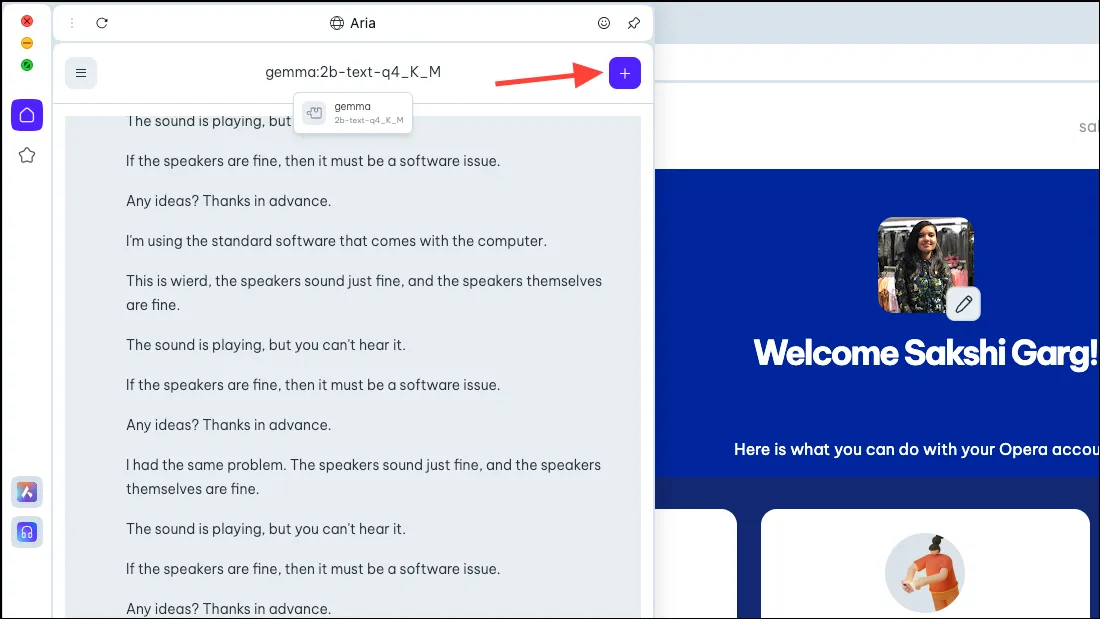

- もう一度、上部の「ローカル AI モデルを選択」オプションをクリックし、ドロップダウン メニューからダウンロードしたモデル (この場合は Gemma) を選択します。

- これで、選択したローカル AI モデルに切り替わります。プロンプト バーにプロンプトを入力して AI に送信し、ローカルでのやり取りを開始します。

- ローカル AI モデルとのチャットは、Aria とのチャットと同様に、チャット履歴で確認できます。整理しやすいようにチャットの名前を変更することもできます。

- 同様に、複数のローカル AI モデルをダウンロードして使用することもできますが、各モデルにはコンピューター上で 2~10 GB 程度のスペースが必要になることに注意してください。

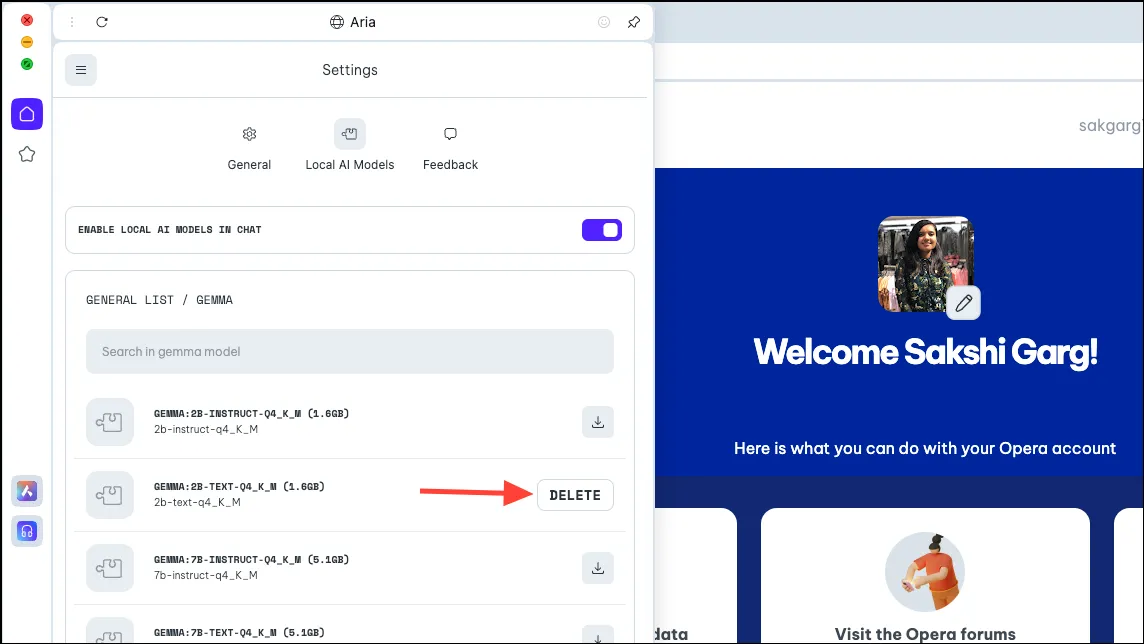

- PC からモデルを削除するには、以前にモデルをダウンロードした場所と同じ設定 (つまり、

Aria>Settings>Local AI Models> )に移動します[Downloaded Model]。次に、「削除」ボタンをクリックします。

Ariaに戻る

- Aria に戻るには、AI と新しいチャットを開始するだけです。右上隅の「+」アイコンをクリックします。

- 新しいチャットは Aria 自体から開始されます。

Opera One ブラウザでローカル AI モデルを使用できることは、セキュリティとプライバシーの観点からだけでなく、非常にエキサイティングです。初期段階ではすべてが非常にシンプルですが、将来の潜在的なケースは非常にエキサイティングです。ローカル AI を備えたブラウザは、ユーザーの過去の入力をすべてのデータとともに使用できることを意味する可能性があります。それはどれほどエキサイティングなことでしょう。Opera のチームはその可能性を模索しています。

しかし、将来的な可能性がなくても、データや AI とのチャットがサーバー上に保存されることを心配しているユーザーにとって、ローカル AI は素晴らしい動きです。コーディング用の Llama、優れた推論機能の Phi-2、テキスト生成や質問への回答などのタスク用の Mixtral など、検討できる優れた LLM がいくつかあります。

コメントを残す