Het landschap van AI-chatbots ontwikkelt zich in een ongekend tempo. Zodra een organisatie zijn nieuwste model onthult, volgen concurrenten snel en proberen ze elkaar te overtreffen. Ondanks dat OpenAI’s ChatGPT een vroege voorsprong heeft in deze competitieve arena, hebben rivalen zoals Gemini snel aan populariteit gewonnen en zijn ze verfijnder geworden.

Tot de huidige koplopers in AI-chatbotontwikkeling behoren de ChatGPT- en Gemini-modellen. In deze vergelijking richten we ons specifiek op het 4o-model van ChatGPT en de 1.5 Pro van Gemini, die beide premiumaanbiedingen zijn die zijn afgestemd op uiteenlopende taken.

Kiezen tussen deze toonaangevende modellen is essentieel om effectief aan uw unieke vereisten te voldoen. Daarom hebben we een reeks rigoureuze prestatietests uitgevoerd om te bepalen welk model uitblinkt in een veelheid aan taken. Laten we de analyse induiken!

1. Wiskundetoets

Onze eerste uitdaging bestaat uit het oplossen van een ingewikkeld wiskundig raadsel, dat is ontworpen om het redeneervermogen van elk model te meten:

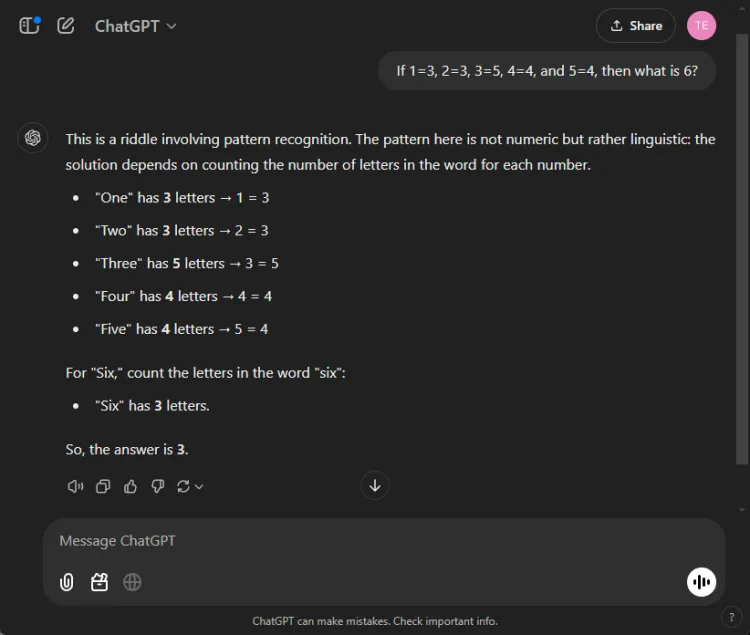

Snel: If 1=3, 2=3, 3=5, 4=4, and 5=4, what is 6?

De sleutel tot het oplossen van dit raadsel ligt in het tellen van de letters in de cijfernamen: één heeft drie letters, drie heeft vijf en bijgevolg heeft zes drie letters. Beide modellen slaagden erin om tot de juiste oplossing te komen, maar hun uitleg varieerde:

Hoewel beide antwoorden accuraat waren, gaf ChatGPT een iets genuanceerdere uitleg, waarbij werd opgemerkt dat deze oefening meer op taalkundig dan op numeriek begrip berust. Deze nuance is echter subjectief en doet niets af aan de correctheid van Gemini.

Winnaar: Gelijkspel

2. Samenvattingstest

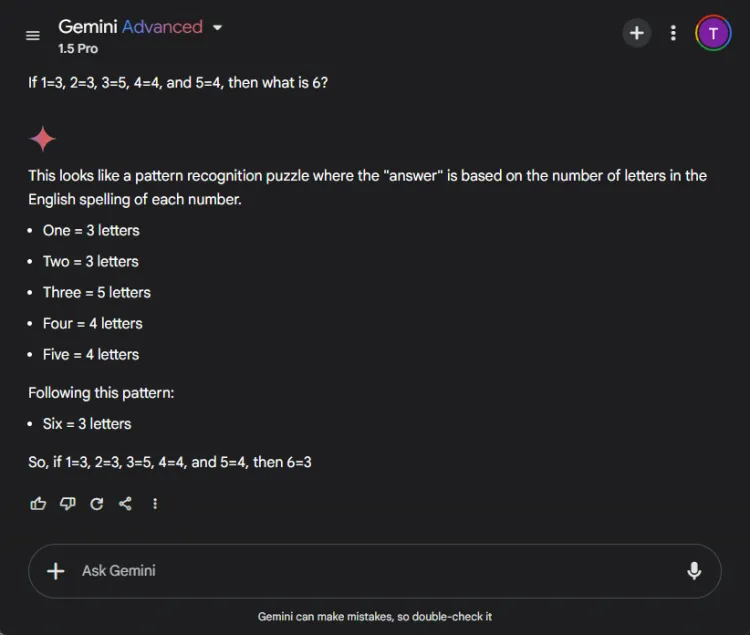

In dit segment werd het vermogen van elk model beoordeeld om een lang onderzoeksartikel van 27 pagina’s samen te vatten in een bondige samenvatting van minder dan 100 woorden. De focus lag op welke content elk model in hun samenvattingen opnam of wegliet.

Dit is hoe de uitvoer varieerde tussen ChatGPT 4o en Gemini 1.5 Pro:

ChatGPT toonde uitzonderlijke samenvattingsvaardigheden, door een complete samenvatting te maken binnen de limiet van 100 woorden, die alle belangrijke punten omvatte. Het presenteerde de informatie echter als één tekstblok zonder directe citaten uit het artikel.

Daarentegen presteerde Gemini ook bewonderenswaardig, met een samenvatting van 83 woorden ondersteund door verwijzingen naar specifieke delen van de tekst. Hoewel ChatGPT uitblonk in volledigheid, gaf de toevoeging van citaten door Gemini het een belangrijk voordeel.

Winnaar: Tweelingen

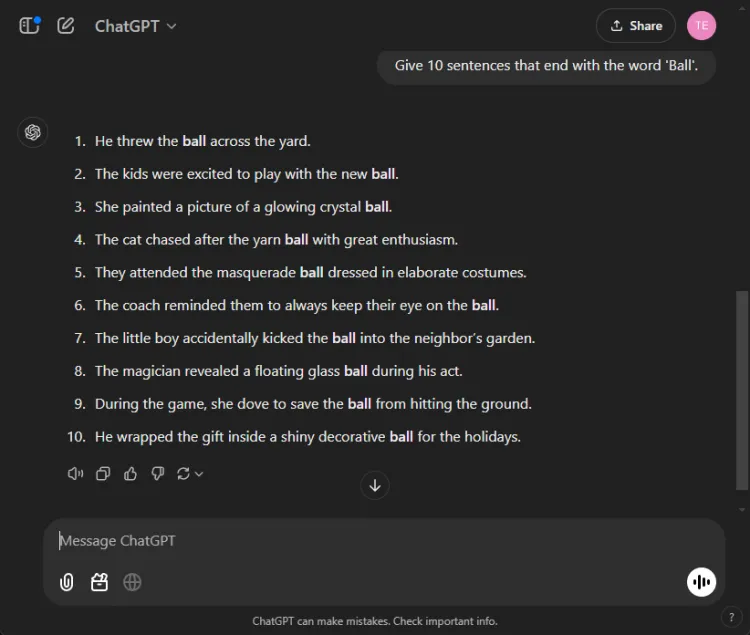

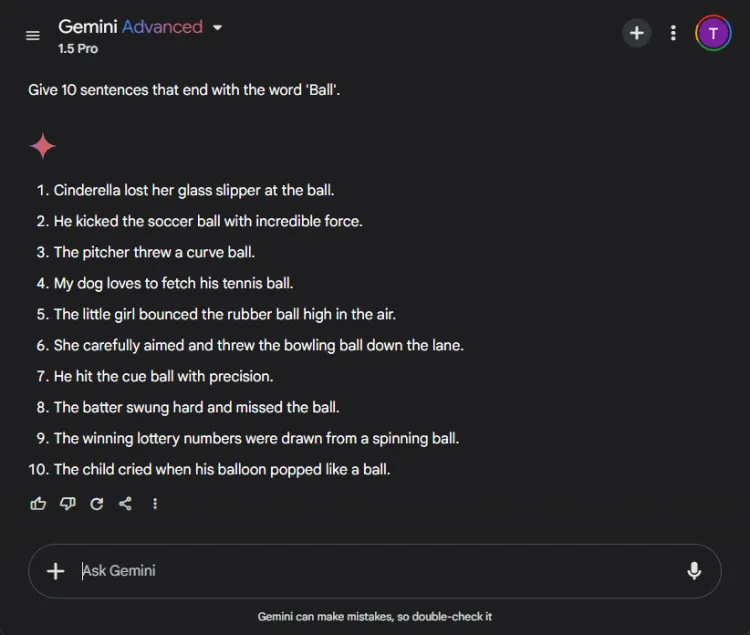

3. De ‘Eindig met een woord’-test

Deze eenvoudige taak vereiste het opstellen van 10 zinnen die eindigen met het woord “bal”.De eenvoud van de taak maakt het opvallend dat veel modellen er moeite mee hebben.

Snel: Provide 10 sentences ending with the word 'ball'.

ChatGPT produceerde verrassend genoeg slechts 3 geldige zinnen, terwijl Gemini het overtrof met 6 zinnen die correct eindigden met “bal”.Hier is een blik op hun pogingen:

Hoewel beide modellen de doelstelling van 10 zinnen niet haalden, toonde Gemini’s output aan dat hij de gegeven instructies beter begreep.

Winnaar: Tweelingen

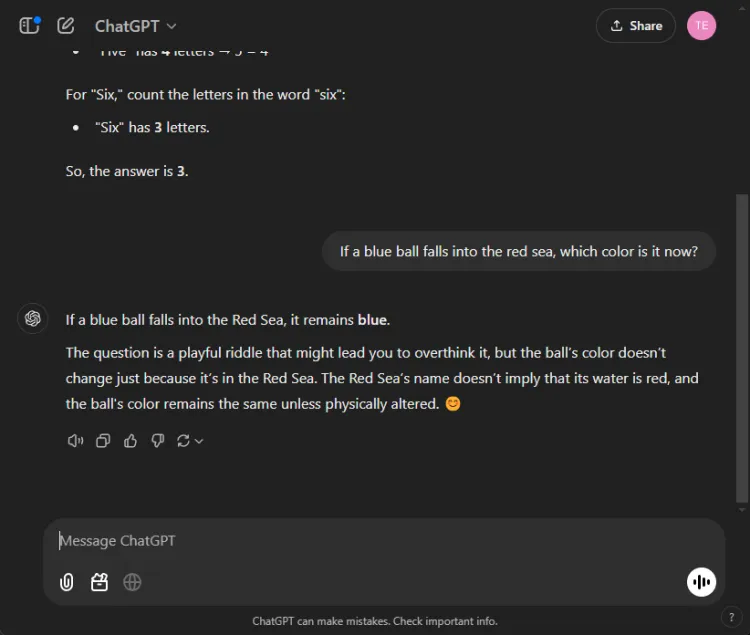

4. Gezond verstand test

Deze tests vormen een leuke uitdaging, aangezien AI hier vaak de mist in gaat. We stelden een simpele vraag:

Snel: If a blue ball falls into the red sea, what color is it now?

Beide modellen leverden nauwkeurige antwoorden op, en stelden vast dat de kleur van de bal blauw zou blijven. De nuances in hun uitleg varieerden echter:

Gemini gaf een kort antwoord, terwijl ChatGPT aanvullende context bood. Of deze diepte nodig is, is subjectief, maar beide modellen excelleerden in het identificeren van de kleur van de bal.

Winnaar: Gelijkspel

5. Creativiteitstest

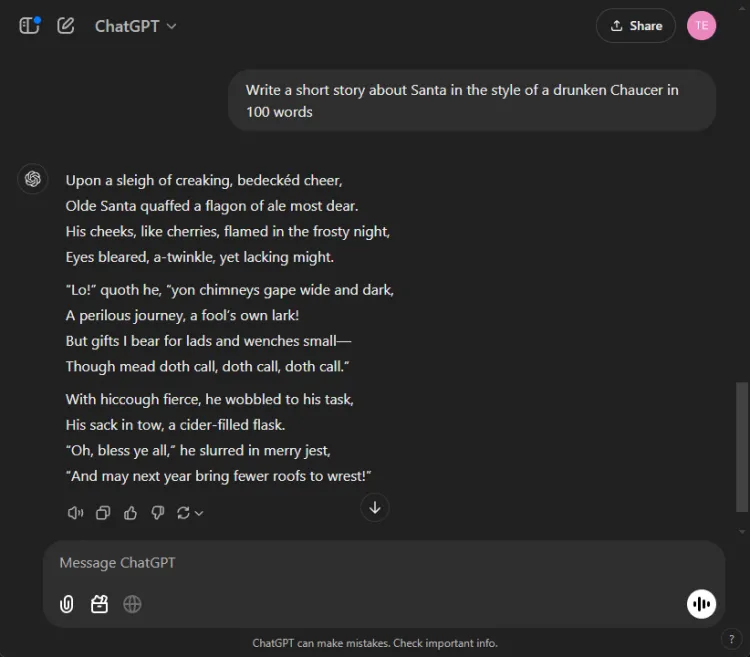

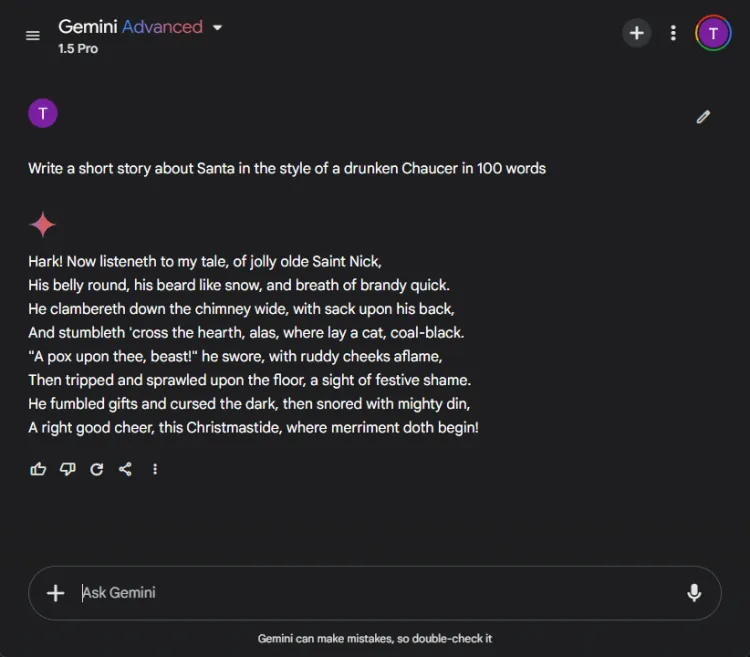

Het inzetten van AI voor creatief verhalen vertellen kan enorm nuttig zijn. We hebben elke AI de opdracht gegeven om een kort verhaal te schrijven met de Kerstman, gestyled alsof het geschreven is door een beschonken Chaucer in 100 woorden.

Snel: Write a short story about Santa in the style of a drunken Chaucer in 100 words.

Hier zijn hun creatieve weergaven:

De subjectieve aard van creativiteit maakt het moeilijk om een duidelijke winnaar aan te wijzen. Opvallend is dat Gemini creatieve taken vaak begint met de zin “Hark”, wat de voorkeursstijlkeuze is geworden. Niettemin viel het verhaal van ChatGPT op in deze ronde.

Winnaar: ChatGPT

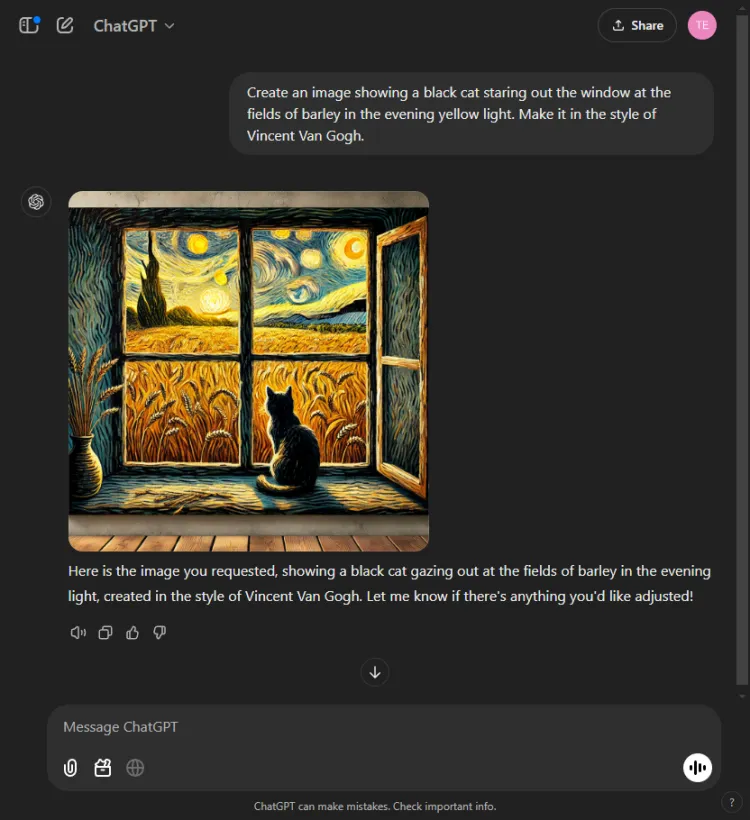

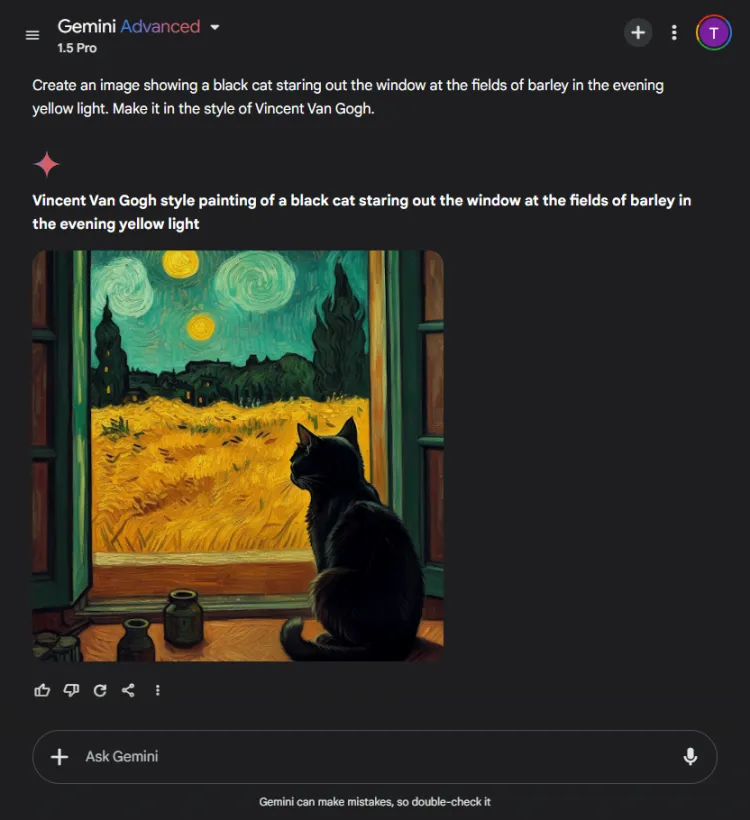

6. Beeldgeneratietest

Deze test evalueerde de visuele generatiemogelijkheden van elk AI-model. We daagden hen uit om een afbeelding te maken op basis van de volgende prompt:

Snel: Create an image of a black cat gazing out at fields of barley bathed in evening yellow light, in the style of Vincent Van Gogh.

ChatGPT was een seconde of twee sneller, maar Gemini’s laatste afbeelding beeldde de scène met meer verfijning af. Hoewel beide modellen de artistieke stijl van Van Gogh begrepen, varieerde de subjectieve kwaliteit van de afbeeldingen:

Het is de moeite waard om op te merken dat ChatGPT post-generatie-bewerking van afbeeldingen toestaat, een voordeel dat Gemini momenteel mist. Aangezien beide afbeeldingen effectief de kenmerkende stijl van Van Gogh belichamen, komt de keuze neer op de voorkeur van de kijker, hoewel wij neigen naar Gemini.

Winnaar: Tweelingen

7. Multimodale generatieve test

De bekwaamheid van AI wordt getest in geïntegreerde modi, omdat ze vaak uitblinken in geïsoleerde taken, maar moeite hebben met uitgebreide taken. We hebben beide modellen de opdracht gegeven om een kinderverhaal te schrijven over sportiviteit, waarbij we drie illustraties invoegden.

Vraag: Schrijf een kort kinderverhaal over sportiviteit en voeg indien nodig 3 afbeeldingen toe.

ChatGPT produceerde een boeiend verhaal met morele reflecties en naadloos verwerkte beelden. Gemini slaagde er daarentegen in om een verhaal te creëren, maar het ontbrak aan helderheid en samenhang en genereerde geen beelden voor het verhaal.

Gezien de overtuigende en makkelijk te volgen presentatie was dit een voor de hand liggende beslissing.

Winnaar: ChatGPT.

8. Vertalingstest

Om de vertaalcapaciteiten van deze modellen te meten, vroegen we elk model om een selectie te vertalen uit het Hindi-kortverhaal “Grih Daah” van Premchand.

ChatGPT produceerde opmerkelijk effectieve vertalingen, waarbij de oorspronkelijke betekenis werd behouden en de stilistische integriteit van de auteur werd behouden:

Gemini had daarentegen aanvankelijk moeite met het vertaalverzoek en vertoonde merkbare vertragingen in de responstijd. Deze inconsistentie in prestaties is een veelvoorkomend probleem met Gemini.

Winnaar: ChatGPT

9. Codeertest

Om hun programmeervaardigheden te evalueren, legden we een standaardoptimalisatieprobleem voor:

Snel: Provide the Python code for the Travelling Salesman Problem.

ChatGPT reageerde efficiënt en maakte gebruik van de geïntegreerde Canvas-modus voor codering, waardoor code direct kon worden uitgevoerd en fouten konden worden opgespoord:

Gemini blonk daarentegen uit door betrouwbare code, maar het ontbrak aan een interactieve code-interface zoals Canvas van ChatGPT:

Winnaar: ChatGPT

10. Naald in een hooiberg-test

Deze test daagt AI-modellen uit om specifieke stukjes informatie te vinden in een groter document. We gebruikten het eerste segment van Pushkins korte verhaal “The Captain’s Daughter” en stelden de volgende prompt:

Snel: Identify which bread Mr. Joe's son ate from the following excerpt.

ChatGPT vond meteen het antwoord: bruin brood.

Daarentegen kon Gemini de informatie niet ophalen. Het programma had moeite met het verwerken van de verstrekte details en was daardoor niet effectief in het verwerken van complexe gegevens.

Winnaar: ChatGPT

11. Raad de filmtest

In deze vermakelijke ronde hebben we de beeldherkenningsvaardigheden van de modellen beoordeeld door een populaire filmstill te identificeren:

Beide modellen gaven de film een correcte naam, maar ChatGPT wist de afgebeelde personages (Colin Farrell en zijn ezel) wel te specificeren, terwijl Gemini de ezel op grappige wijze verkeerd identificeerde als Colm Doherty.

Winnaar: ChatGPT

Algehele winnaar

Na het tellen van de scores kwam het 4o-model van ChatGPT als winnaar uit de bus met 6 overwinningen en 2 gelijkspel, wat zijn robuuste prestaties in verschillende tests en competenties liet zien. Ondertussen bood Gemini’s 1.5 Pro een prijzenswaardige uitdaging, excelleerde in samenvatting, beeldgeneratie en de ‘eindig met een woord’-taak, en bereikte pariteit in zowel wiskunde- als gezond verstandsevaluaties.

Uiteindelijk overtrof ChatGPT Gemini op cruciale gebieden zoals codering, vertaling, creativiteit, ophalen van informatie en interpretatie van afbeeldingen. Met ChatGPT’s consistente betrouwbaarheid springt het eruit als de voorkeurs-AI-partner, zelfs als Gemini potentieel voor verbetering laat zien wanneer prompts worden geoptimaliseerd. In onze evaluatie geven de resultaten ChatGPT de voorkeur voor degenen die betrouwbaarheid en doeltreffendheid prioriteit geven.

Veelgestelde vragen

1. Wat zijn de belangrijkste verschillen tussen ChatGPT 4o en Gemini 1.5 Pro?

Hoewel beide modellen premium AI-chatbots zijn, heeft ChatGPT 4o superieure prestaties laten zien in codering, vertaling en creatieve taken. Gemini 1.5 Pro blinkt echter uit in samenvatting en beeldgeneratie.

2. Welke AI-chatbot is beter voor gewone gebruikers?

Voor incidentele gebruikers die op zoek zijn naar betrouwbaarheid bij verschillende taken, wordt ChatGPT 4o over het algemeen gezien als de meest betrouwbare keuze vanwege de consistente prestaties en uitgebreide mogelijkheden.

3. Kan ik deze AI-chatbots voor zakelijke doeleinden gebruiken?

Absoluut! Zowel ChatGPT 4o als Gemini 1.5 Pro zijn geschikt voor zakelijke toepassingen, waaronder automatisering van klantenservice, contentcreatie en data-analyse, waardoor ze waardevolle tools zijn in een professionele omgeving.