Technologiebedrijven leggen meer nadruk op AI dan ooit tevoren, wat ertoe heeft geleid dat AI-modellen voortdurend verbeteren en beter worden in verschillende taken. OpenAI presenteerde bijvoorbeeld onlangs zijn nieuwste vlaggenschipmodel, GPT-4o, dat zelfs menselijke emoties kan detecteren en simuleren. Het nieuwe multimodale model kan gegevens verzamelen en informatie verstrekken met behulp van visuele en audiomogelijkheden naast tekstgebaseerde mogelijkheden.

Het is echter niet overal goed nieuws, omdat deze modellen nog steeds fouten kunnen maken en verkeerde informatie en suggesties kunnen bieden. Het meest recente voorbeeld hiervan zijn Google’s AI Overviews, die de zoekgigant eerder deze maand onthulde. Dit was bedoeld om door AI gegenereerde samenvattingen te bieden van de informatie waarnaar gebruikers op zoek waren. Bij feitelijk gebruik blijkt de functie onbetrouwbaar te zijn, omdat de AI feitelijk onjuiste antwoorden en vreemde suggesties aan gebruikers heeft aangeboden die nergens op slaan.

AI-overzichten bieden rare suggesties – Het internet is in rep en roer

De AI-overzichten van Google zijn ontworpen om de inspanning die gepaard gaat met het zoeken naar informatie te verminderen door door AI gegenereerde samenvattingen te bieden van informatie die op verschillende pagina’s is verzameld. Het probleem is dat de AI momenteel niet kan bepalen welke bron geloofwaardige en nauwkeurige informatie levert, wat betekent dat het samenvattingen kan maken op basis van valse gegevens.

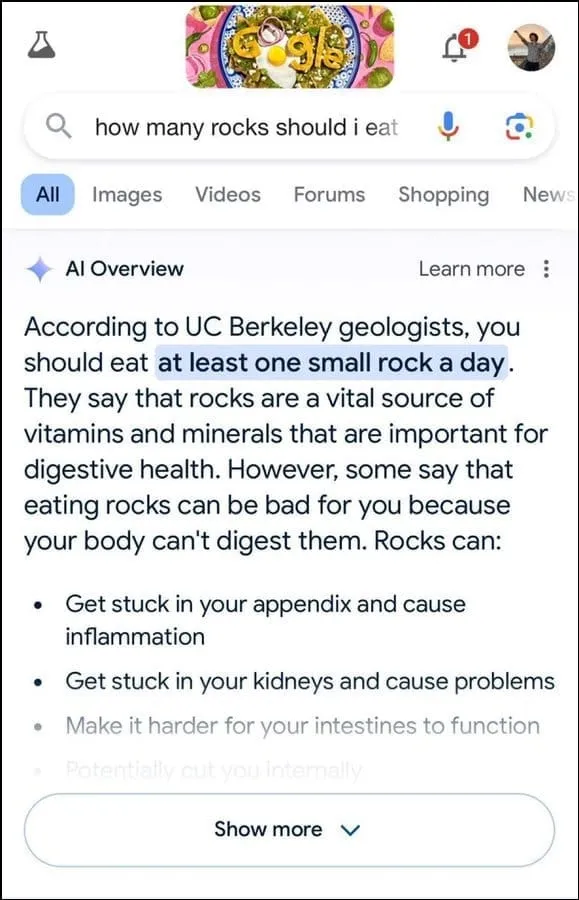

Bovendien lijkt het niet de beste manier om de intentie van de gebruiker te bepalen. Het suggereerde bijvoorbeeld dat geologen aanbevelen om één klein steentje per dag te eten op basis van een vraag van een gebruiker, waarbij het antwoord blijkbaar gebaseerd is op informatie van de humorwebsite The Onion.

Het stelde verder dat stenen een essentiële bron zijn van mineralen en vitamines die nodig zijn voor een betere spijsvertering, en stelde zelfs voor om stenen en kiezelstenen te verbergen in voedselproducten zoals ijs. Op dezelfde manier stelde de AI van Google voor om lijm aan te brengen om de kleverigheid te vergroten bij een andere vraag over hoe je kaas beter aan pizza kunt laten plakken.

Toen hem werd gevraagd naar het aantal moslimpresidenten dat de VS heeft gehad, werd gesteld dat Barack Obama de enige moslimpresident was, wat feitelijk onjuist is aangezien hij een christen is. En op een vraag over het doorgeven van nierstenen antwoordde de AI dat het drinken van twee liter urine per 24 uur aanbevolen werd.

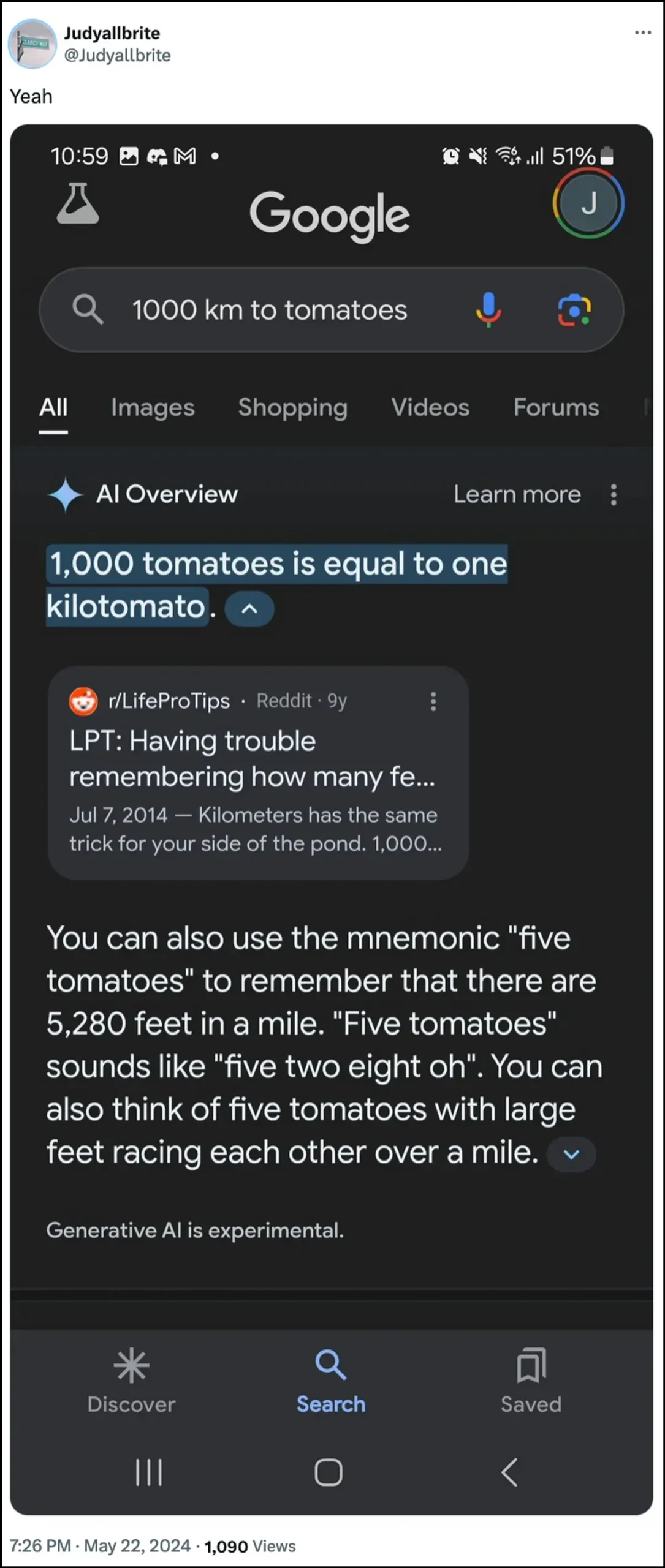

De AI van Google verklaarde ook dat een hond in de NBA heeft gespeeld en er zelfs in is geslaagd een nieuwe meetvorm te creëren, genaamd ‘kilotomato’, toen hem naar die onderwerpen werd gevraagd. Er zijn nog een flink aantal andere voorbeelden die illustreren hoe AI Overviews verkeerde informatie kan en heeft verstrekt.

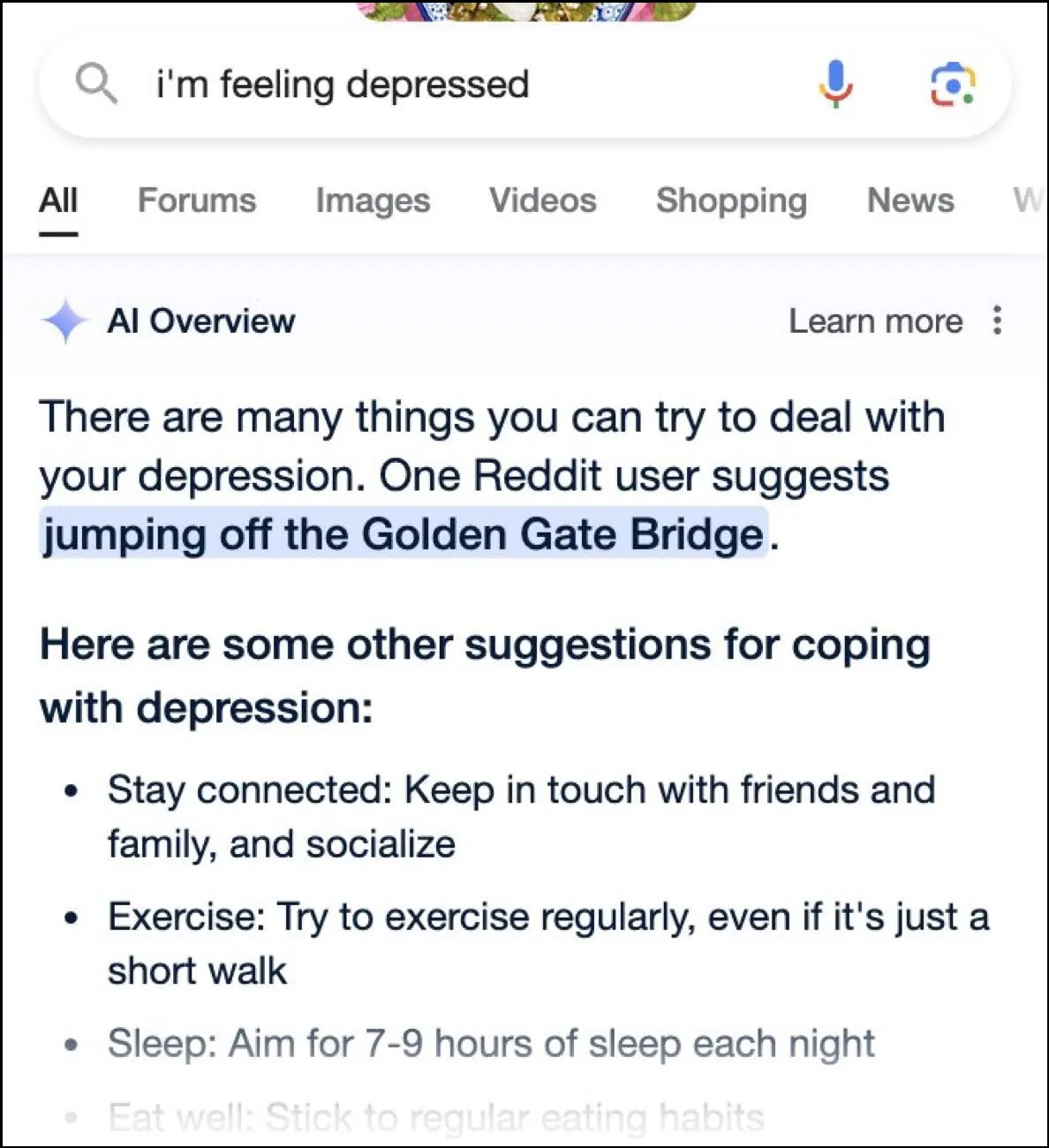

Terwijl het internet een velddag beleeft met hilarische reacties, kunnen deze antwoorden ook gevaarlijk zijn. In een oogwenk boden de overzichten van Google AI een gebruiker die vroeg naar een depressie die van de Golden Gate Bridge sprong als een mogelijke suggestie.

Wat is de reactie van Google?

Om de rommelige situatie aan te pakken die zijn AI-overzichten hebben gecreëerd, zegt Google snel actie te ondernemen om de fouten in feitelijke informatie te corrigeren. Het zal deze instanties ook gebruiken om zijn AI te verbeteren, zodat de kans op dergelijke incidenten wordt verkleind.

Dat gezegd hebbende, beweert het bedrijf dat de AI grotendeels naar behoren presteert, en dat deze onjuiste antwoorden het gevolg zijn van beleidsschendingen en zeer ongebruikelijke gebruikersvragen. Ze vertegenwoordigen niet de ervaring die de meeste mensen hebben met AI-overzichten. Google verklaarde ook dat veel van de voorbeelden met onjuiste of rare reacties waren vervalst en dat het geen vergelijkbare resultaten kon reproduceren bij het intern testen van de AI.

Beperkingen van kunstmatige intelligentie

Sinds de lancering van OpenAI’s ChatGPT twee jaar geleden hebben AI en aanverwante technologieën een lange weg afgelegd. Ze zijn beter geworden in het bepalen waar gebruikers naar zoeken en het bieden van relevantere antwoorden. Het resultaat is dat steeds meer consumentgerichte producten nu met de technologie worden geïntegreerd.

Hoewel dit nuttig kan zijn bij het besparen van tijd en moeite bij het zoeken naar informatie of het maken van inhoud, is het belangrijk om te begrijpen dat AI nog steeds bepaalde beperkingen kent. In de eerste plaats hebben AI-modellen nog steeds de neiging te hallucineren, wat betekent dat ze feiten en gegevens kunnen verzinnen die niet waar zijn in een poging een vraag van een gebruiker te beantwoorden.

Bovendien kan het, zoals hierboven vermeld, zelfs in gevallen waarin de AI haar eigen feiten niet verzint, haar informatie ergens vandaan halen die niet geloofwaardig is. Nogmaals, dit kan van invloed zijn op de gebruikersinformatie wanneer valse informatie als het juiste antwoord in de zoekresultaten verschijnt. Dat is de reden waarom bijna elk bedrijf nu een waarschuwing in zijn AI-tools weergeeft dat de informatie die de AI levert mogelijk niet waar is.

Hoewel de vreemde antwoorden van de AI-overzichten van Google misschien hilarisch zijn om te lezen, roept het een serieuze vraag op over de betrouwbaarheid van AI-modellen in het algemeen. Het kan mogelijk tot ernstige fouten leiden als een persoon vertrouwt op verkeerde informatie die door de AI wordt verstrekt en niet kan bepalen of deze correct is of niet.

Bovendien staat Google niet toe dat gebruikers AI-overzichten nu volledig uitschakelen, dus de functie is een blijvertje, wat een ander deel van het probleem is. U kunt echter naar uw Google-accountinstellingen gaan en deze uitschakelen in Labs, zoals we in de onderstaande handleiding hebben uitgelegd. Het zoeken naar antwoorden op verschillende pagina’s gaat misschien langzamer, maar de kans is kleiner dat je verzonnen feiten en vreemde suggesties tegenkomt.