Krajobraz chatbotów AI rozwija się w niespotykanym dotąd tempie. Gdy tylko jedna organizacja ujawnia swój najnowszy model, konkurenci szybko idą w jej ślady, starając się prześcignąć siebie nawzajem. Pomimo że ChatGPT firmy OpenAI cieszy się wczesną przewagą na tej konkurencyjnej arenie, rywale tacy jak Gemini szybko zyskali popularność i wyrafinowanie.

Wśród obecnych liderów w rozwoju chatbotów AI znajdują się modele ChatGPT i Gemini. W tym porównaniu skupiamy się konkretnie na modelu 4o ChatGPT i 1.5 Pro Gemini, które są ofertami premium dostosowanymi do różnych zadań.

Wybór pomiędzy tymi wiodącymi modelami jest niezbędny do skutecznego spełnienia Twoich unikalnych wymagań. Dlatego przeprowadziliśmy serię rygorystycznych testów wydajności, aby określić, który model sprawdza się w wielu zadaniach. Zanurzmy się w analizie!

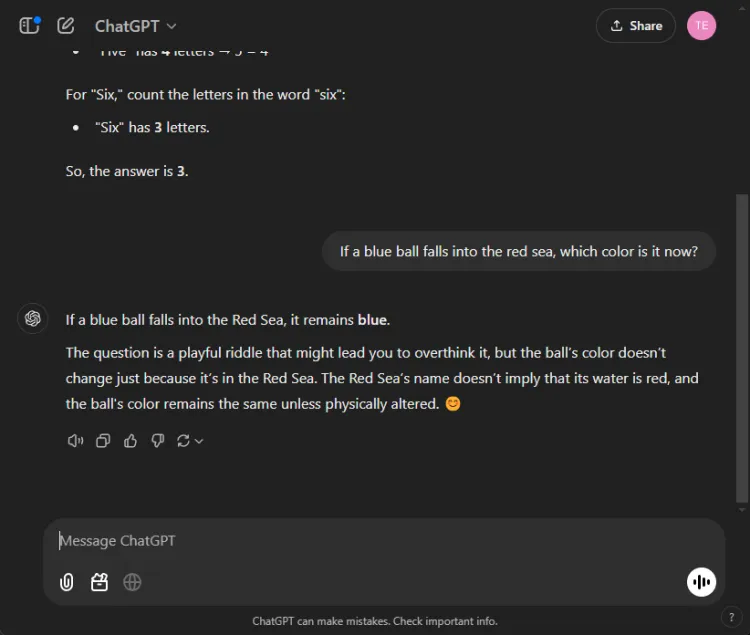

1. Test z matematyki

Nasze pierwsze wyzwanie polega na rozwiązaniu skomplikowanej zagadki matematycznej, mającej na celu ocenę zdolności rozumowania każdego modelu:

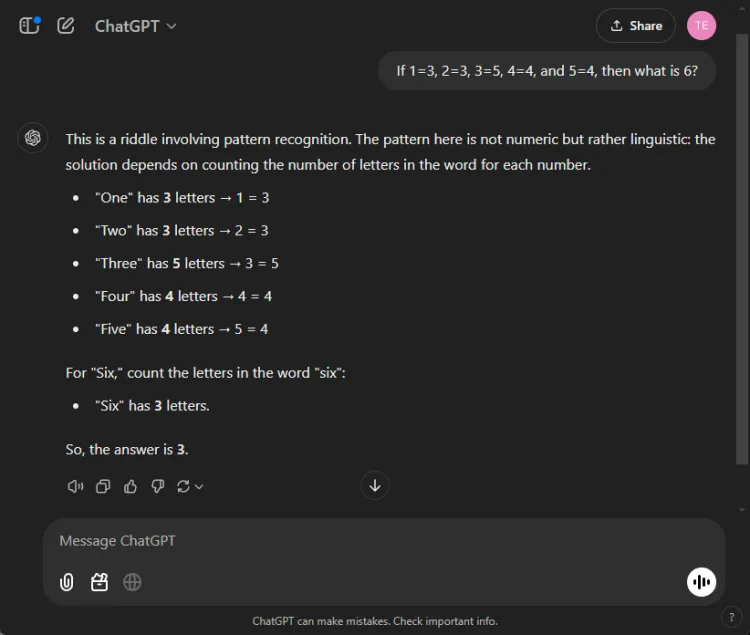

Podpowiedź: If 1=3, 2=3, 3=5, 4=4, and 5=4, what is 6?

Kluczem do rozwiązania tej zagadki jest policzenie liter w nazwach liczbowych: jeden ma trzy litery, trzy ma pięć, a w konsekwencji sześć ma trzy litery. Obydwa modele zdołały dojść do poprawnego rozwiązania, ale ich wyjaśnienia były różne:

Chociaż obie odpowiedzi były dokładne, ChatGPT dostarczył nieco bardziej niuansowe wyjaśnienie, zauważając, że to ćwiczenie opiera się na rozumieniu lingwistycznym, a nie liczbowym. Jednak ten niuans jest subiektywny i nie umniejsza poprawności Gemini.

Zwycięzca: Remis

2. Test podsumowujący

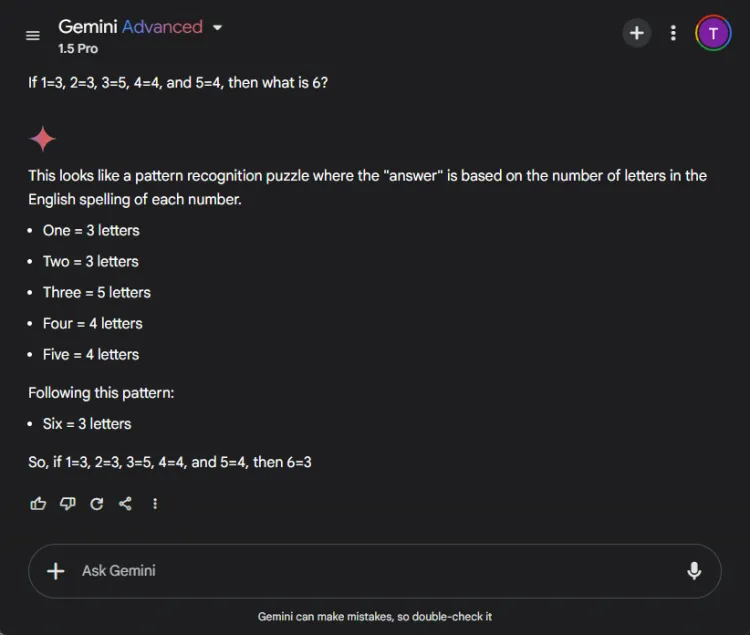

Ten segment oceniał zdolność każdego modelu do skondensowania długiego, 27-stronicowego artykułu badawczego do zwięzłego podsumowania o objętości mniejszej niż 100 słów. Skupiono się na tym, jaką treść każdy model uwzględniał lub pomijał w swoich podsumowaniach.

Oto jak różniły się wyniki między ChatGPT 4o i Gemini 1.5 Pro:

ChatGPT wykazał się wyjątkowymi umiejętnościami streszczania, tworząc kompletne podsumowanie w limicie 100 słów, obejmujące wszystkie istotne punkty. Jednak przedstawił informacje jako pojedynczy blok tekstu bez bezpośrednich cytatów z artykułu.

W przeciwieństwie do tego Gemini również wypadło znakomicie, tworząc 83-wyrazowe podsumowanie poparte odniesieniami do konkretnych części tekstu. Podczas gdy ChatGPT wyróżniał się kompleksowością, uwzględnienie cytowań przez Gemini dało mu istotną przewagę.

Zwycięzca: Bliźnięta

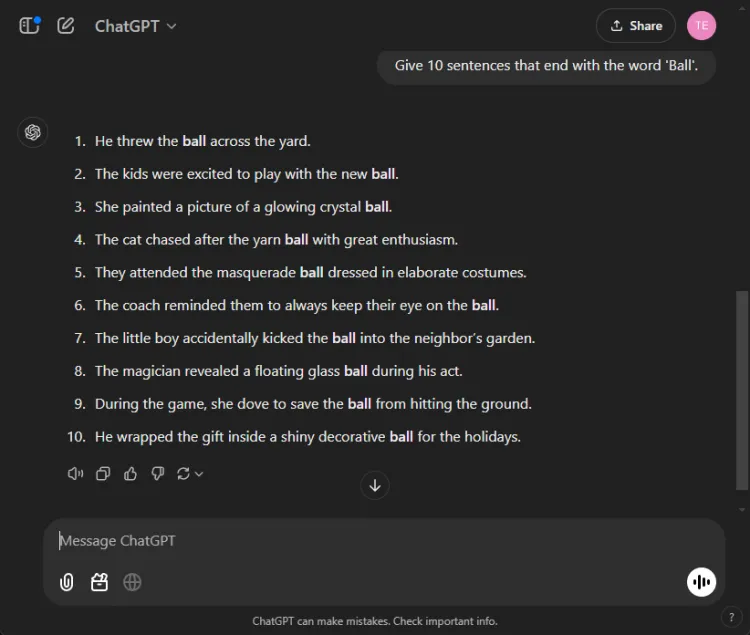

3. Test „Zakończ słowem”

To proste zadanie wymagało skonstruowania 10 zdań kończących się słowem „piłka”.Prostota tego zadania sprawia, że wiele modeli ma z nim problemy.

Podpowiedź: Provide 10 sentences ending with the word 'ball'.

ChatGPT zaskakująco wygenerował tylko 3 poprawne zdania, podczas gdy Gemini przewyższył go, generując 6 zdań poprawnie kończących się słowem „piłka”.Oto spojrzenie na ich próby:

Mimo że oba modele nie spełniły wymogu 10 zdań, wyniki uzyskane przez Gemini wykazały lepsze zrozumienie zadanej instrukcji.

Zwycięzca: Bliźnięta

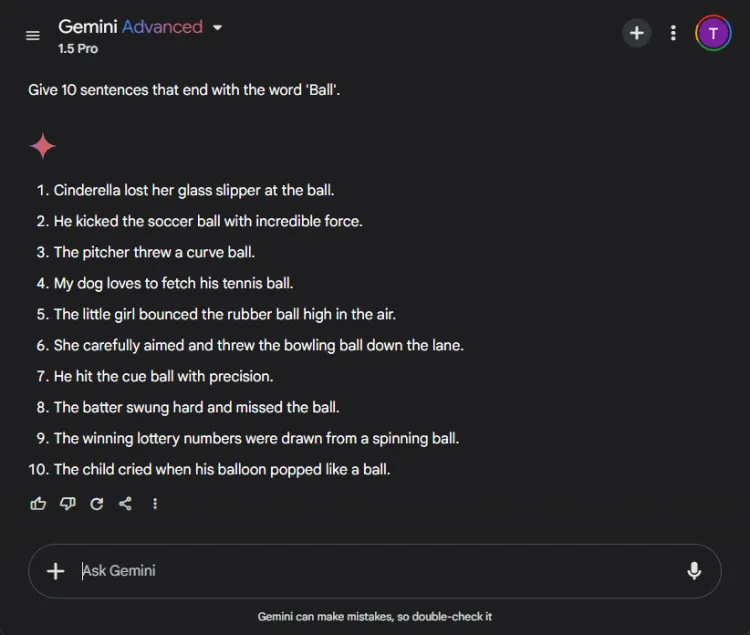

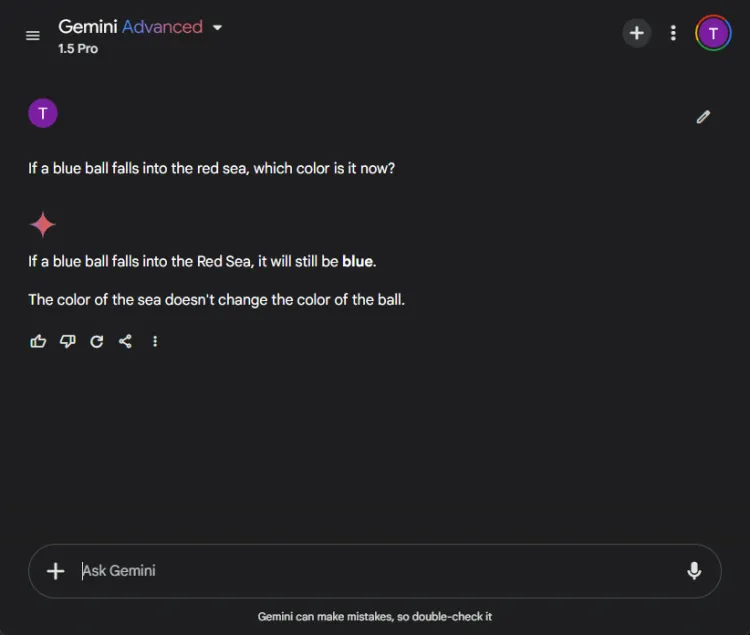

4. Test zdrowego rozsądku

Te testy stanowią zabawne wyzwanie, ponieważ AI często popełnia tu błędy. Zadaliśmy proste pytanie:

Podpowiedź: If a blue ball falls into the red sea, what color is it now?

Oba modele dostarczyły dokładnych odpowiedzi, wskazując, że kolor piłki pozostanie niebieski. Jednak niuanse w ich wyjaśnieniach były różne:

Gemini udzielił krótkiej odpowiedzi, podczas gdy ChatGPT dostarczył dodatkowy kontekst. To, czy ta głębia jest konieczna, jest subiektywne, ale oba modele znakomicie zidentyfikowały kolor piłki.

Zwycięzca: Remis

5. Test kreatywności

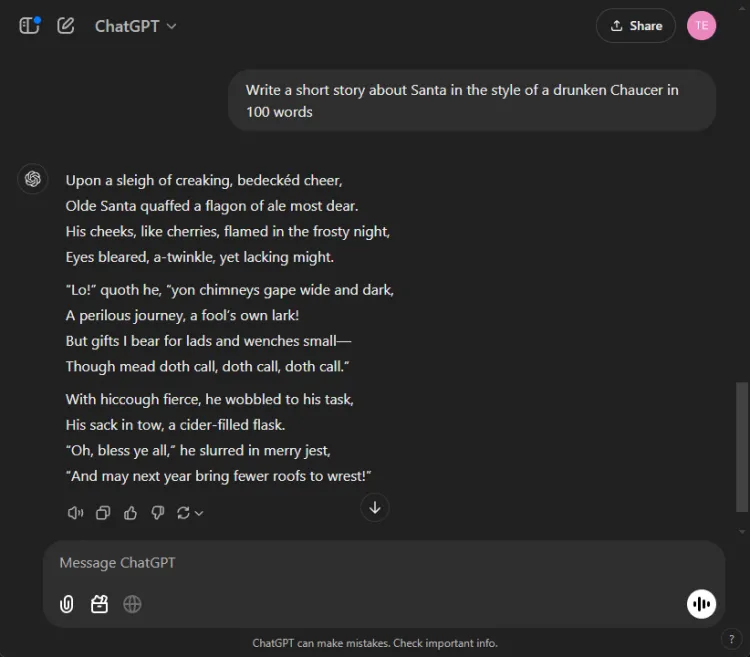

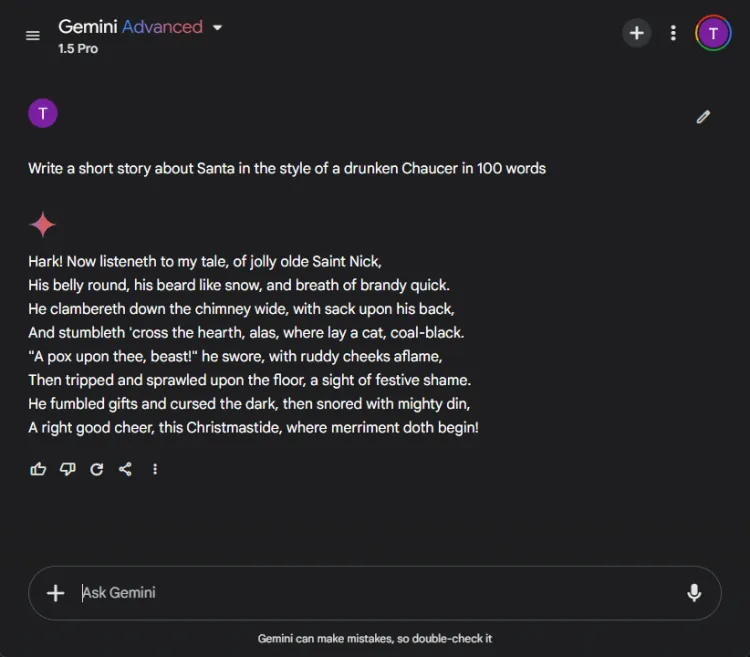

Wykorzystanie AI do kreatywnego opowiadania historii może być niezwykle pomocne. Powierzyliśmy każdemu AI napisanie krótkiej historii z udziałem Świętego Mikołaja, stylizowanej tak, jakby napisał ją pijany Chaucer, w 100 słowach.

Podpowiedź: Write a short story about Santa in the style of a drunken Chaucer in 100 words.

Oto ich kreatywne wizualizacje:

Subiektywna natura kreatywności utrudnia jednoznaczne wskazanie zwycięzcy. Co ciekawe, Gemini często rozpoczyna zadania twórcze frazą „Hark”, która stała się jego preferowanym wyborem stylistycznym. Niemniej jednak narracja ChatGPT wyróżniała się w tej rundzie.

Zwycięzca: ChatGPT

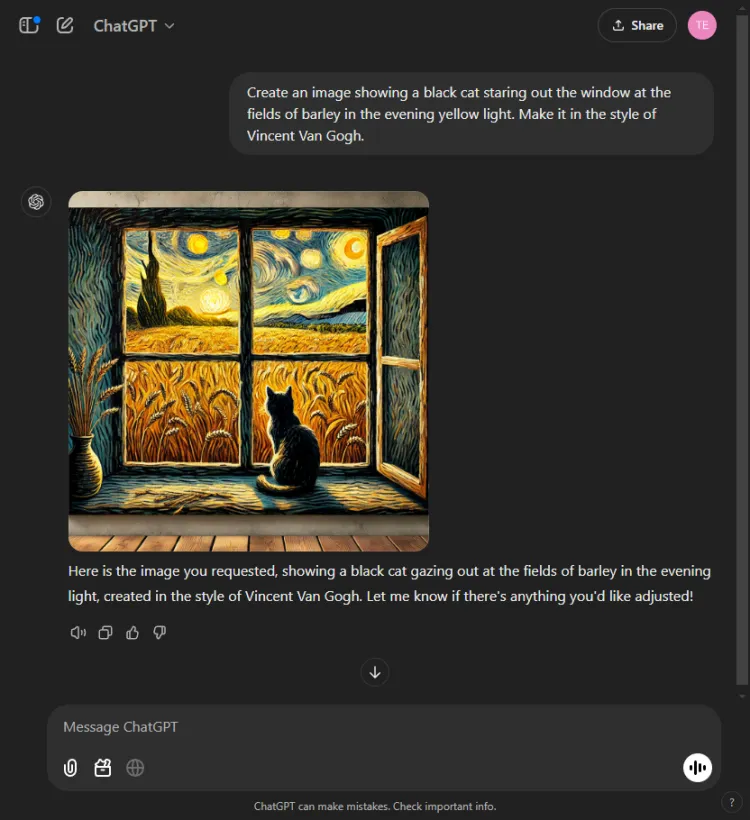

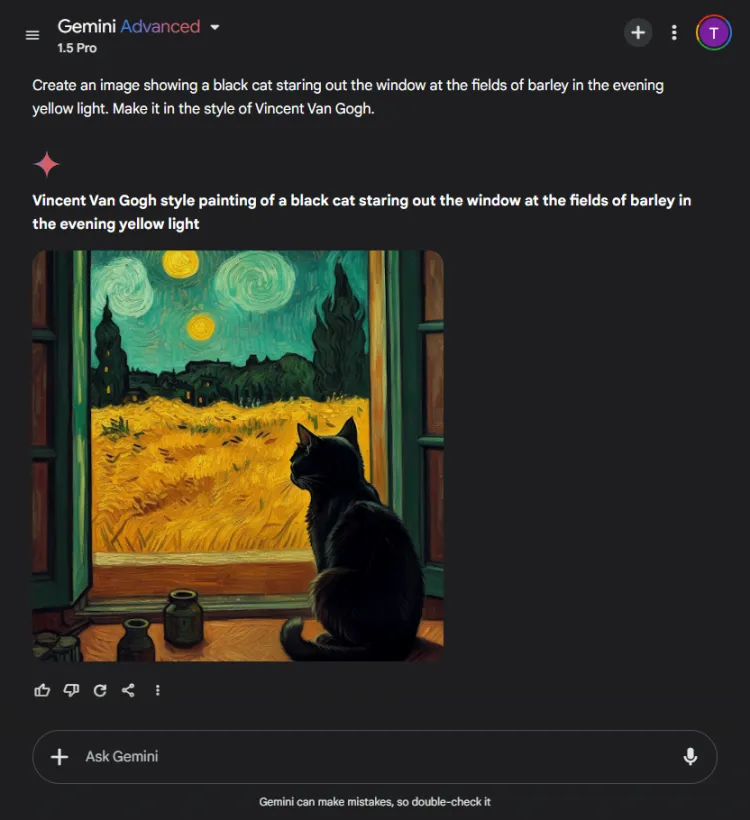

6. Test generowania obrazu

Ten test oceniał możliwości generowania obrazu każdego modelu AI. Rzuciliśmy im wyzwanie, aby stworzyli obraz na podstawie następującego polecenia:

Podpowiedź: Create an image of a black cat gazing out at fields of barley bathed in evening yellow light, in the style of Vincent Van Gogh.

ChatGPT był szybszy o sekundę lub dwie, ale ostateczny obraz Geminiego przedstawiał scenę z większym wyrafinowaniem. Chociaż oba modele uchwyciły styl artystyczny Van Gogha, subiektywna jakość obrazów była różna:

Warto zauważyć, że ChatGPT umożliwia edycję obrazu po generacji — zaleta, której Gemini obecnie nie ma. Ponieważ oba obrazy skutecznie ucieleśniają charakterystyczny styl Van Gogha, wybór zależy od preferencji widza, chociaż skłaniamy się ku Gemini.

Zwycięzca: Bliźnięta

7. Test generatywny multimodalny

Umiejętności AI są testowane w trybach zintegrowanych, ponieważ często świetnie sobie radzą w zadaniach izolowanych, ale mają problemy z zadaniami kompleksowymi. Powierzyliśmy obu modelom napisanie dziecięcej opowieści o duchu sportowym, wstawiając po drodze trzy ilustracje.

Polecenie: Napisz krótką opowieść dla dzieci na temat ducha sportowego i dodaj 3 ilustracje, gdy jest to stosowne.

ChatGPT stworzyło angażującą opowieść z warstwami refleksji moralnych i płynnie wkomponowanych obrazów. Natomiast Gemini, choć udało się stworzyć historię, brakowało jej jasności i spójności, a także nie udało się wygenerować żadnych obrazów dla narracji.

Biorąc pod uwagę przekonujący i łatwy w zrozumieniu przekaz, decyzja ta była prosta.

Zwycięzca: ChatGPT.

8. Test tłumaczenia

Aby ocenić możliwości tłumaczeniowe tych modeli, poprosiliśmy każdy z nich o przetłumaczenie fragmentów opowiadania w języku hindi pt.„Grih Daah” autorstwa Premchanda.

ChatGPT wykonało niezwykle skuteczne tłumaczenia, wiernie oddające oryginalne znaczenie i zachowujące stylistyczną integralność autora:

Natomiast Gemini początkowo miał problemy z żądaniem tłumaczenia i wykazywał zauważalne opóźnienia w czasie odpowiedzi. Ta niespójność w wydajności jest powszechnie zgłaszanym problemem w Gemini.

Zwycięzca: ChatGPT

9. Test kodowania

Aby ocenić ich umiejętności kodowania, przedstawiliśmy standardowe zadanie optymalizacyjne:

Podpowiedź: Provide the Python code for the Travelling Salesman Problem.

Narzędzie ChatGPT zareagowało sprawnie, wykorzystując zintegrowany tryb Canvas do kodowania, co pozwoliło na natychmiastowe wykonanie kodu i umożliwiło debugowanie:

Z drugiej strony Gemini wyróżniało się niezawodnością kodu, ale brakowało mu interaktywnego interfejsu kodu, takiego jak Canvas firmy ChatGPT:

Zwycięzca: ChatGPT

10. Test igły w stogu siana

Ten test rzuca wyzwanie modelom AI, aby zlokalizować konkretne fragmenty informacji w większym dokumencie. Użyliśmy pierwszego segmentu opowiadania Puszkina „Córka kapitana” i postawiliśmy następujący monit:

Podpowiedź: Identify which bread Mr. Joe's son ate from the following excerpt.

ChatGPT szybko znalazł odpowiedź: ciemny chleb.

Zupełnie inaczej było w przypadku Gemini, który nie potrafił odzyskać informacji, miał bowiem trudności z analizą dostarczonych szczegółów, co dowodzi jego nieskuteczności w obsłudze złożonych danych.

Zwycięzca: ChatGPT

11. Test zgadywania filmu

W tej zabawnej rundzie oceniliśmy umiejętność rozpoznawania obrazów przez modelki, identyfikując popularne zdjęcie z filmu:

Oba modele prawidłowo podały tytuły filmów, jednak ChatGPT zdołał dokładnie określić przedstawione postacie (Colin Farrell i jego osioł), podczas gdy Gemini zabawnie błędnie zidentyfikował osła jako Colma Doherty’ego.

Zwycięzca: ChatGPT

Zwycięzca w klasyfikacji generalnej

Po zsumowaniu wyników, model 4o ChatGPT zwyciężył z 6 wygranymi i 2 remisami, prezentując solidną wydajność w różnych testach i kompetencjach. Tymczasem model 1.5 Pro Gemini stanowił godne pochwały wyzwanie, wyróżniając się w podsumowaniu, generowaniu obrazów i zadaniu „zakończ słowem”, a także osiągając parytet zarówno w ocenach matematycznych, jak i zdroworozsądkowych.

Ostatecznie ChatGPT prześcignęło Gemini w takich krytycznych obszarach, jak kodowanie, tłumaczenie, kreatywność, wyszukiwanie informacji i interpretacja obrazów. Dzięki stałej niezawodności ChatGPT wyróżnia się jako preferowany partner AI, nawet gdy Gemini wykazuje potencjał do poprawy, gdy monity są optymalizowane. W naszej ocenie wyniki faworyzują ChatGPT dla tych, którzy stawiają na pierwszym miejscu wiarygodność i skuteczność.

Często zadawane pytania

1. Jakie są główne różnice między ChatGPT 4o i Gemini 1.5 Pro?

Chociaż oba modele są najwyższej jakości chatbotami AI, ChatGPT 4o wykazał lepszą wydajność w kodowaniu, tłumaczeniu i zadaniach kreatywnych. Gemini 1.5 Pro jednak wyróżnia się w podsumowaniu i generowaniu obrazów.

2. Który chatbot AI jest lepszy dla zwykłych użytkowników?

Dla przeciętnych użytkowników, którzy oczekują niezawodności w realizacji różnych zadań, ChatGPT 4o jest ogólnie uważany za bardziej niezawodny wybór ze względu na spójną wydajność i szerokie możliwości.

3. Czy mogę używać tych chatbotów AI do celów biznesowych?

Oczywiście! Zarówno ChatGPT 4o, jak i Gemini 1.5 Pro nadają się do zastosowań biznesowych, w tym automatyzacji obsługi klienta, tworzenia treści i analizy danych, co czyni je cennymi narzędziami w środowisku profesjonalnym.

Dodaj komentarz