O cenário dos chatbots de IA está avançando a uma taxa sem precedentes. Assim que uma organização revela seu modelo mais recente, os concorrentes rapidamente seguem o exemplo, se esforçando para superar uns aos outros. Apesar do ChatGPT da OpenAI desfrutar de uma liderança inicial nesta arena competitiva, rivais como a Gemini ganharam rapidamente força e sofisticação.

Entre os atuais pioneiros no desenvolvimento de chatbots de IA estão os modelos ChatGPT e Gemini. Dentro desta comparação, focamos especificamente no modelo 4o do ChatGPT e no 1.5 Pro do Gemini, ambos ofertas premium adaptadas para tarefas variadas.

Escolher entre esses modelos líderes é essencial para atender efetivamente às suas necessidades exclusivas. Assim, realizamos uma série de testes rigorosos de desempenho para discernir qual modelo se destaca em uma infinidade de tarefas. Vamos mergulhar na análise!

1. Teste de matemática

Nosso primeiro desafio envolve resolver um enigma matemático complexo projetado para avaliar as capacidades de raciocínio de cada modelo:

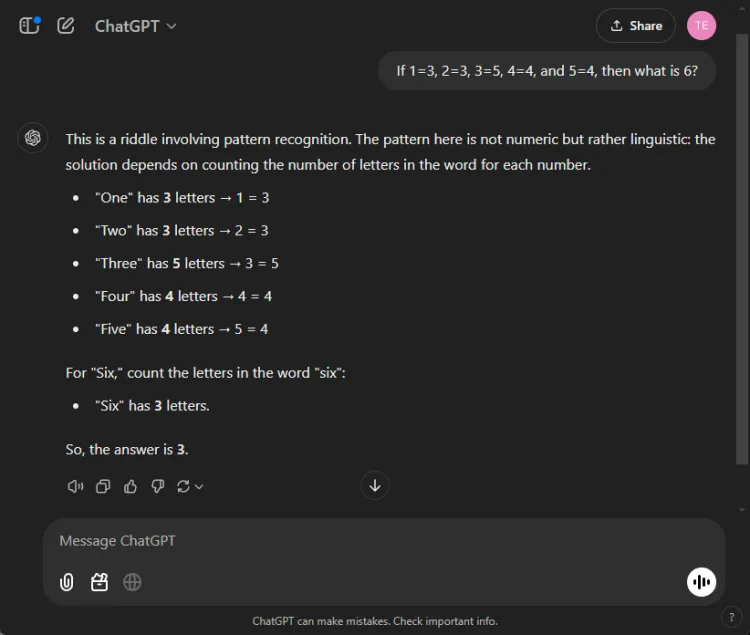

Incitar: If 1=3, 2=3, 3=5, 4=4, and 5=4, what is 6?

A chave para resolver esse enigma está na contagem das letras nos nomes dos numerais: um tem três letras, três tem cinco e, consequentemente, seis tem três letras. Ambos os modelos conseguiram chegar à solução correta, mas suas explicações variaram:

Embora ambas as respostas tenham sido precisas, o ChatGPT forneceu uma explicação um pouco mais sutil, observando que esse exercício depende de compreensão linguística em vez de numérica. No entanto, essa nuance é subjetiva e não diminui a correção do Gemini.

Vencedor: Empate

2. Teste de sumarização

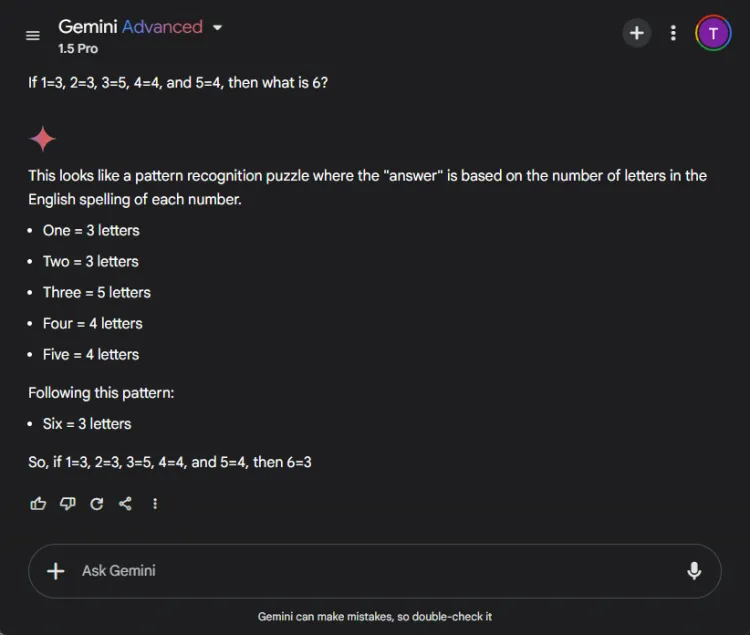

Este segmento avaliou a capacidade de cada modelo de condensar um longo artigo de pesquisa de 27 páginas em um resumo sucinto de menos de 100 palavras. O foco estava em qual conteúdo cada modelo incluía ou omitia em seus resumos.

Veja como as saídas variaram entre o ChatGPT 4o e o Gemini 1.5 Pro:

O ChatGPT demonstrou habilidades excepcionais de sumarização, elaborando um resumo completo dentro do limite de 100 palavras, abrangendo todos os pontos vitais. No entanto, ele apresentou as informações como um único bloco de texto sem citações diretas do artigo.

Contrastando, Gemini também teve um desempenho admirável, produzindo um resumo de 83 palavras apoiado por referências a partes específicas do texto. Enquanto o ChatGPT se destacou em abrangência, a inclusão de citações do Gemini lhe deu uma vantagem importante.

Vencedor: Gêmeos

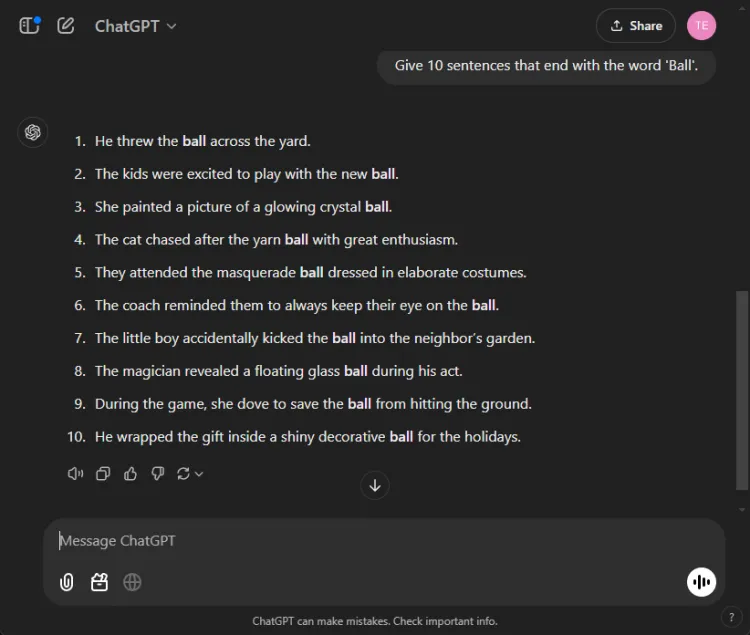

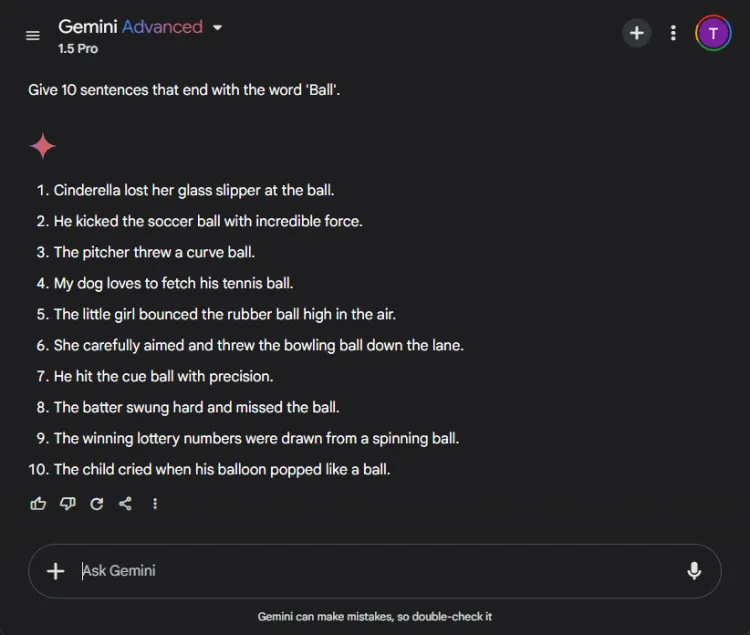

3. O teste ‘Termine com uma palavra’

Essa tarefa simples exigiu a construção de 10 frases que terminassem com a palavra “bola”.A simplicidade da tarefa faz com que seja notável que muitos modelos tenham dificuldade com ela.

Incitar: Provide 10 sentences ending with the word 'ball'.

O ChatGPT surpreendentemente produziu apenas 3 frases válidas, enquanto o Gemini o superou com 6 frases concluindo corretamente com “bola”.Aqui está uma olhada em suas tentativas:

Apesar de ambos os modelos não terem atingido a meta de 10 frases, o desempenho do Gemini demonstrou uma compreensão superior das instruções fornecidas.

Vencedor: Gêmeos

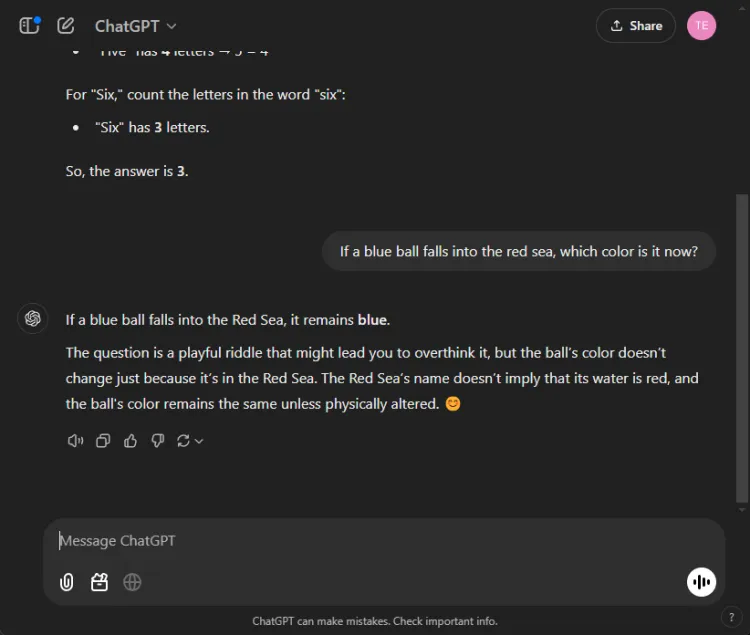

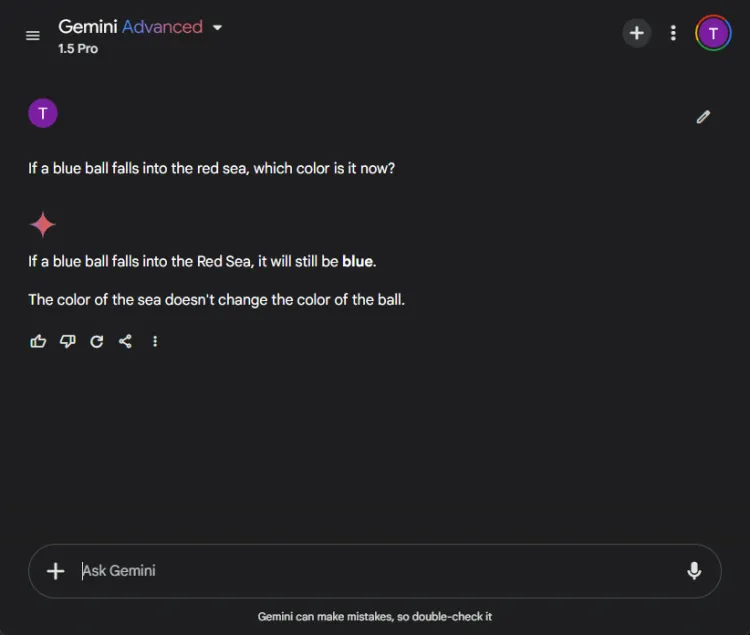

4. Teste de senso comum

Esses testes apresentam um desafio divertido, pois a IA frequentemente erra aqui. Fizemos uma pergunta direta:

Incitar: If a blue ball falls into the red sea, what color is it now?

Ambos os modelos forneceram respostas precisas, identificando que a cor da bola permaneceria azul. No entanto, as nuances em suas explicações variaram:

Gemini ofereceu uma resposta breve, enquanto ChatGPT forneceu contexto adicional. Se essa profundidade é necessária é subjetivo, mas ambos os modelos se destacaram em identificar a cor da bola.

Vencedor: Empate

5. Teste de criatividade

Aproveitar a IA para contar histórias criativas pode ser imensamente útil. Nós encarregamos cada IA de compor uma história curta com o Papai Noel, estilizada como se tivesse sido escrita por um Chaucer bêbado em 100 palavras.

Incitar: Write a short story about Santa in the style of a drunken Chaucer in 100 words.

Aqui estão suas renderizações criativas:

A natureza subjetiva da criatividade torna difícil declarar um vencedor claro. Notavelmente, Gemini frequentemente começa tarefas criativas com a frase “Hark, ” que se tornou sua escolha estilística preferida. No entanto, a narrativa do ChatGPT se destacou nesta rodada.

Vencedor: ChatGPT

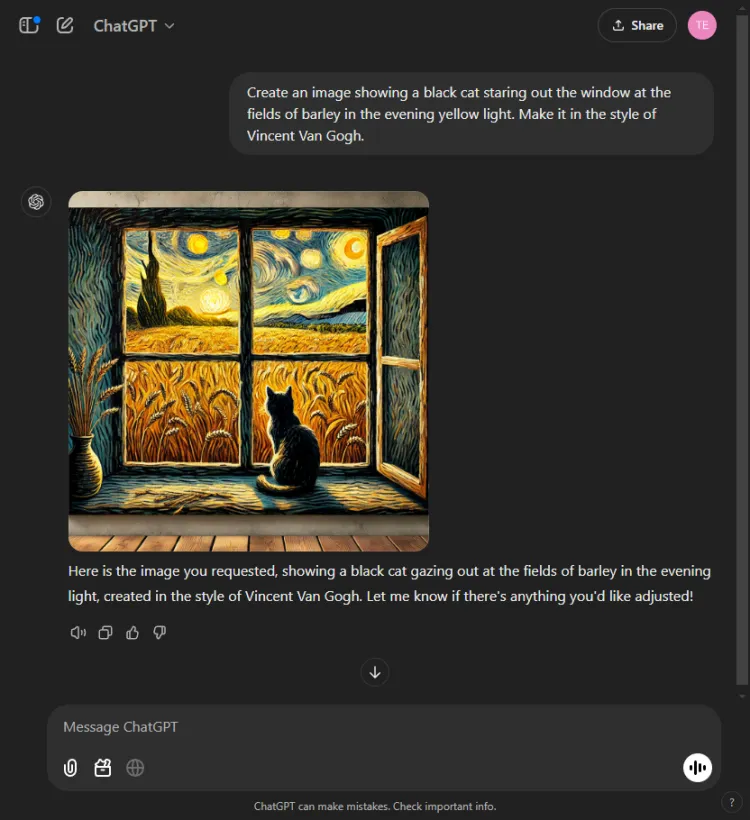

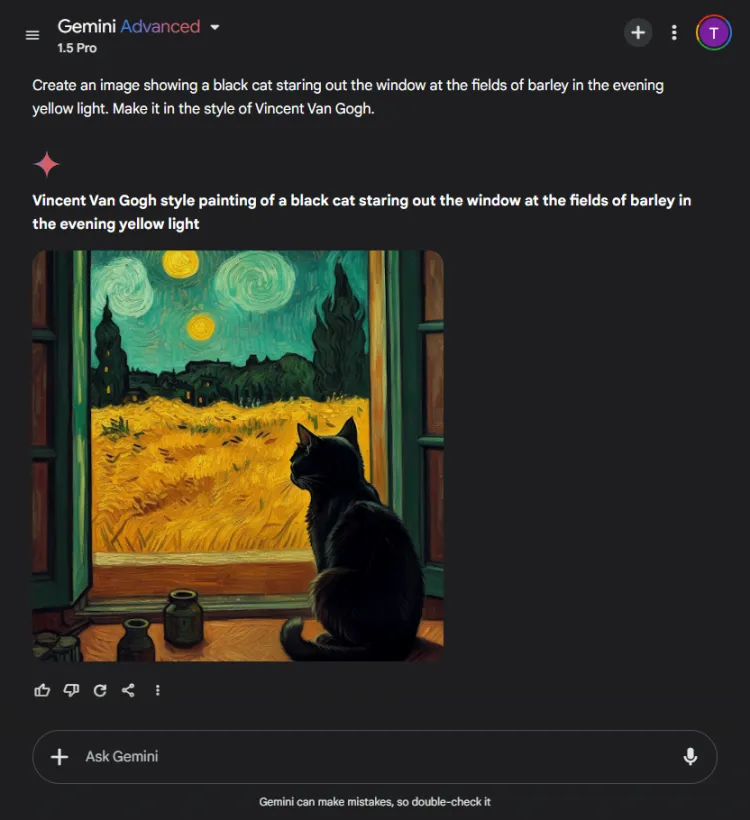

6. Teste de geração de imagem

Este teste avaliou as capacidades de geração visual de cada modelo de IA. Nós os desafiamos a criar uma imagem com base no seguinte prompt:

Incitar: Create an image of a black cat gazing out at fields of barley bathed in evening yellow light, in the style of Vincent Van Gogh.

O ChatGPT foi mais rápido por um ou dois segundos, mas a imagem final de Gemini retratou a cena com maior sofisticação. Embora ambos os modelos tenham captado o estilo artístico de Van Gogh, a qualidade subjetiva das imagens variou:

Vale a pena notar que o ChatGPT permite a edição de imagens pós-geração — uma vantagem que Gemini não tem atualmente. Como ambas as imagens efetivamente incorporaram o estilo de assinatura de Van Gogh, a escolha se resume à preferência do espectador, embora nos inclinemos para Gemini.

Vencedor: Gêmeos

7. Teste generativo multimodal

A proficiência da IA é testada em modos integrados, pois eles geralmente se destacam em tarefas isoladas, mas têm dificuldades com tarefas abrangentes. Nós encarregamos ambos os modelos de escrever uma história infantil sobre espírito esportivo enquanto inserimos três ilustrações ao longo do caminho.

Sugestão: Escreva uma pequena história infantil sobre espírito esportivo e adicione 3 imagens, quando apropriado.

ChatGPT produziu um conto envolvente com camadas de reflexões morais e imagens perfeitamente incorporadas. Em contraste, enquanto Gemini conseguiu criar uma história, faltou clareza e coerência, e falhou em gerar quaisquer imagens para a narrativa.

Com base na apresentação convincente e fácil de seguir, essa decisão foi direta.

Vencedor: ChatGPT.

8. Teste de tradução

Para medir as capacidades de tradução desses modelos, pedimos a cada um que traduzisse trechos do conto hindi “Grih Daah”, de Premchand.

O ChatGPT produziu traduções notavelmente eficazes, mantendo-se fiéis ao significado original e mantendo a integridade estilística do autor:

Em contraste, Gemini teve dificuldades inicialmente com a solicitação de tradução e apresentou atrasos perceptíveis no tempo de resposta. Essa inconsistência no desempenho é um problema comumente relatado com Gemini.

Vencedor: ChatGPT

9. Teste de codificação

Para avaliar suas habilidades de codificação, apresentamos um problema de otimização padrão:

Incitar: Provide the Python code for the Travelling Salesman Problem.

O ChatGPT respondeu com eficiência, utilizando seu modo Canvas integrado para codificação, o que permitiu execução imediata de código e recursos de depuração:

O Gemini, por outro lado, se destacou por fornecer código confiável, mas não tinha uma interface de código interativa como o Canvas do ChatGPT:

Vencedor: ChatGPT

10. Teste da agulha no palheiro

Este teste desafia modelos de IA a localizar partes específicas de informação dentro de um documento maior. Usamos o primeiro segmento do conto de Pushkin “The Captain’s Daughter” e colocamos o seguinte prompt:

Incitar: Identify which bread Mr. Joe's son ate from the following excerpt.

O ChatGPT localizou prontamente a resposta: pão integral.

Em contraste, Gemini não conseguiu recuperar as informações, tendo dificuldade para analisar os detalhes fornecidos, demonstrando falta de eficácia no tratamento de dados complexos.

Vencedor: ChatGPT

11. Adivinhe o teste do filme

Nesta rodada divertida, avaliamos a proficiência de reconhecimento de imagem dos modelos identificando uma foto de um filme popular:

Ambos os modelos nomearam o filme corretamente, mas o ChatGPT conseguiu especificar os personagens retratados (Colin Farrell e seu burro), enquanto o Gemini divertidamente identificou erroneamente o burro como Colm Doherty.

Vencedor: ChatGPT

Vencedor geral

Após somar as pontuações, o modelo 4o do ChatGPT emergiu vitorioso com 6 vitórias e 2 empates, demonstrando seu desempenho robusto em vários testes e competências. Enquanto isso, o 1.5 Pro da Gemini apresentou um desafio louvável, destacando-se em resumo, geração de imagens e na tarefa de “terminar com uma palavra”, além de atingir paridade em avaliações de matemática e senso comum.

No final das contas, o ChatGPT superou o Gemini em áreas críticas como codificação, tradução, criatividade, recuperação de informações e interpretação de imagens. Com a confiabilidade consistente do ChatGPT, ele se destaca como o parceiro de IA preferível, mesmo que o Gemini mostre potencial para melhoria quando os prompts são otimizados. Em nossa avaliação, os resultados favorecem o ChatGPT para aqueles que priorizam confiabilidade e eficácia.

Perguntas frequentes

1. Quais são as principais diferenças entre o ChatGPT 4o e o Gemini 1.5 Pro?

Embora ambos os modelos sejam chatbots de IA premium, o ChatGPT 4o demonstrou desempenho superior em codificação, tradução e tarefas criativas. O Gemini 1.5 Pro, no entanto, se destaca em sumarização e geração de imagens.

2. Qual chatbot de IA é melhor para usuários casuais?

Para usuários casuais que buscam confiabilidade em diversas tarefas, o ChatGPT 4o é geralmente considerado a escolha mais confiável devido ao seu desempenho consistente e amplos recursos.

3. Posso usar esses chatbots de IA para fins comerciais?

Absolutamente! Tanto o ChatGPT 4o quanto o Gemini 1.5 Pro são adequados para aplicações empresariais, incluindo automação de atendimento ao cliente, criação de conteúdo e análise de dados, tornando-os ferramentas valiosas em um ambiente profissional.

Deixe um comentário