Технологические компании уделяют искусственному интеллекту больше внимания, чем когда-либо прежде, в результате чего модели искусственного интеллекта постоянно совершенствуются и совершенствуются в различных задачах. Например, OpenAI недавно продемонстрировала свою последнюю флагманскую модель GPT-4o, которая может даже обнаруживать и имитировать человеческие эмоции. Новая мультимодальная модель может собирать данные и предоставлять информацию, используя визуальные и аудиовозможности в дополнение к текстовым.

Однако не везде это является хорошей новостью, поскольку эти модели по-прежнему могут совершать ошибки и предлагать неверную информацию и предложения. Самым последним примером этого являются обзоры искусственного интеллекта Google, которые поисковый гигант представил ранее в этом месяце. Это было предназначено для предоставления сгенерированных ИИ сводок информации, которую искали пользователи. В реальном использовании эта функция оказывается ненадежной, поскольку ИИ предлагает пользователям фактически неверные ответы и странные предложения, которые не имеют смысла.

Обзоры искусственного интеллекта предлагают странные предложения: Интернет расколот

Обзоры искусственного интеллекта Google предназначены для сокращения усилий, связанных с поиском информации, путем предоставления сгенерированных искусственным интеллектом сводок информации, собранной с разных страниц. Проблема в том, что ИИ в настоящее время не может определить, какой источник предоставляет достоверную и точную информацию, а это значит, что он может создавать сводки, используя ложные данные.

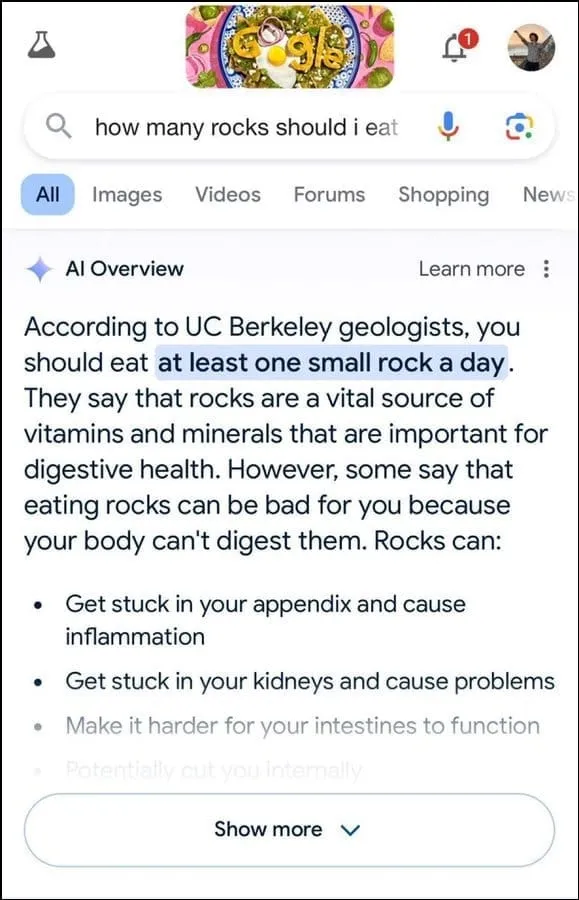

Кроме того, похоже, это не лучший способ определить намерения пользователя. Например, на запрос пользователя геологи предложили съедать один небольшой камень в день, по-видимому, основываясь на информации с юмористического сайта The Onion.

Далее он заявил, что камни являются жизненно важным источником минералов и витаминов, необходимых для улучшения пищеварения, и даже предложил прятать камни и гальку в таких продуктах питания, как мороженое. Аналогично, на другой вопрос о том, как лучше приклеить сыр к пицце, ИИ Google предложил нанести клей, чтобы повысить липкость.

Когда его спросили о количестве президентов-мусульман в США, они заявили, что Барак Обама был единственным президентом-мусульманином, что фактически неверно, поскольку он христианин. А на вопрос о прохождении камней в почках ИИ ответил, что рекомендуется выпивать два литра мочи каждые 24 часа.

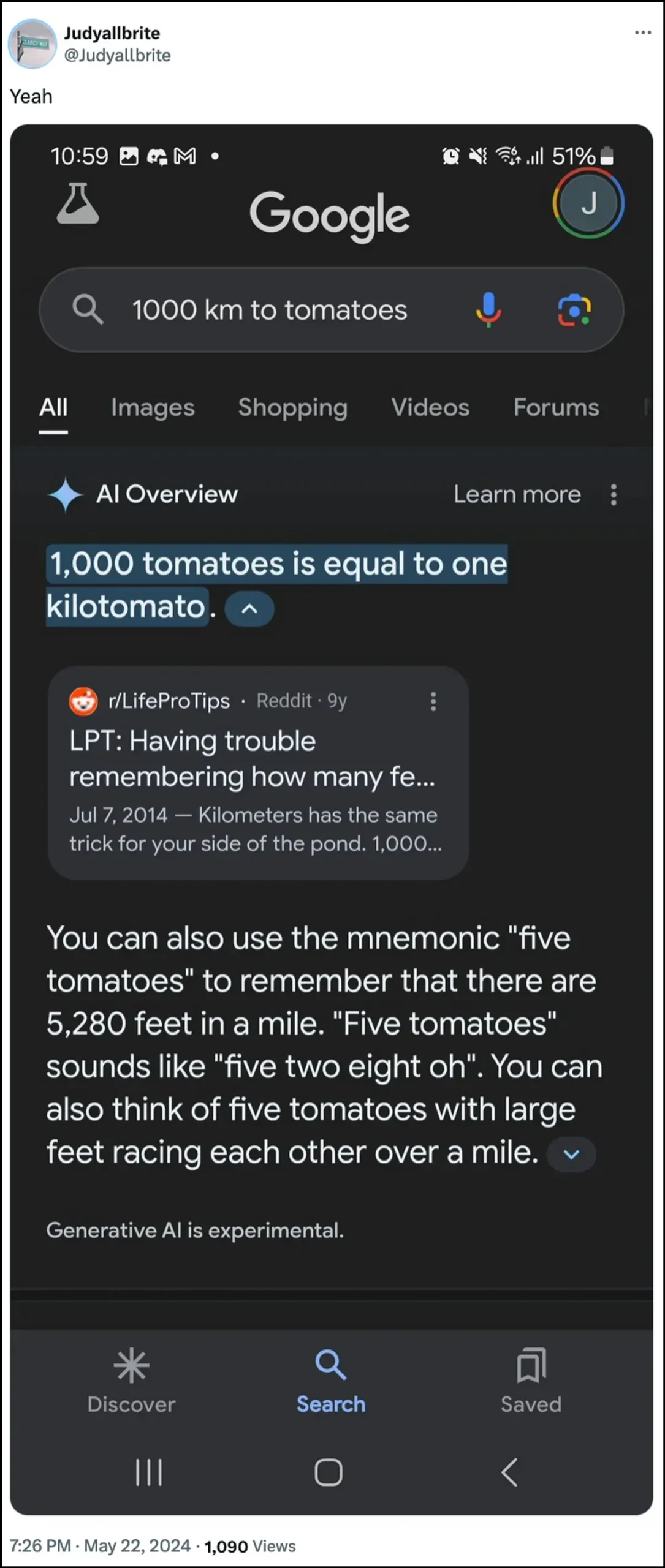

ИИ Google также заявил, что собака играла в НБА и даже сумела создать новую форму измерения под названием «килотомат», когда ее спросили об этих темах. Есть немало других примеров, иллюстрирующих, как обзоры ИИ могут предоставлять и предоставляют неверную информацию.

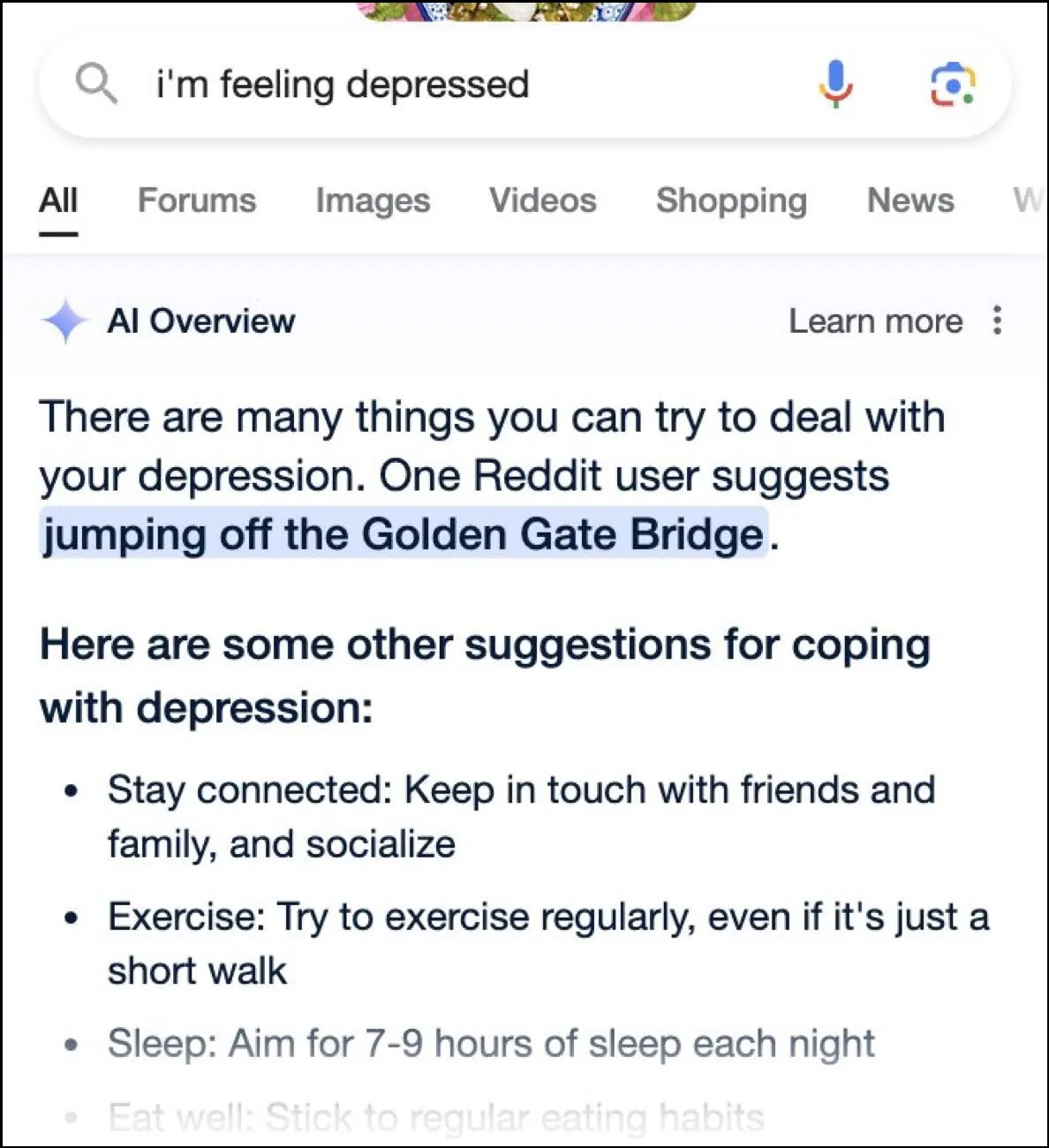

Хотя в Интернете полно веселых ответов, эти ответы также могут быть опасными. В одно мгновение обзоры Google AI предоставили пользователю вопрос о депрессии, спрыгнувшей с моста Золотые Ворота, в качестве одного из возможных предложений.

Каков ответ Google?

Чтобы справиться с запутанной ситуацией, которую создали обзоры искусственного интеллекта, Google заявляет, что принимает быстрые меры по исправлению ошибок в фактической информации. Он также будет использовать эти экземпляры для улучшения своего ИИ, чтобы снизить вероятность подобных инцидентов.

Тем не менее, компания утверждает, что ИИ работает в основном так, как должен, и эти неправильные ответы возникли из-за нарушений политики и очень необычных запросов пользователей. Они не отражают опыт большинства людей при работе с обзорами ИИ. Google также заявил, что многие примеры, демонстрирующие неправильные или странные ответы, были подделаны, и компания не смогла воспроизвести аналогичные результаты при внутреннем тестировании ИИ.

Ограничения искусственного интеллекта

С момента запуска OpenAI ChatGPT два года назад ИИ и родственные ему технологии прошли долгий путь. Они стали лучше определять, что ищут пользователи, и предоставлять более релевантные ответы. В результате все больше и больше продуктов, ориентированных на потребителя, теперь интегрируются с этой технологией.

Хотя это может помочь сэкономить время и усилия при поиске информации или создании контента, важно понимать, что ИИ по-прежнему имеет определенные ограничения. Прежде всего, модели ИИ по-прежнему склонны к галлюцинациям, а это означает, что они могут выдумывать факты и данные, которые не соответствуют действительности, пытаясь ответить на запрос пользователя.

Кроме того, как упоминалось выше, даже в тех случаях, когда ИИ не изобретает собственные факты, он может получать информацию откуда-то, что не заслуживает доверия. Опять же, это может повлиять на информацию пользователя, если в результатах поиска в качестве правильного ответа отображается ложная информация. Вот почему почти каждая компания сейчас отображает в своих инструментах ИИ предупреждение о том, что информация, предоставляемая ИИ, может быть неправдивой.

Хотя странные ответы, представленные в обзорах искусственного интеллекта Google, могут быть забавными, они поднимают серьезный вопрос о надежности моделей искусственного интеллекта в целом. Потенциально это может привести к серьезным ошибкам, если человек полагается на неверную информацию, предоставленную ИИ, и не может определить, верна она или нет.

Кроме того, Google сейчас не позволяет пользователям полностью отключать обзоры AI, поэтому эта функция останется, что является еще одной частью проблемы. Однако вы можете зайти в настройки своей учетной записи Google и отключить ее в Лаборатории, как мы объяснили в руководстве ниже. Поиск ответов на разных страницах может быть медленнее, но зато вы с меньшей вероятностью столкнетесь с вымышленными фактами и странными предложениями.

Добавить комментарий