Apple hat eine neue KI-Funktion namens Visual Intelligence eingeführt, die mit dem kommenden iOS 18.2-Update eingeführt werden soll. Unsere praktischen Erfahrungen mit der neuesten Beta zeigen eine Reihe spannender Funktionen. Visual Intelligence verwandelt Ihre Kamera in ein hochentwickeltes, KI-gesteuertes Tool, ähnlich wie Google Lens.

Was genau ist visuelle Intelligenz?

Während Siri als sprachinteraktive KI dient, um auf Ihre Anfragen zu antworten, fungiert Visual Intelligence als visuell orientierte KI, die es Ihnen ermöglicht, Ihre Kamera auf verschiedene Objekte zu richten, um Informationen zu sammeln oder schnelle Aufgaben auszuführen.

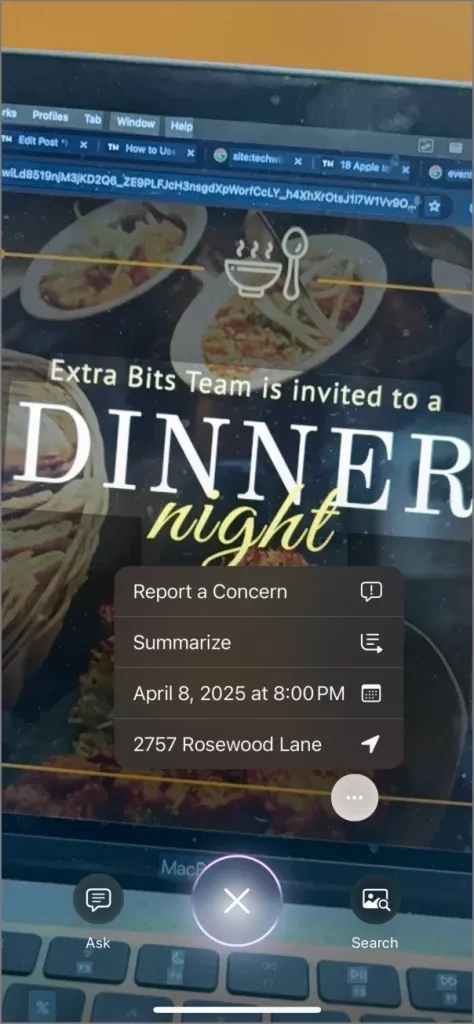

Wenn Sie beispielsweise mit Ihrem iPhone auf ein Restaurant zielen, werden dessen Bewertungen und Öffnungszeiten direkt aus Apple Maps angezeigt und möglicherweise sogar die Speisekarte. Wenn Sie einen Veranstaltungsflyer scannen, werden Sie möglicherweise automatisch aufgefordert, die Veranstaltung Ihrem Kalender hinzuzufügen oder eine Wegbeschreibung zum Veranstaltungsort abzurufen. So müssen Sie die Daten nicht mehr manuell eingeben.

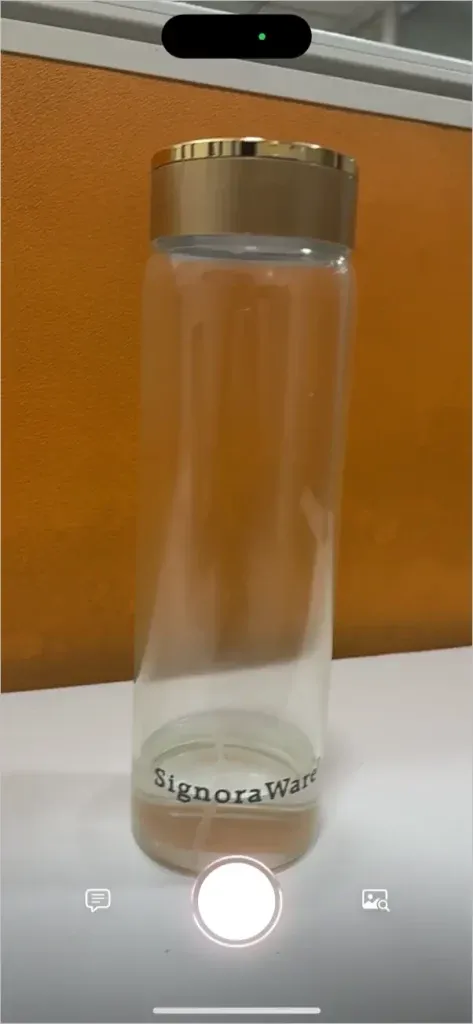

Richten Sie Ihre Kamera einfach auf einen beliebigen Gegenstand, um mit ChatGPT Informationen abzurufen oder ähnliche Bilder über Google zu finden. So können Sie die Art eines Tieres oder einer Pflanze bestimmen oder sogar herausfinden, wo Sie ein Produkt online kaufen können.

Betrachten Sie Visual Intelligence als eine hochintegrierte Iteration von Google Lens mit deutlichen Verbesserungen von Apple. Diese Funktion ist jedoch auf die iPhone 16-Serie beschränkt, die die Funktionen des A18-Chips nutzt.

So aktivieren Sie visuelle Intelligenz

Sie können über die Kamerasteuerungsfunktion des iPhone 16 nahtlos auf Visual Intelligence zugreifen. Es ist Teil des iOS 18.2-Updates, das sich derzeit in der ersten Entwickler-Beta befindet und voraussichtlich bis zum Jahresende öffentlich verfügbar sein wird. Um loszulegen, wechseln Sie entweder zum Beta-Kanal für das iOS 18.2-Update oder warten Sie auf die stabile Version.

- Drücken Sie lange auf die neue Kamerasteuerungstaste, um eine Benutzeroberfläche anzuzeigen, die einem Kamerasucher ähnelt und über eine Vorschau und Aufnahmeoptionen verfügt.

- Richten Sie nach der Aktivierung Ihre Kamera auf ein Objekt, zu dem Sie Informationen wünschen, und drücken Sie die Aufnahmetaste, um Visual Intelligence zu starten.

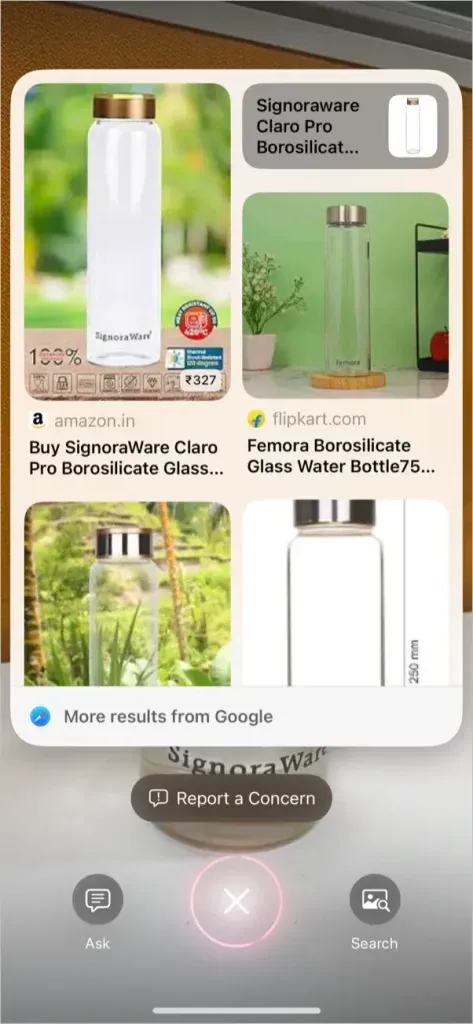

- Unabhängig vom Thema werden Ihnen immer zwei Auswahlmöglichkeiten angezeigt: „Fragen“ und „ Suchen“ .

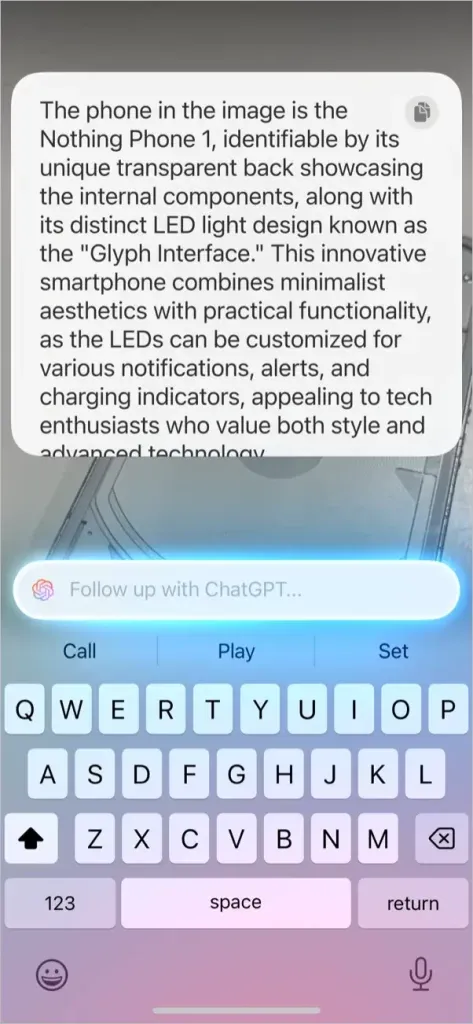

- Fragen : Sendet das Bild an ChatGPT, um an einem Gespräch teilzunehmen und mehr zu erfahren.

- Suche : Verwendet Google, um ähnliche Bilder oder Links zum Online-Kauf verwandter Artikel zu finden.

Visuelle Intelligenz im Alltag nutzen

- Richten Sie Ihr iPhone auf ein Wahrzeichen, um dessen Namen, seinen historischen Hintergrund, seine Öffnungszeiten und nahe gelegene Einrichtungen abzurufen.

- Betrachten Sie mit der Kamera Ihres iPhones ein Buchcover oder Produkt und verwenden Sie die Suchfunktion , um Rezensionen, Kaufoptionen und mehr zu finden.

- Richten Sie Ihr Telefon auf eine Pflanze oder ein Tier und nutzen Sie die Frage- oder Suchfunktion zur Artenidentifizierung sowie für zusätzliche Informationen wie Lebensraum, Artenmerkmale oder Pflegevorschläge.

- Richten Sie Ihre Kamera auf ein Veranstaltungsplakat und Visual Intelligence extrahiert den Namen, die Uhrzeit, das Datum und den Ort der Veranstaltung mit der Option, sie direkt Ihrem Kalender hinzuzufügen .

- Wenn Sie auf einen längeren Text stoßen, richten Sie Ihre Kamera einfach darauf, um eine kurze Zusammenfassung zu erhalten, oder lassen Sie ihn von ChatGPT in einfacherer Sprache erklären.

Obwohl Visual Intelligence ein unglaublich praktisches Tool ist, weist es einige Einschränkungen auf. Im Gegensatz zu Google Lens fehlt derzeit beispielsweise eine Videoaufzeichnungsoption, mit der große Objekte live gesucht werden können. Hoffentlich wird diese Funktion in zukünftigen Updates berücksichtigt.

31 versteckte iOS 18-Funktionen, die Sie ausprobieren müssen

Schreibe einen Kommentar