Wenn Sie Large Language Models oder LLMs auf Ihrem Computer ausführen möchten, ist Ollama eine der einfachsten Möglichkeiten. Ollama ist eine leistungsstarke Open-Source-Plattform, die ein anpassbares und leicht zugängliches KI-Erlebnis bietet. Sie erleichtert das Herunterladen, Installieren und Interagieren mit verschiedenen LLMs, ohne dass Sie auf Cloud-basierte Plattformen angewiesen sind oder technisches Fachwissen benötigen.

Zusätzlich zu den oben genannten Vorteilen ist Ollama recht leichtgewichtig und wird regelmäßig aktualisiert, was es für den Aufbau und die Verwaltung von LLMs auf lokalen Rechnern sehr geeignet macht. Sie benötigen also keine externen Server oder komplizierten Konfigurationen. Ollama unterstützt außerdem mehrere Betriebssysteme, darunter Windows, Linux und macOS, sowie verschiedene Docker-Umgebungen.

Herunterladen und Installieren von Ollama

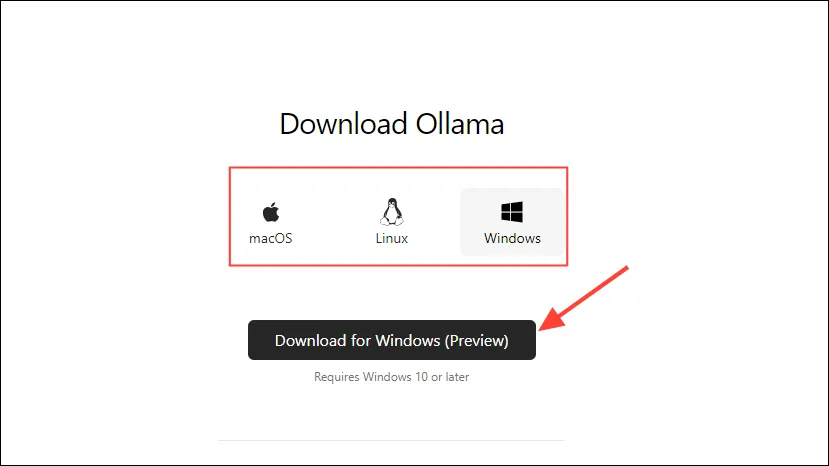

- Besuchen Sie zunächst die Ollama-Downloadseite und wählen Sie Ihr Betriebssystem aus, bevor Sie auf die Schaltfläche „Herunterladen“ klicken.

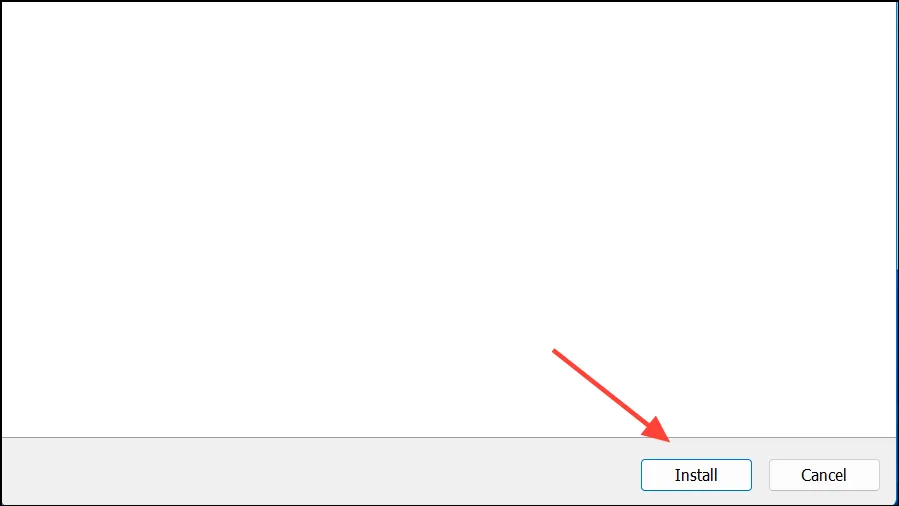

- Sobald der Download abgeschlossen ist, öffnen Sie es und installieren Sie es auf Ihrem Computer. Das Installationsprogramm wird nach Abschluss der Installation automatisch geschlossen.

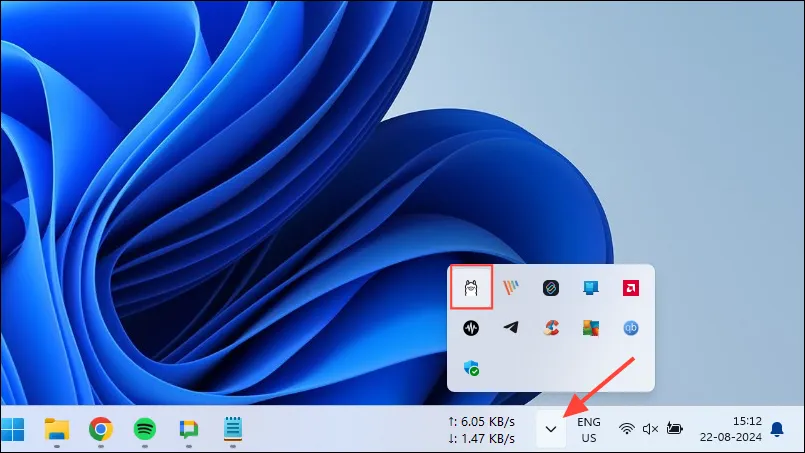

- Unter Windows können Sie überprüfen, ob Ollama ausgeführt wird oder nicht, indem Sie auf die Überlaufschaltfläche der Taskleiste klicken, um ausgeblendete Symbole anzuzeigen.

Anpassen und Verwenden von Ollama

Sobald Ollama auf Ihrem Computer installiert ist, sollten Sie als Erstes den Speicherort ändern. Standardmäßig ist der Speicherort, C:\Users\%username%\.ollama\modelsaber da KI-Modelle recht groß sein können, kann Ihr Laufwerk C schnell voll werden. Um dies zu tun,

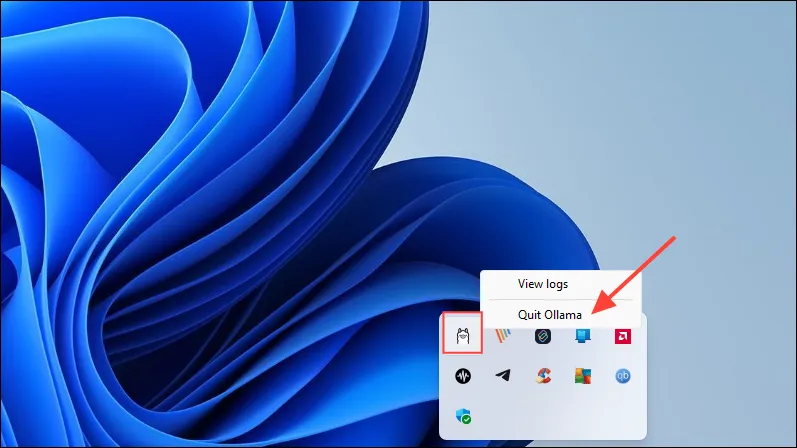

- Klicken Sie zunächst auf das Ollama-Symbol in der Taskleiste und dann auf „Ollama beenden“.

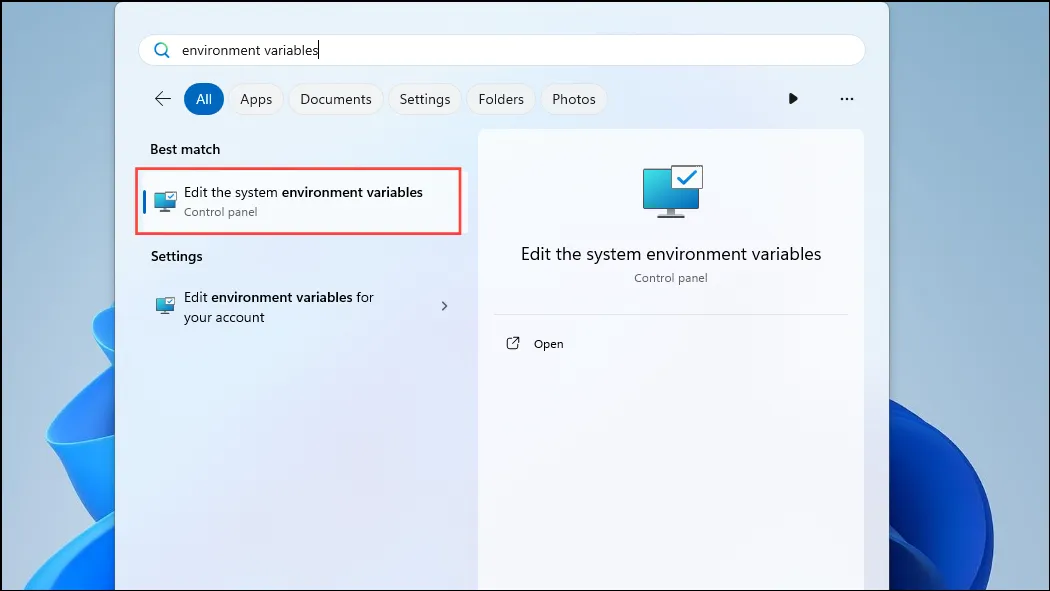

- Sobald Ollama beendet ist, öffnen Sie das Startmenü, geben Sie

environment variables„Systemumgebungsvariablen bearbeiten“ ein und klicken Sie darauf.

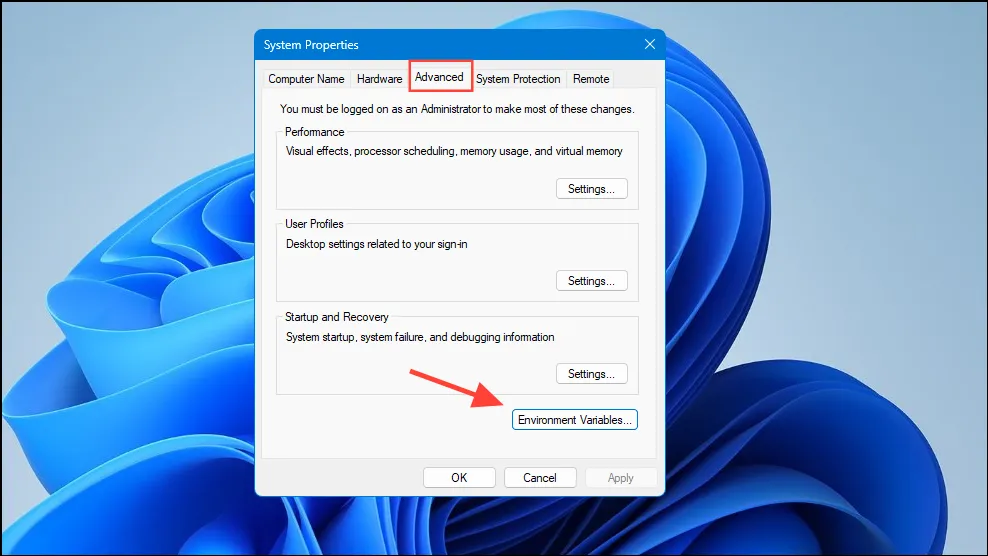

- Wenn das Dialogfeld „Systemvariablen“ geöffnet wird, klicken Sie auf der Registerkarte „Erweitert“ auf die Schaltfläche „Umgebungsvariablen“.

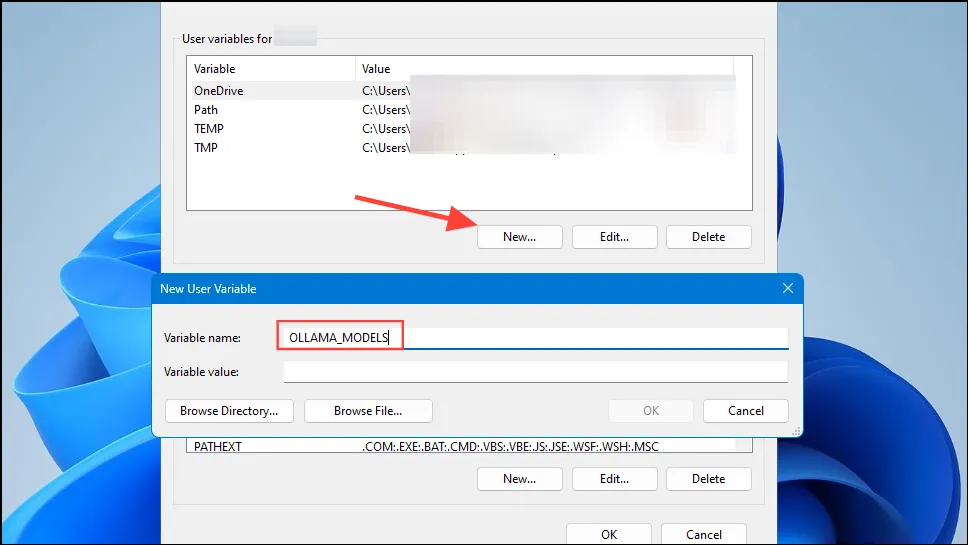

- Klicken Sie auf die Schaltfläche „Neu“ für Ihr Benutzerkonto und erstellen Sie eine Variable mit dem Namen

OLLAMA_MODELSim Feld „Variablenname“.

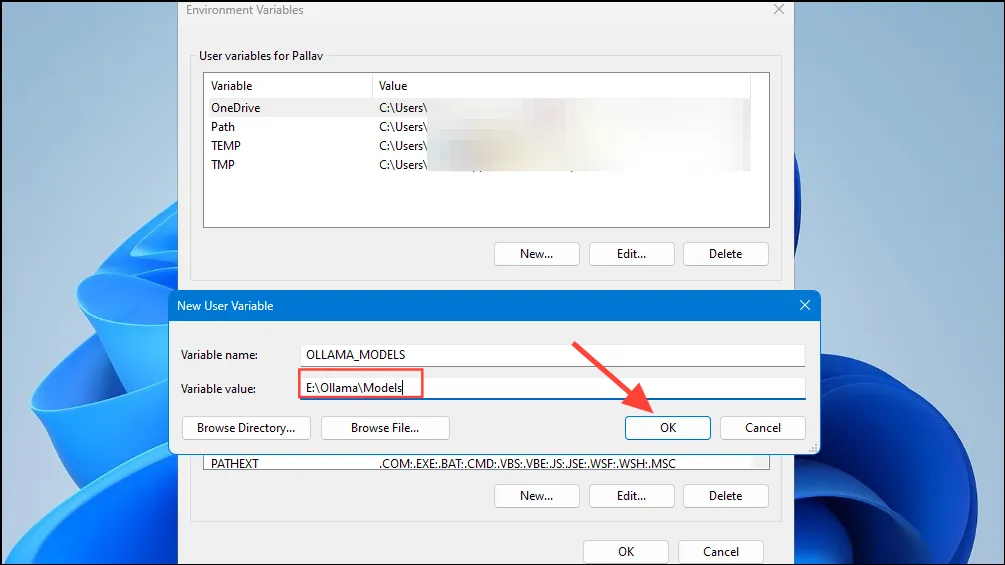

- Geben Sie dann im Feld „Variablenwert“ den Speicherort des Verzeichnisses ein, in dem Ollama seine Modelle speichern soll. Klicken Sie anschließend auf die Schaltfläche „OK“, bevor Sie Ollama über das Startmenü starten.

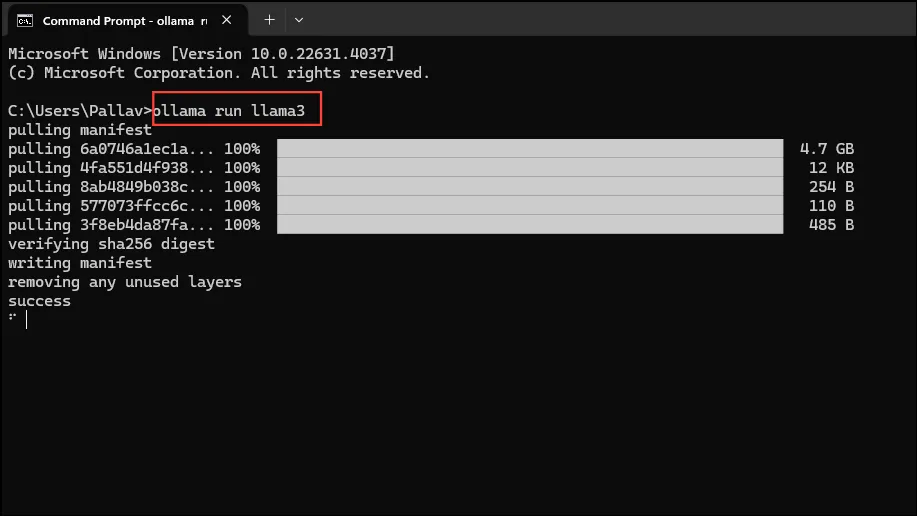

- Jetzt können Sie Ollama verwenden. Dies können Sie mit Metas Llama 3 8B tun, dem neuesten Open-Source-KI-Modell des Unternehmens. Um das Modell auszuführen, starten Sie über das Startmenü eine Eingabeaufforderung, Powershell oder ein Windows-Terminalfenster.

- Sobald das Eingabeaufforderungsfenster geöffnet ist, geben Sie Folgendes ein

ollama run llama3und drücken Sie die Eingabetaste. Das Modell ist fast 5 GB groß, daher wird der Download einige Zeit in Anspruch nehmen.

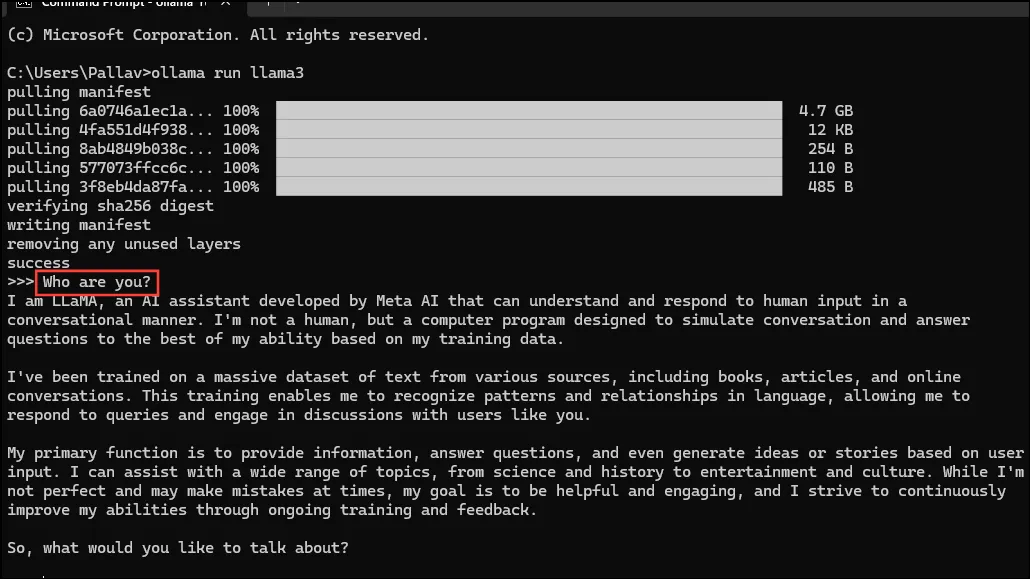

- Sobald der Download abgeschlossen ist, können Sie Llama 3 8B verwenden und direkt im Befehlszeilenfenster mit ihm kommunizieren. Sie können beispielsweise das Modell fragen

Who are you?und die Eingabetaste drücken, um eine Antwort zu erhalten.

- Jetzt können Sie das Gespräch fortsetzen und den KI-Modellen Fragen zu verschiedenen Themen stellen. Denken Sie jedoch daran, dass Llama 3 Fehler machen und halluzinieren kann. Seien Sie daher bei der Verwendung vorsichtig.

- Sie können auch andere Modelle ausprobieren, indem Sie die Seite mit der Ollama-Modellbibliothek besuchen. Darüber hinaus gibt es verschiedene Befehle, die Sie ausführen können, um die verschiedenen Funktionen von Ollama auszuprobieren.

- Sie können während der Ausführung eines Modells auch verschiedene Vorgänge durchführen, z. B. Sitzungsvariablen festlegen, Modellinformationen anzeigen, eine Sitzung speichern und mehr.

- Mit Ollama können Sie auch multimodale KI-Modelle zur Bilderkennung nutzen. Beispielsweise kann das LLava-Modell von DALLE-3 generierte Bilder erkennen. Es kann Bilder detailliert beschreiben.

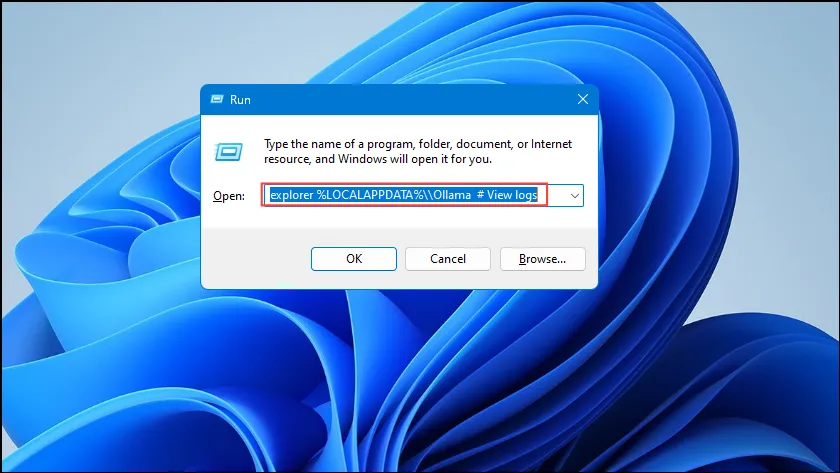

- Wenn beim Ausführen von Ollama Fehler auftreten, können Sie die Protokolle überprüfen, um das Problem zu ermitteln. Verwenden Sie die

Win + RVerknüpfung, um das Dialogfeld „Ausführen“ zu öffnen, und geben Sie den Text ein,explorer %LOCALAPPDATA%\\Ollama # View logsbevor Sie die Eingabetaste drücken.

- Sie können auch andere Befehle wie

explorer %LOCALAPPDATA%\\Programs\\Ollamaund verwendenexplorer %HOMEPATH%\\.ollama, um den Speicherort der Binärdateien, des Modells und der Konfiguration zu überprüfen.

Was du wissen solltest

- Ollama erkennt Ihre GPU automatisch, um KI-Modelle auszuführen, aber auf Maschinen mit mehreren GPUs kann es sein, dass es die falsche auswählt. Um dies zu vermeiden, öffnen Sie die Nvidia-Systemsteuerung und stellen Sie die Anzeige auf „Nur Nvidia-GPU“ ein.

- Der Anzeigemodus ist möglicherweise nicht auf jedem Computer verfügbar und fehlt auch, wenn Sie Ihren Computer an externe Displays anschließen.

- Unter Windows können Sie mit dem Task-Manager überprüfen, ob Ollama die richtige GPU verwendet. Der Manager zeigt die GPU-Auslastung an und teilt Ihnen mit, welche GPU verwendet wird.

- Während die Installation von Ollama unter macOS und Linux etwas anders abläuft als unter Windows, ist der Vorgang zum Ausführen von LLMs recht ähnlich.

Schreibe einen Kommentar