Was ist neu in ChatGPT mit der GPT-4o-Version?

OpenAI hat vor Kurzem sein Modell GPT-4o angekündigt, ein neues Flaggschiffmodell der Engine, die ChatGPT antreibt, seinen berühmten KI-gestützten Chatbot, der erstmals 2022 veröffentlicht wurde. Dieses neuere Modell bringt die Mensch-Computer-Interaktion auf ein ganz neues Niveau, indem es sie schneller und viel natürlicher erscheinen lässt.

Bei GPT-4o steht das „o“ für „omni“, da es Text, Bild und Audio in einem einzigen Modell kombiniert. Zwar gibt es im Vergleich zum GPT-4 Turbo-Modell keine Verbesserungen in Bezug auf Intelligenz und Denkvermögen, aber es gibt viele neue Updates. Es ist darauf ausgelegt, schnellere, menschlicher klingende Antworten zu liefern und kann sogar Emotionen simulieren. Es ist auch wesentlich schneller beim Verstehen von visuellen und Audioeingaben. In diesem Deep Dive werfen wir einen Blick auf die Funktionen, die GPT-4o bietet, und wie es die Art und Weise revolutionieren wird, wie wir mit KI-Assistenten interagieren. Also, machen Sie mit und legen Sie los!

GPT-4o ist deutlich schneller

Das GPT-4o-Modell ermöglicht es ChatGPT, Eingaben in verschiedenen Formen zu akzeptieren, darunter Audio, Text, Bilder oder deren Kombinationen. Es kann auch Antworten in verschiedenen Formaten bereitstellen. Am beeindruckendsten ist jedoch die Geschwindigkeit, mit der Sie Antworten erhalten.

Mit dem neuen Modell benötigt ChatGPT nur etwa 320 Millisekunden oder sogar weniger, um auf Audioeingaben zu reagieren, was ungefähr der Zeit entspricht, die eine Person zum Antworten in einem Gespräch benötigt. Abgesehen davon ist die Leistung von GPT-4o ähnlich wie bei GPT-4 Turbo, was die Verwendung von Englisch oder das Schreiben von Code betrifft.

Es reagiert auch viel besser auf textbasierte Eingaben in anderen Sprachen als Englisch und ist in der API erheblich günstiger, da es viel effizienter ist als sein Vorgänger.

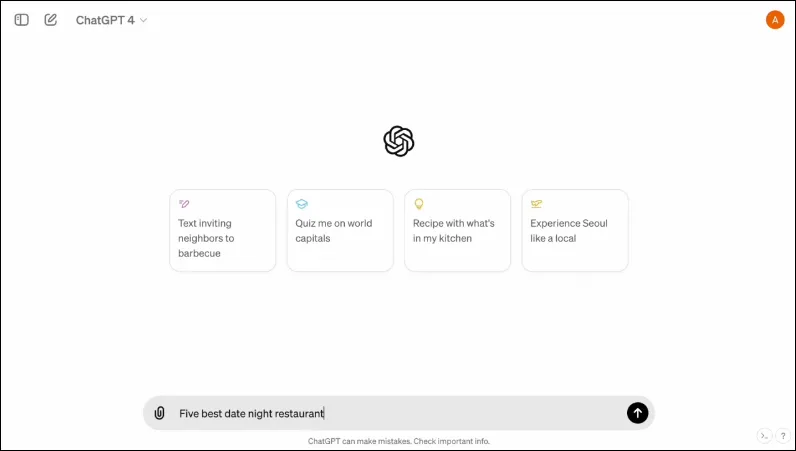

Es verfügt außerdem über eine neue Benutzeroberfläche, die die Interaktion einfacher und übersichtlicher gestalten soll.

Es ist multimodal

Der vorhandene Sprachmodus von ChatGPT besteht aus drei Modellen. Das erste nimmt textbasierte Eingaben entgegen und liefert Ausgaben im gleichen Format, während das zweite Audioeingaben in Text umwandelt, der von ChatGPT entgegengenommen wird, um textbasierte Ausgaben bereitzustellen. Das letzte Modell wandelt Text in Audio um.

Dieses Design führt jedoch zu einem Informationsverlust, da das Modell nicht direkt mit dem Audio-Input interagieren oder einen Output präsentieren kann, der emotionale Elemente enthält. Mit GPT-4o hat OpenAI ein einziges multimodales Modell erstellt, das verschiedene Arten von Inputs verstehen und den erforderlichen Output direkt verarbeiten kann.

Es unterstützt derzeit 50 Sprachen und wird auch als API verfügbar sein.

Es kann menschliche Emotionen simulieren

Als ChatGPT erstmals angekündigt wurde, bestand für viele Menschen einer der größten Nachteile des KI-Chatbots darin, dass er keine emotionalen Antworten liefern konnte. Mit GPT-4o kann ChatGPT menschliche Emotionen simulieren und geeignete Antworten liefern, die diese Emotionen integrieren.

In den von OpenAI geteilten Demos sieht man den Chatbot lachen, singen und sogar Sarkasmus zeigen, wenn man ihn darum bittet. Das ist um Längen besser als das, was jeder andere KI-Chatbot derzeit kann, und wird die Benutzerinteraktionen viel angenehmer machen. Laut OpenAI wird das neue Modell es ChatGPT ermöglichen, auch die Stimmung des Benutzers zu erkennen und auf der Grundlage dieser Informationen angemessene Antworten zu geben.

In Kombination mit der Möglichkeit, visuelle Eingaben zu nutzen, ist die Fähigkeit, emotionale Reaktionen hervorzurufen, eines der beeindruckendsten Features, die das neue Modell bietet.

Das neue Modell kann eine größere Menge an Informationen speichern

Dank GPT-4o kann ChatGPT jetzt Bilder wie Diagramme und Fotos besser verstehen und mehr Informationen über den Benutzer speichern. Dies führt auch dazu, dass Antworten größere Textteile enthalten können, was in mehreren Anwendungsfällen praktisch sein kann.

Sie können den Chatbot beispielsweise bitten, größere Textteile zu übersetzen, und er kann Ihnen mit einer Live-Übersetzung helfen. Da er neben textbasierten auch visuelle und Audioeingaben verwenden kann, können Sie damit Informationen aus Screenshots, Fotos und anderen Bildern sammeln.

Da GPT-4o eine größere Menge an Informationen speichern kann, ohne dass Benutzer sie wiederholen müssen, können Benutzer an Hin- und Her-Gesprächen mit dem KI-Chatbot teilnehmen. Mit mehr Informationen können Benutzer erwarten, dass die Gespräche anspruchsvoller sind.

Sicherheitsvorkehrungen im neuen Modell

Wie die bestehenden GPT-Modelle wurde GPT-4o mit bestimmten Sicherheitsvorkehrungen entwickelt, um die Sicherheit zu gewährleisten. Die Trainingsdaten wurden gefiltert und das Verhalten des Modells wurde nach dem Training verfeinert. OpenAI hat das KI-Modell auch anhand mehrerer Parameter wie Cybersicherheit und Überzeugungskraft bewertet, um unerwünschte Vorfälle zu vermeiden.

Darüber hinaus haben die Entwickler die Hilfe von über 70 Experten aus verschiedenen Bereichen wie Desinformation und Sozialpsychologie in Anspruch genommen, um Risiken zu identifizieren und zu mindern, die mit dem neuen Modell auftreten oder zunehmen könnten. Sie werden auch weiterhin die Nutzung des Chatbots auf zukünftige Risiken überwachen und bei Bedarf die erforderlichen Maßnahmen ergreifen.

Zunächst wird OpenAI nur eine begrenzte Auswahl an Voreinstellungen für Sprachmodelle zur Verfügung stellen. Es wird auch das Feedback der Benutzer berücksichtigen, um das Modell zu verbessern und vollständige Sicherheit zu gewährleisten.

GPT-4o-Verfügbarkeit

Bisher waren zwei Versionen von ChatGPT verfügbar – eine kostenlose Version, die auf GPT 3.5 lief, und eine kostenpflichtige Version, die auf GPT 4.0 lief und 20 US-Dollar pro Monat kostete. Letztere kann auf ein größeres Sprachmodell zugreifen und so größere Datenmengen verarbeiten.

GPT-4o wird sowohl für kostenlose als auch für kostenpflichtige Benutzer verfügbar sein und soll in den kommenden Wochen auf Geräten eingeführt werden. Auf Mobilgeräten wird es über die vorhandene App verfügbar sein, die aktualisiert wird, und neben der Webversion für Desktop-Benutzer wird auch eine neue macOS-Desktop-App verfügbar sein (die Windows-Version wird später in diesem Jahr erscheinen).

Um zwischen kostenlosen und kostenpflichtigen Benutzern zu unterscheiden, bietet OpenAI kostenpflichtigen Benutzern fünfmal mehr Kapazität als kostenlosen Benutzern. Sobald Sie Ihr Limit erreicht haben, werden Sie wieder auf ChatGPT 3.5 umgestellt.

Die Ankündigung von OpenAI zu GPT-40 erfolgt nur einen Tag vor der jährlichen I/O Developer Conference von Google, auf der Google voraussichtlich seine eigenen KI-bezogenen Ankündigungen machen wird. OpenAI hat außerdem versprochen, dass weitere Ankündigungen folgen werden. Es besteht also kein Zweifel daran, dass der Wettbewerb zwischen den beiden Rivalen gerade erst anfängt, sich zu verschärfen.

Obwohl wir nicht wissen, wann OpenAI weitere Änderungen an seinem KI-Modell vorstellen wird, wissen wir, dass GPT-4o weltweit auf Geräten verfügbar sein wird, auf denen ChatGPT ausgeführt wird. Drücken Sie also die Daumen und warten Sie, bis das Update auf Ihrem Gerät angezeigt wird. Bis zum nächsten Mal!