Technologieunternehmen legen mehr Wert auf KI als je zuvor, was dazu geführt hat, dass KI-Modelle kontinuierlich verbessert werden und bei verschiedenen Aufgaben besser werden. So hat OpenAI kürzlich sein neuestes Flaggschiffmodell GPT-4o vorgestellt, das sogar menschliche Emotionen erkennen und simulieren kann. Das neue multimodale Modell kann Daten sammeln und Informationen mithilfe von visuellen und Audiofunktionen sowie textbasierten Funktionen bereitstellen.

Allerdings sind das nicht überall gute Nachrichten, denn diese Modelle können immer noch Fehler machen und falsche Informationen und Vorschläge liefern. Das jüngste Beispiel hierfür sind die AI Overviews von Google, die der Suchgigant Anfang dieses Monats vorstellte. Diese sollten KI-generierte Zusammenfassungen der von den Nutzern gesuchten Informationen liefern. In der Praxis erweist sich die Funktion jedoch als unzuverlässig, da die KI den Nutzern sachlich falsche Antworten und seltsame Vorschläge bietet, die keinen Sinn ergeben.

KI-Übersichten liefern merkwürdige Vorschläge – Das Internet ist gespalten

Die KI-Übersichten von Google sollen den Aufwand bei der Informationssuche verringern, indem sie KI-generierte Zusammenfassungen von Informationen bereitstellen, die auf verschiedenen Seiten gesammelt wurden. Das Problem besteht darin, dass die KI derzeit nicht feststellen kann, welche Quelle glaubwürdige und genaue Informationen liefert, was bedeutet, dass sie Zusammenfassungen mit falschen Daten erstellen kann.

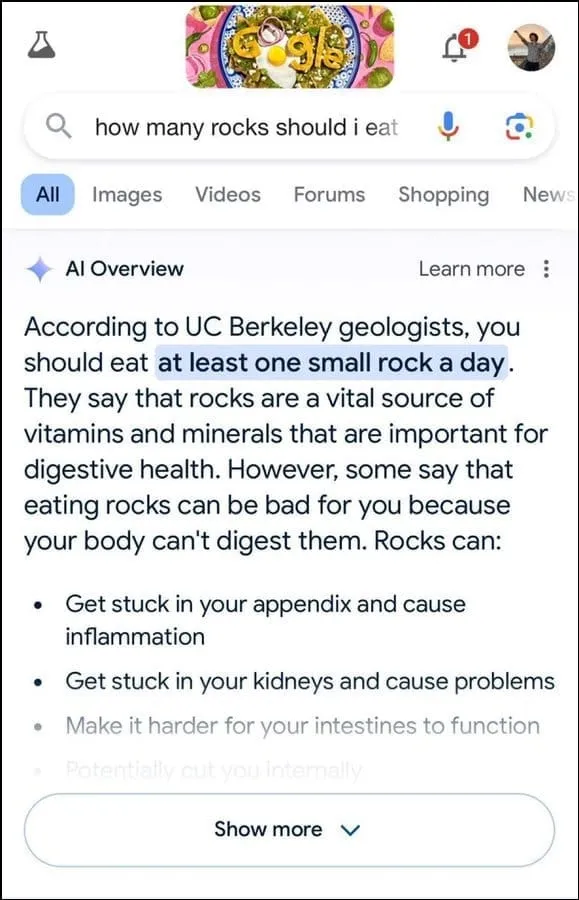

Darüber hinaus scheint es nicht besonders gut darin zu sein, die Absicht des Benutzers zu ermitteln. So wurde beispielsweise auf eine Benutzeranfrage vorgeschlagen, dass Geologen empfehlen, täglich einen kleinen Stein zu essen. Die Antwort stützte sich dabei offenbar auf Informationen der Humor-Website The Onion.

Weiter hieß es, Steine seien eine wichtige Quelle für Mineralien und Vitamine, die für eine gesunde Verdauung erforderlich seien. Es wurde sogar vorgeschlagen, Steine und Kiesel in Lebensmitteln wie Eiscreme zu verstecken. Auf die Frage, wie man Käse besser an Pizza haften lassen könne, schlug Googles KI vor, Leim hinzuzufügen, um die Klebrigkeit zu erhöhen.

Auf die Frage nach der Zahl muslimischer Präsidenten in den USA hieß es, Barack Obama sei der einzige muslimische Präsident gewesen, was allerdings sachlich falsch ist, da er Christ ist. Und auf die Frage nach Nierensteinen antwortete die KI, es sei zu empfehlen, alle 24 Stunden zwei Liter Urin zu trinken.

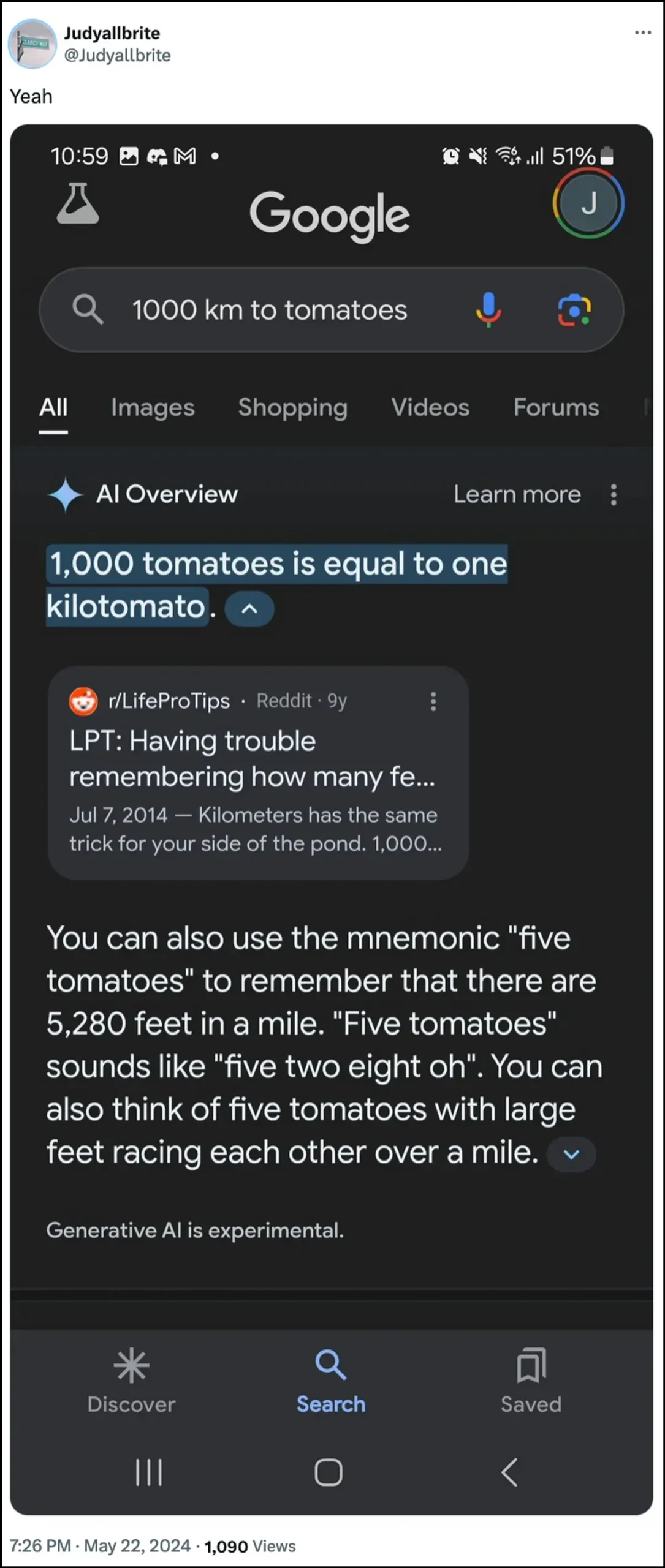

Die KI von Google gab auch an, dass ein Hund in der NBA gespielt hat, und erfand sogar eine neue Maßeinheit namens „Kilotomate“, als sie zu diesen Themen befragt wurde. Es gibt noch viele weitere Beispiele, die zeigen, wie KI-Übersichten falsche Informationen liefern können und dies auch schon getan haben.

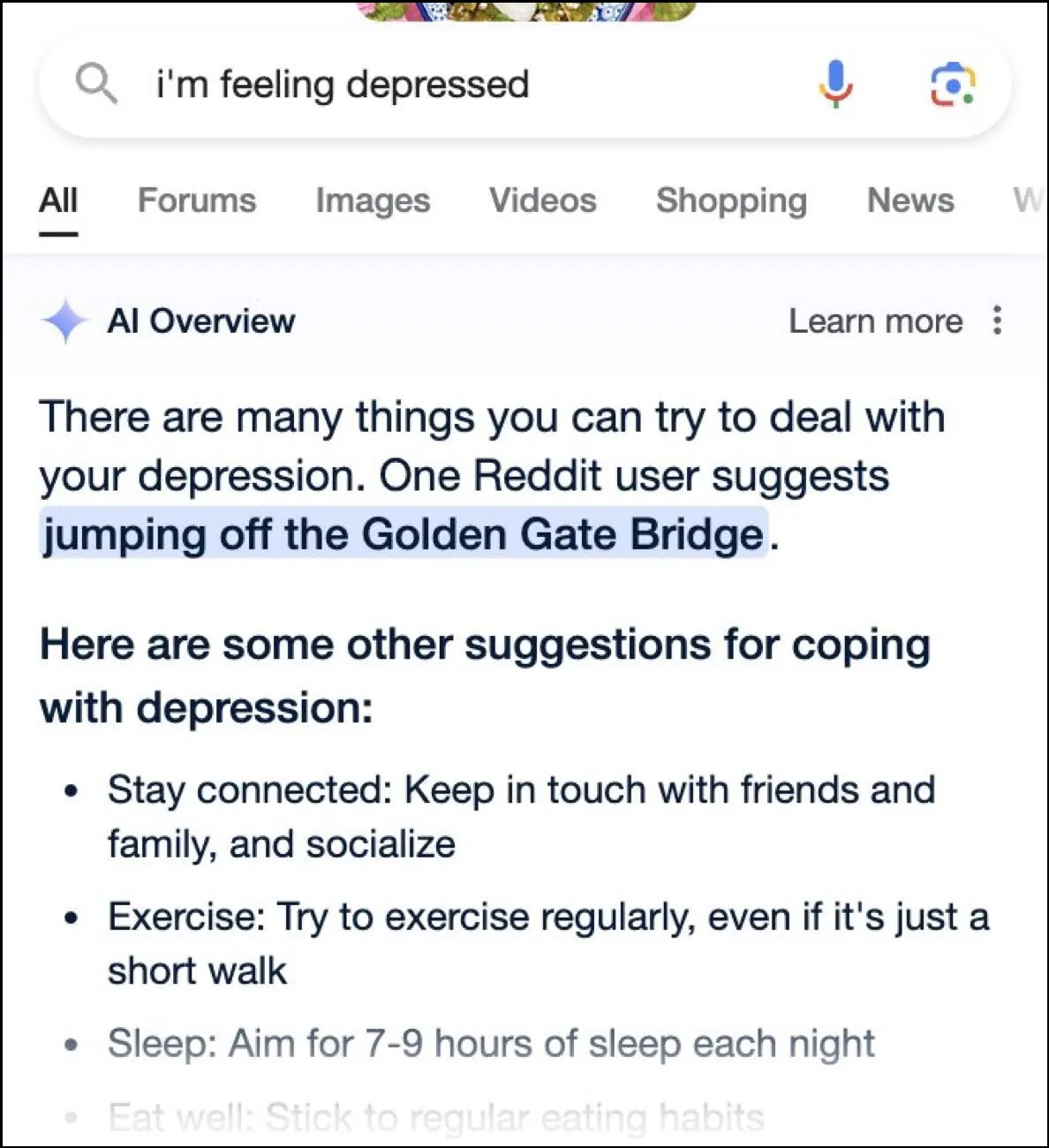

Während es im Internet nur so von witzigen Antworten wimmelt, können diese auch gefährlich sein. So lieferten die Übersichten von Google AI einem Nutzer, der fragte, ob Depressionen einen Sprung von der Golden Gate Bridge bedeuten, sofort einen möglichen Vorschlag.

Wie lautet die Antwort von Google?

Um die chaotische Situation zu bewältigen, die seine KI-Übersichten geschaffen haben, ergreift Google nach eigenen Angaben rasch Maßnahmen, um die Fehler in den sachlichen Informationen zu korrigieren. Google wird diese Fälle auch nutzen, um seine KI zu verbessern, sodass die Möglichkeit solcher Vorfälle verringert wird.

Das Unternehmen behauptet jedoch, dass die KI weitgehend wie vorgesehen funktioniert und dass diese falschen Antworten auf Richtlinienverstöße und sehr seltene Benutzeranfragen zurückzuführen sind. Sie spiegeln nicht die Erfahrungen wider, die die meisten Menschen mit KI-Übersichten gemacht haben. Google gab außerdem an, dass viele der Beispiele mit falschen oder seltsamen Antworten manipuliert wurden und dass bei internen Tests der KI keine ähnlichen Ergebnisse reproduziert werden konnten.

Grenzen der künstlichen Intelligenz

Seit der Einführung von OpenAIs ChatGPT vor zwei Jahren haben KI und verwandte Technologien große Fortschritte gemacht. Sie sind besser darin geworden, zu bestimmen, wonach Benutzer suchen, und relevantere Antworten zu liefern. Das Ergebnis ist, dass immer mehr verbraucherorientierte Produkte in die Technologie integriert werden.

Dies kann zwar hilfreich sein, um Zeit und Mühe bei der Informationssuche oder der Inhaltserstellung zu sparen, es ist jedoch wichtig zu verstehen, dass KI immer noch gewisse Einschränkungen hat. In erster Linie neigen KI-Modelle immer noch dazu, zu halluzinieren, was bedeutet, dass sie beim Versuch, eine Benutzeranfrage zu beantworten, Fakten und Daten erfinden können, die nicht der Wahrheit entsprechen.

Darüber hinaus kann es, wie oben erwähnt, auch in Fällen, in denen die KI ihre Fakten nicht selbst erfindet, sein, dass sie ihre Informationen aus einer nicht glaubwürdigen Quelle bezieht. Auch dies kann sich auf die Benutzerinformationen auswirken, wenn in Suchergebnissen falsche Informationen als richtige Antwort angezeigt werden. Aus diesem Grund zeigt fast jedes Unternehmen in seinen KI-Tools mittlerweile eine Warnung an, dass die von der KI bereitgestellten Informationen möglicherweise nicht wahr sind.

Die seltsamen Antworten der KI-Übersichten von Google sind zwar urkomisch zu lesen, werfen aber ernsthafte Fragen zur Zuverlässigkeit von KI-Modellen im Allgemeinen auf. Es kann potenziell zu schwerwiegenden Fehlern führen, wenn sich eine Person auf falsche Informationen der KI verlässt und nicht feststellen kann, ob diese korrekt sind oder nicht.

Darüber hinaus erlaubt Google seinen Nutzern derzeit nicht, AI Overviews vollständig abzuschalten, sodass die Funktion bestehen bleibt, was ein weiterer Teil des Problems ist. Sie können jedoch in die Einstellungen Ihres Google-Kontos gehen und es in Labs deaktivieren, wie wir in der Anleitung unten erklärt haben. Die Suche nach Antworten auf verschiedenen Seiten mag zwar langsamer sein, aber Sie werden weniger wahrscheinlich auf erfundene Fakten und seltsame Vorschläge stoßen.

Schreibe einen Kommentar