Während viele Browser KI-Funktionen in ihre Browser integrieren, ist Opera gerade der erste Browser, der lokale KI-Modelle integriert. Opera fügt seinem Opera One-Browser experimentelle Unterstützung für über 150 Local Large Language Model (LLM)-Varianten aus rund 50 verschiedenen Modellfamilien hinzu.

Da die Sprachmodelle lokal sind, müssen sich Benutzer keine Sorgen machen, dass ihre Daten an den Server des LLM gesendet werden. Es ist eine private und sichere Art, KI zu nutzen.

Um die lokalen LLM-Modelle zu verwenden, benötigen Sie je nach verwendeter Variante 2 bis 10 GB Speicherplatz auf Ihrem Computer. Zu den unterstützten LLMs gehören unter anderem Llama von Meta, Phi-2 von Microsoft, Gemma von Google, Vicuna, Mixtral von Mistral AI usw. Sie können diese Sprachmodelle anstelle von Aria AI von Opera verwenden und jederzeit wieder zu Aria AI wechseln.

Die Funktion ist derzeit nur im Entwickler-Stream von Opera One verfügbar. So können Sie die lokalen KI-Modelle in Opera One Developer aktivieren und verwenden.

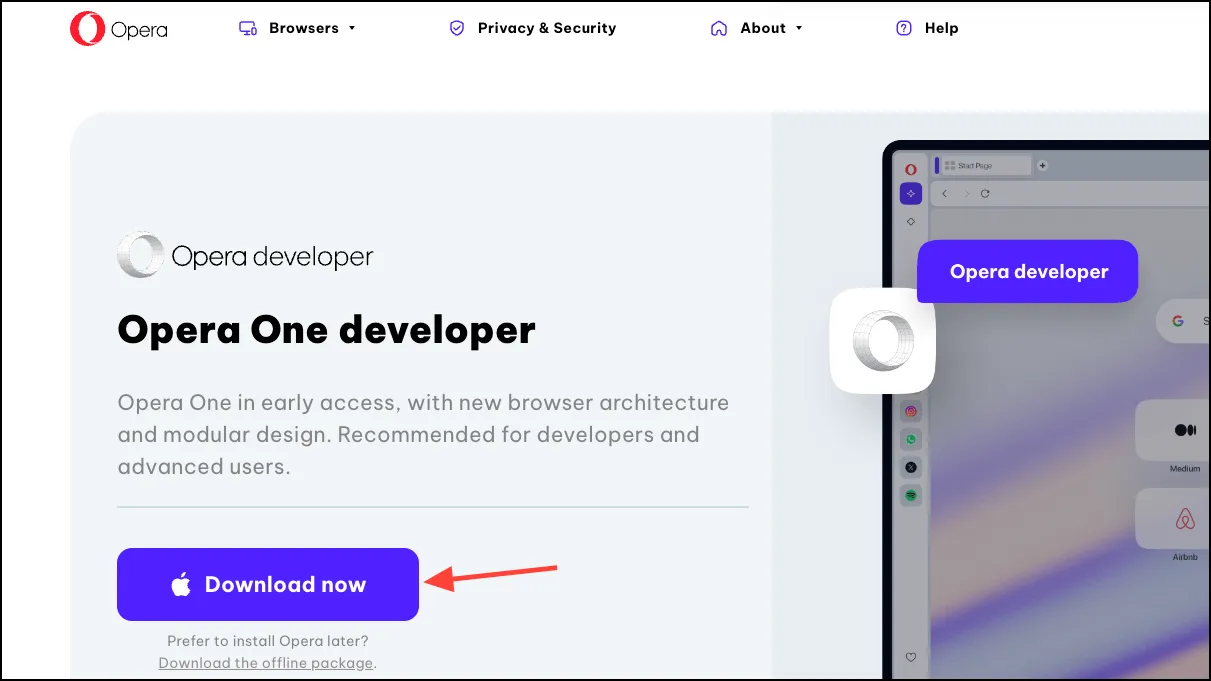

Laden Sie Opera One Developer herunter

Wenn Sie bereits über Opera One Developer verfügen, überspringen Sie einfach diesen Abschnitt und fahren Sie direkt mit der Verwendung der lokalen LLM-Modelle fort.

- Klicken Sie auf diesen Link, um Opera One Developer herunterzuladen. Scrollen Sie nach unten und klicken Sie auf der Kachel „Opera One Developer“ auf „Jetzt herunterladen“.

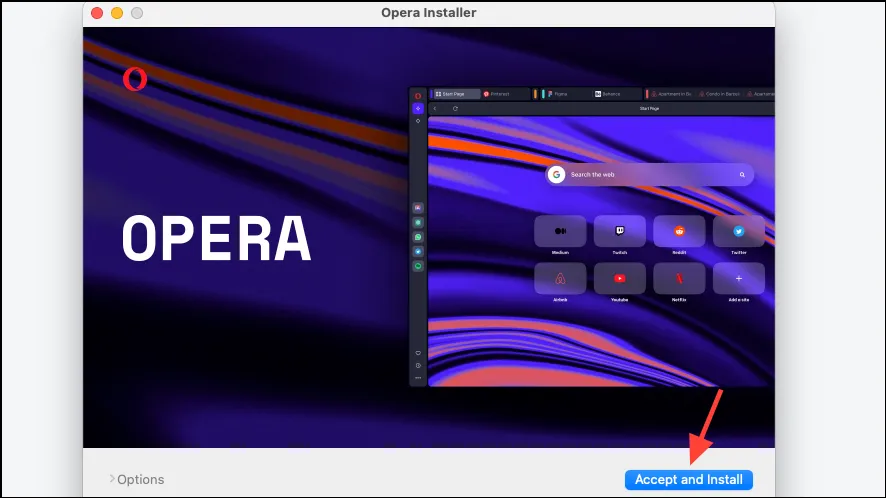

- Öffnen Sie die Datei, sobald sie heruntergeladen ist, und führen Sie das Installationsprogramm aus.

- Klicken Sie auf „Akzeptieren und installieren“ und folgen Sie dann den Anweisungen auf Ihrem Bildschirm, um den Browser zu installieren.

Lokales KI-Modell einrichten

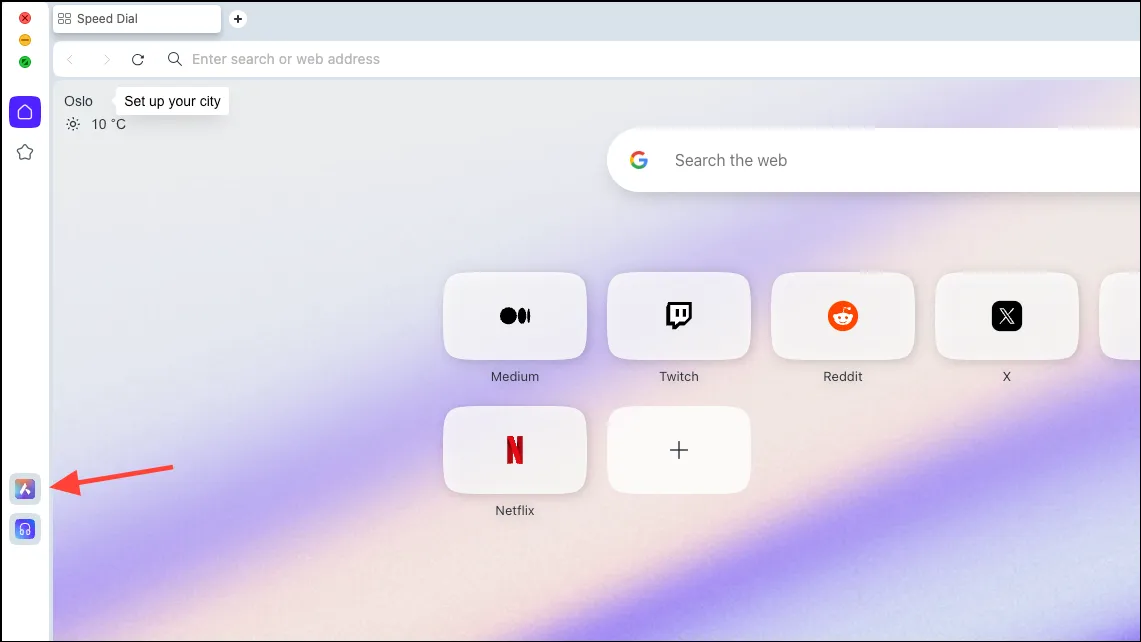

- Sobald der Browser heruntergeladen ist, klicken Sie in der linken Seitenleiste auf das Symbol „Aria AI“.

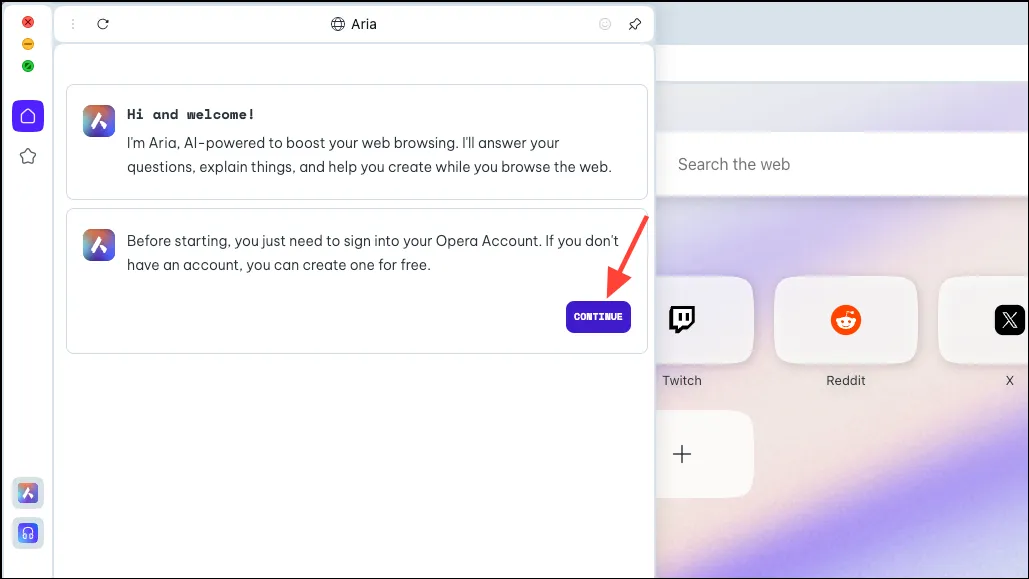

- Klicken Sie auf „Weiter“, um fortzufahren.

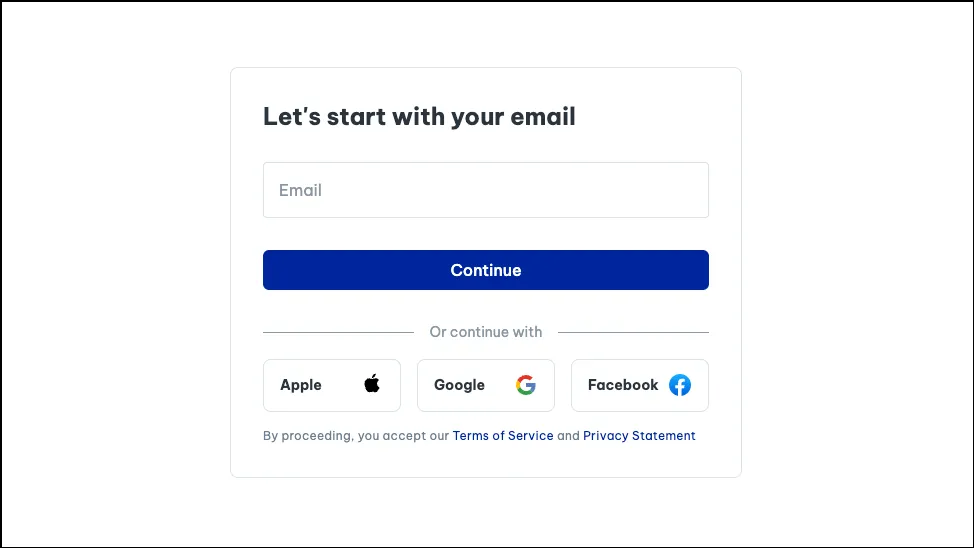

- Wenn Sie Aria zum ersten Mal verwenden, müssen Sie sich für ein kostenloses Opera-Konto anmelden, um es nutzen zu können. Sie können Ihre E-Mail-Adresse oder Ihr Apple-, Facebook- oder Google-Konto verwenden, um ein Opera-Konto zu erstellen.

- Sobald Ihr Konto erstellt ist, können Sie mit Aria chatten.

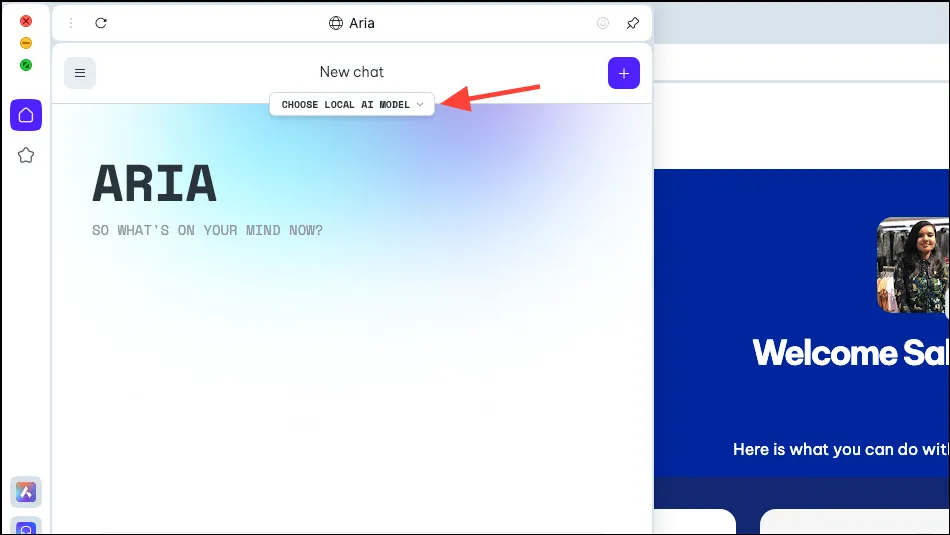

- Jetzt sehen Sie im Aria-Bedienfeld die Option „Lokales KI-Modell auswählen“. Klicken Sie darauf.

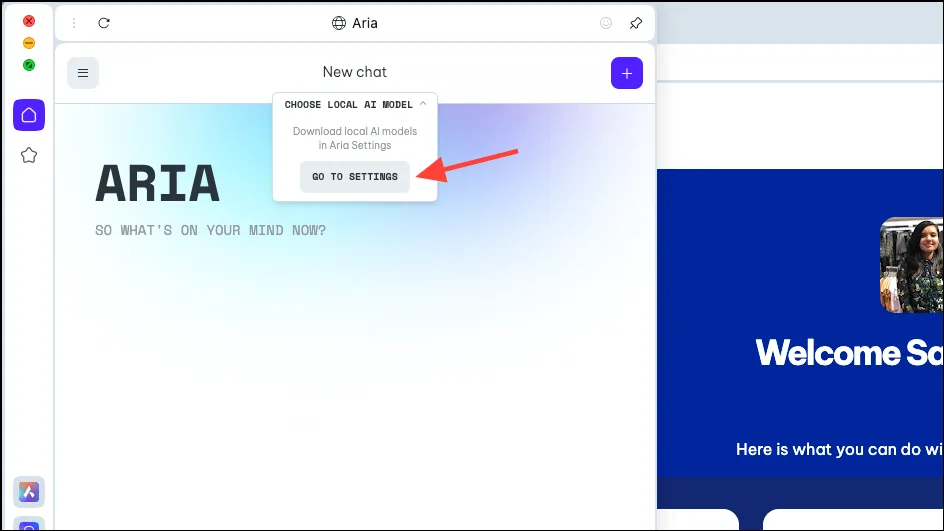

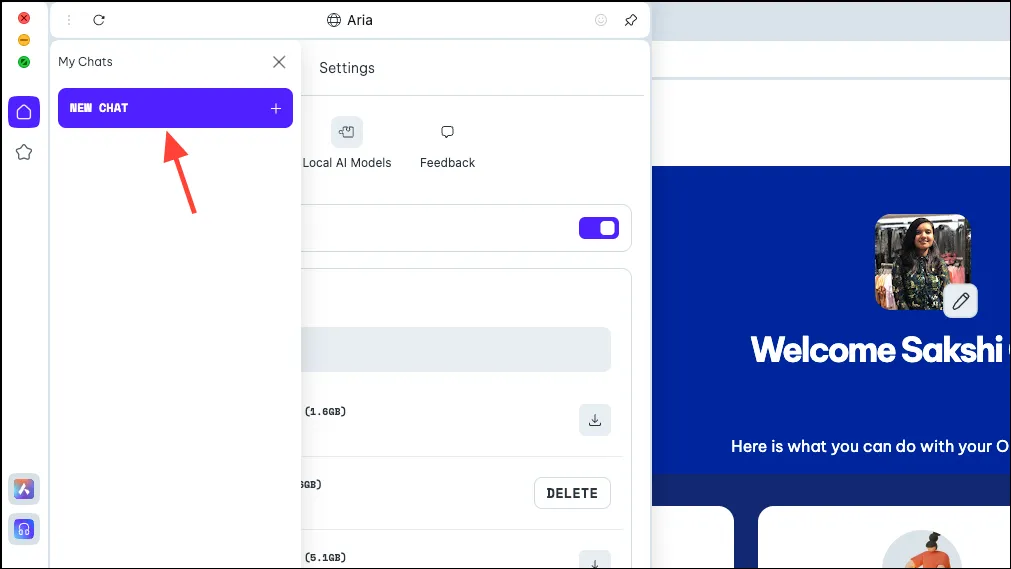

- Wählen Sie „Zu den Einstellungen gehen“ aus dem Dropdown-Menü.

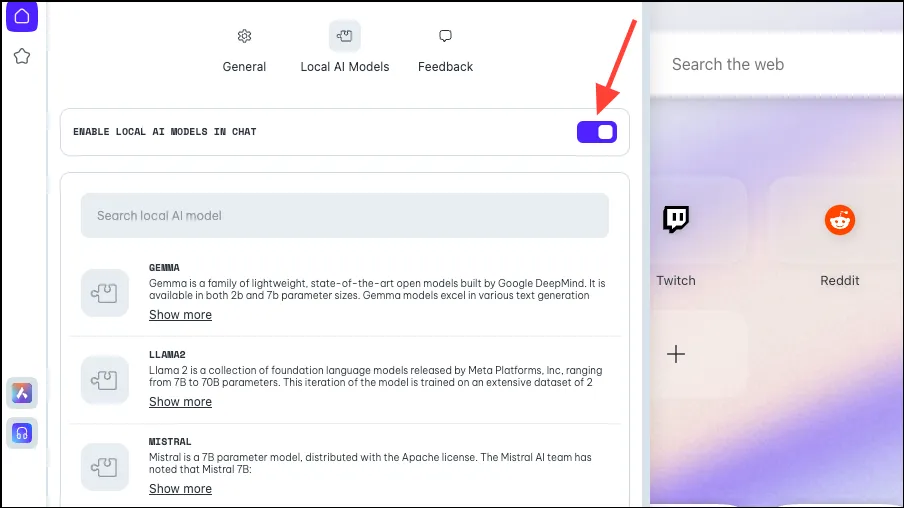

- Stellen Sie sicher, dass der Schalter „Lokale KI in Chats aktivieren“ aktiviert ist.

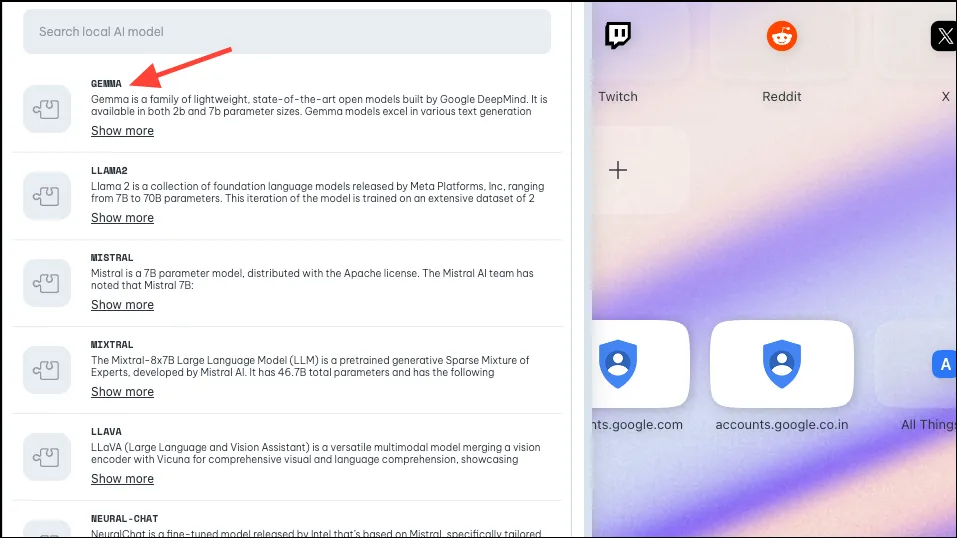

- Wählen Sie als Nächstes das Modell aus, das Sie für die lokale Verwendung herunterladen möchten, indem Sie darauf klicken oder danach suchen. Wie oben erwähnt, unterstützt Opera ungefähr 50 Modellfamilien mit unterschiedlichen Varianten, sodass die Gesamtzahl 150 beträgt.

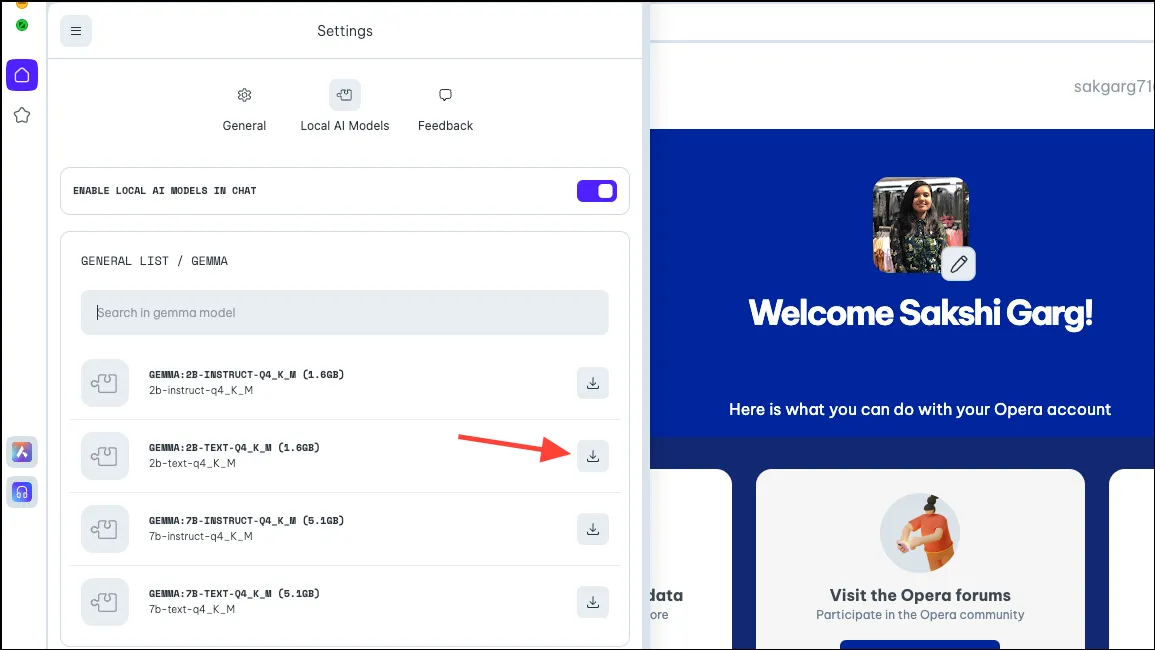

- Wenn Sie auf einige Modelle klicken, z. B. Gemma von Google, werden Ihnen 4 verschiedene Varianten angezeigt. Laden Sie das Modell herunter, das Sie verwenden möchten. Für diese Anleitung laden wir Gemmas 2B-Textmodell herunter. Klicken Sie rechts auf die Schaltfläche „Herunterladen“. Sie können den vom Modell auf Ihrem PC benötigten Speicherplatz sehen, bevor Sie es herunterladen.

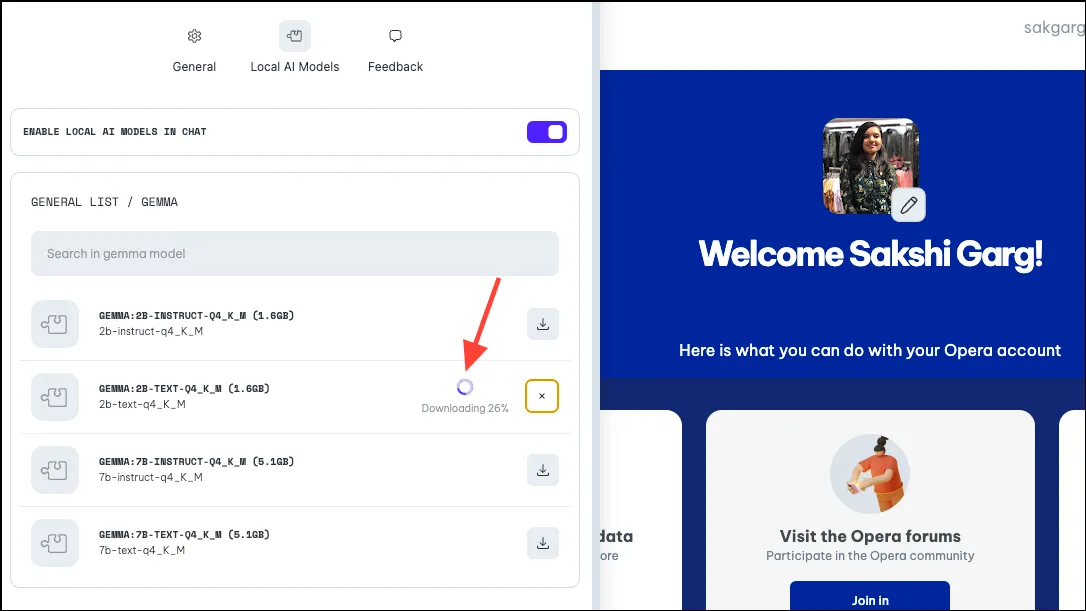

- Der Download kann je nach Modellgröße und Internetverbindung einige Zeit in Anspruch nehmen. Daneben können Sie den Fortschritt des Downloads sehen.

Verwenden des lokalen KI-Modells

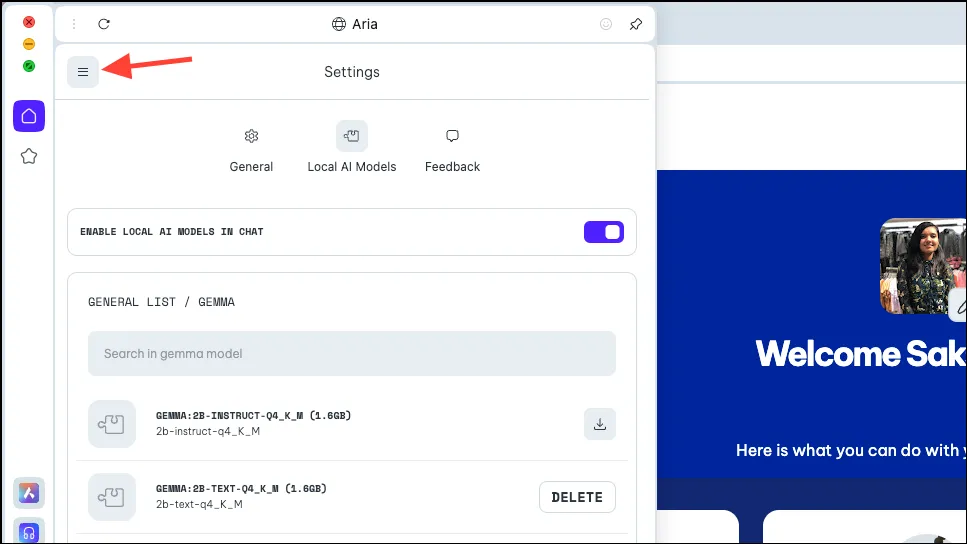

- Sobald das Modell heruntergeladen ist, klicken Sie oben links im Bedienfeld auf das Menüsymbol.

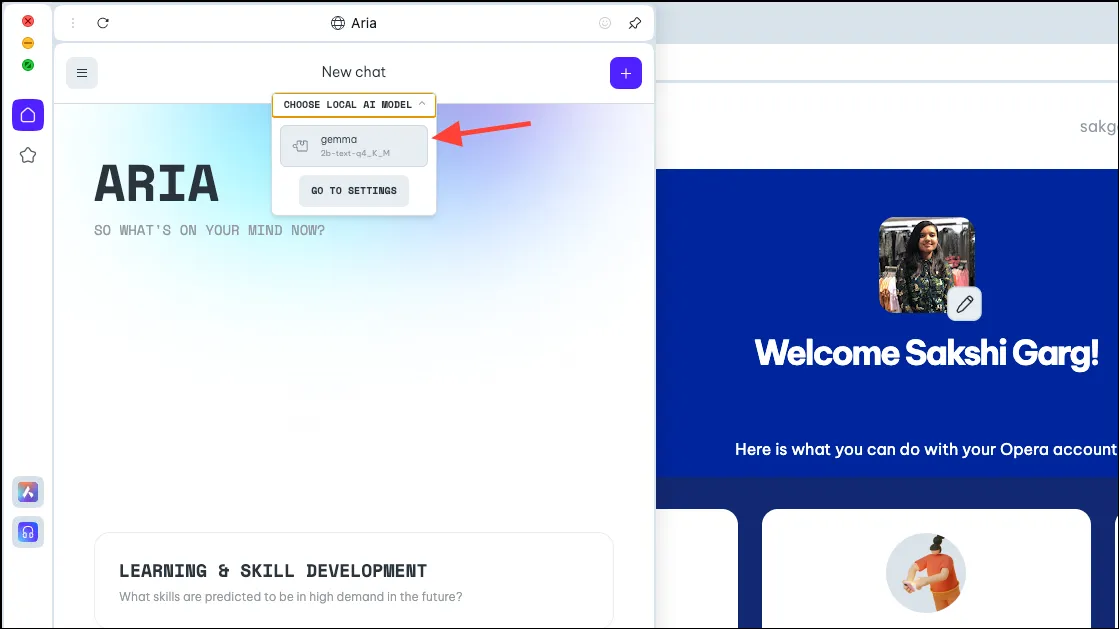

- Wählen Sie „Neuer Chat“ aus dem angezeigten Menü.

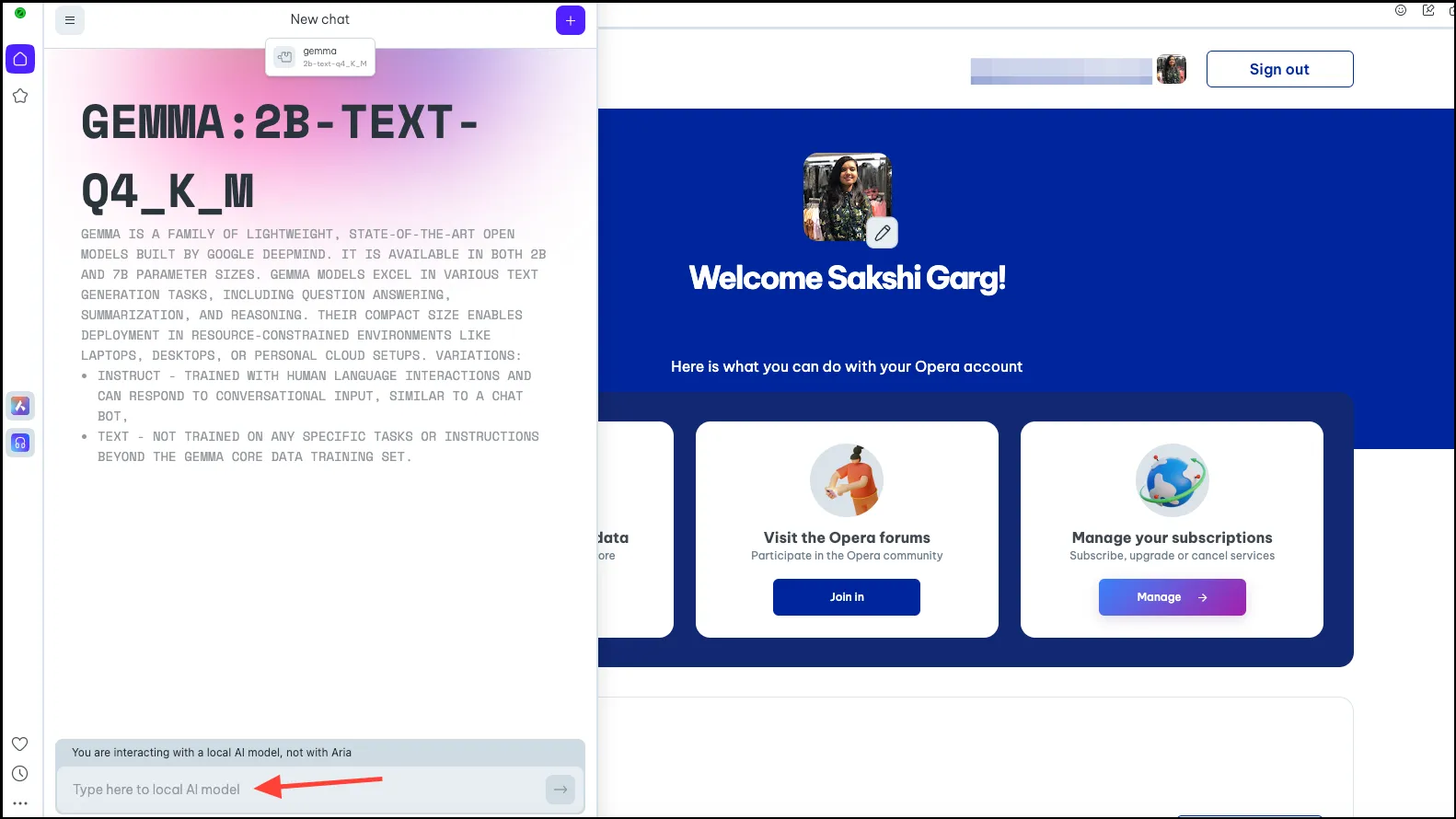

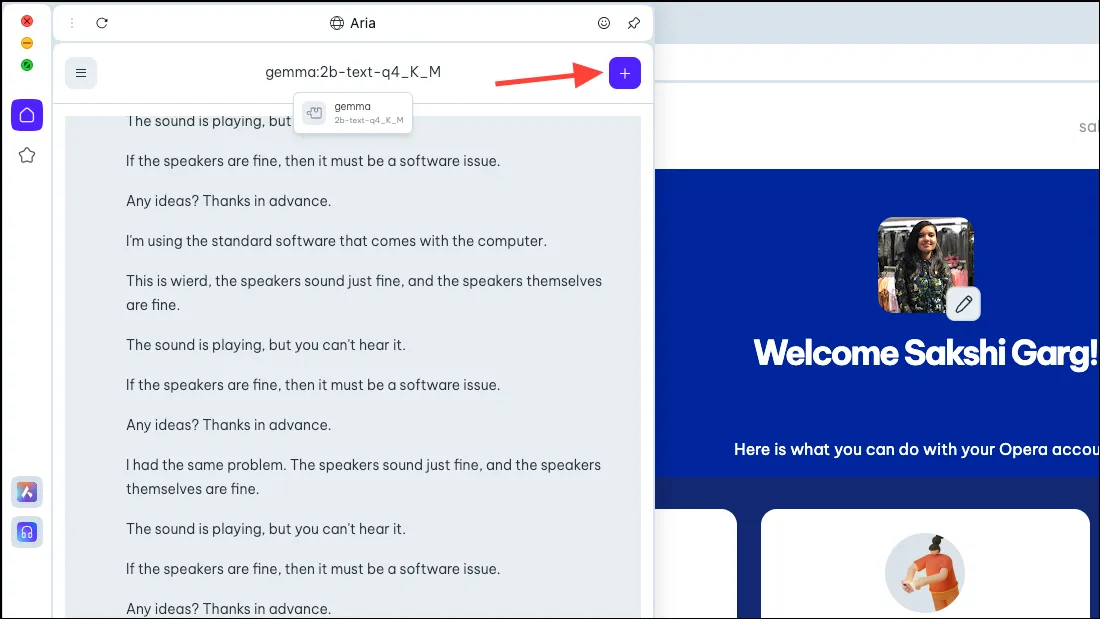

- Klicken Sie erneut oben auf die Option „Lokales KI-Modell auswählen“ und wählen Sie aus dem Dropdown-Menü das gerade heruntergeladene Modell aus (in unserem Fall Gemma).

- Sie werden nun zum lokalen KI-Modell Ihrer Wahl weitergeleitet. Geben Sie Ihre Eingabeaufforderung in die Eingabeaufforderungsleiste ein und senden Sie sie an die KI, um mit Ihren lokalen Interaktionen zu beginnen.

- Ihre Chats mit dem lokalen KI-Modell sind im Chatverlauf verfügbar, genau wie Ihre Chats mit Aria. Sie können die Chats zur besseren Organisation auch umbenennen.

- Ebenso können Sie mehrere lokale KI-Modelle herunterladen und verwenden. Bedenken Sie jedoch, dass jedes Modell zwischen 2 und 10 GB Speicherplatz auf Ihrem Computer benötigt.

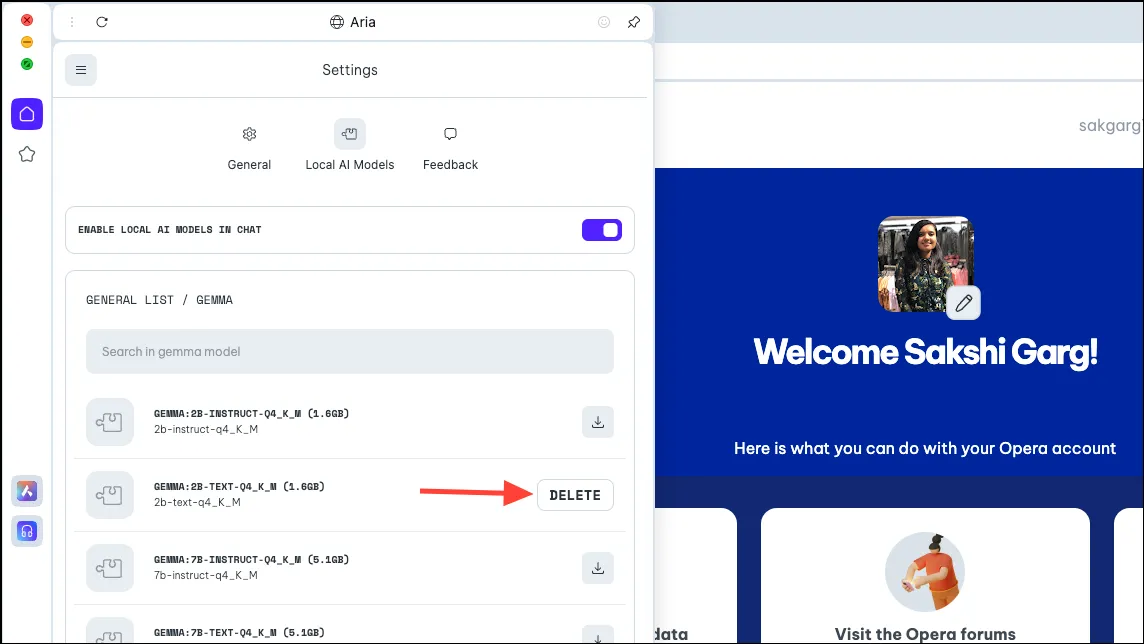

- Um das Modell von Ihrem PC zu löschen, navigieren Sie zu denselben Einstellungen, von denen wir das Modell zuvor heruntergeladen haben, also

Aria>Settings>Local AI Models>[Downloaded Model]. Klicken Sie dann auf die Schaltfläche „Löschen“.

Zurück zu Aria wechseln

- Um zurück zu Aria zu wechseln, starten Sie einfach einen neuen Chat mit der KI. Klicken Sie oben rechts auf das „+“-Symbol.

- Der neue Chat wird mit Aria selbst gestartet.

Es ist sehr spannend, lokale KI-Modelle im Opera One-Browser verwenden zu können, und das nicht nur aus Sicherheits- und Datenschutzgründen. Obwohl es in der Anfangsphase noch sehr einfach ist, sind die möglichen zukünftigen Fälle ziemlich spannend. Ein Browser mit lokaler KI könnte Ihre historischen Eingaben mit all Ihren Daten verwenden; wie spannend wäre das! Und das Team bei Opera untersucht diese Möglichkeit.

Aber auch ohne zukünftige Möglichkeiten sind lokale KIs eine großartige Lösung für Benutzer, die sich Sorgen darüber machen, dass ihre Daten und Chats mit der KI auf deren Servern gespeichert werden. Es gibt einige großartige LLMs, die Sie erkunden könnten, wie Llama für die Codierung, Phi-2 für herausragende Denkfähigkeiten und Mixtral für Aufgaben wie Textgenerierung, Beantwortung von Fragen usw.

Schreibe einen Kommentar