Ein weiteres KI-Modell hat sich dem Meer der KI-Modelle angeschlossen und dieses stammt wieder einmal von OpenAI. OpenAI hat dieses Jahr bereits GPT-4o veröffentlicht, das effizienter als GPT-4 sein sollte. Aber es war immer noch ziemlich teuer und konnte eine ziemliche Rechnung verursachen, insbesondere für Entwickler, die das KI-Modell den ganzen Tag über wiederholt über die API für ihre Apps aufrufen müssen.

Infolgedessen griffen Entwickler auf günstigere kleine KI-Modelle von Wettbewerbern zurück, wie etwa Gemini 1.5 Flash oder Claude 3 Haiku.

Jetzt bringt OpenAI mit GPT-4o mini ihr bisher kosteneffizientestes Modell auf den Markt, mit dem sie auch in den Markt der kleinen KI-Modelle einsteigen. Obwohl GPT-4o mini ihr bisher billigstes Modell ist, erreicht es diese niedrigen Kosten nicht durch Abstriche bei der Intelligenz; es ist intelligenter als das bestehende GPT-3.5 Turbo-Modell.

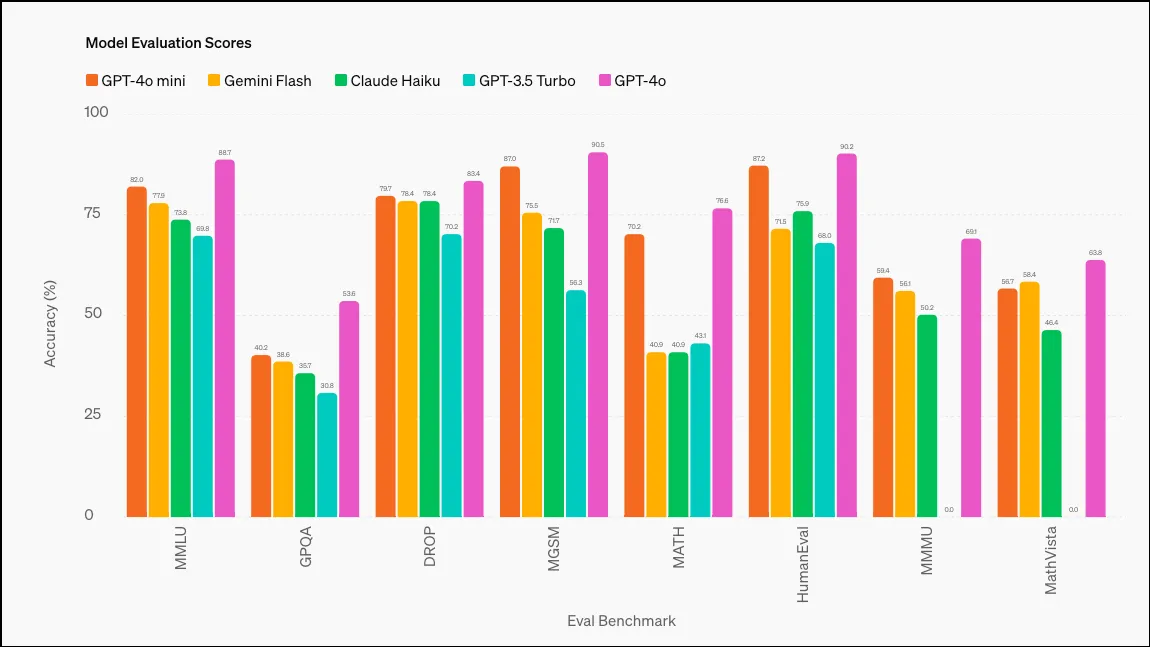

Laut OpenAI erreichte GPT-4o mini 82 % in MMLU (Measuring Massive Multitask Language Understanding) und übertraf damit viele Modelle; dies sind die jeweiligen Ergebnisse der verschiedenen Modelle: GPT-3.5 Turbo (70 %), Claude 3 Haiku (75,2 %) und Gemini 1.5 Flash (78,9 %). GPT-4o erreichte bei diesem Benchmark 88,7 %, wobei Gemini Ultra mit 90 % das höchste Ergebnis vorweisen konnte (dies sind allerdings keine kleinen KI-Modelle).

GPT-4o mini wird heute für ChatGPT Free-, Team- und Plus-Benutzer sowie Entwickler eingeführt. Für ChatGPT-Benutzer hat es im Wesentlichen GPT-3.5 ersetzt; GPT-4o mini wird das Modell sein, auf das die Konversation standardmäßig zurückgreift, sobald Sie keine kostenlosen GPT-4o-Abfragen mehr haben. Entwickler haben weiterhin die Möglichkeit, GPT-3.5 über die API zu verwenden, aber es wird irgendwann fallengelassen. ChatGPT Enterprise-Benutzer erhalten nächste Woche Zugriff auf GPT-4o mini.

Wie oben erwähnt, liegt der Schwerpunkt von GPT-4o mini darauf, Entwicklern zu helfen, ein kostengünstiges und leistungsfähiges Modell für ihre App zu finden, das zudem über geringe Latenzzeiten verfügt. Im Vergleich zu anderen kleinen Modellen zeichnet sich GPT-4o mini durch hervorragende Ergebnisse bei Denkaufgaben sowohl in Text als auch in Bild, bei mathematischen Denk- und Codieraufgaben sowie bei multimodalem Denken aus.

Derzeit werden in der API sowohl Text als auch Vision unterstützt. Für die Zukunft ist die Unterstützung von Text-, Bild-, Video- und Audio-Ein- und -Ausgaben geplant.

GPT-4o mini verfügt über ein Kontextfenster von 128.000 Token für die Eingabe und 16.000 Token für die Ausgabe pro Anfrage, wobei sein Wissen bis Oktober 2023 reicht. Es kann auch nicht-englische Texte recht kostengünstig verarbeiten.

Schreibe einen Kommentar