Auf seiner jährlichen I/O-Konferenz in Kalifornien machte Google mehrere Ankündigungen zum Thema KI, darunter neue Modelle und Upgrades bestehender Modelle. Eine der interessantesten Ankündigungen war das Projekt Astra – ein multimodaler Assistent, der in Echtzeit funktioniert und die Fähigkeiten von Google Lens und Gemini kombiniert, um Ihnen Informationen aus Ihrer Umgebung zu liefern.

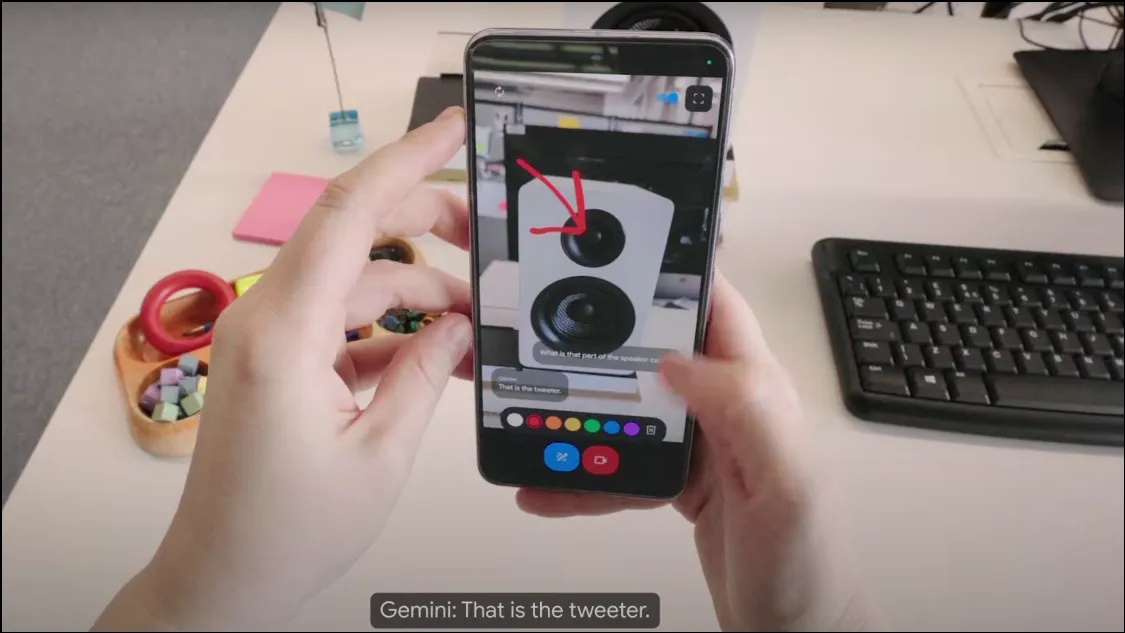

Wie funktioniert Project Astra? Auf der Konferenz zeigte Google eine frühe Version von Project Astra, das als kamerabasierter Chatbot funktioniert und mithilfe der Kamera Ihres Geräts Informationen aus Ihrer Umgebung sammeln kann. Als multimodaler KI-Assistent kann er Audio, Video und Bilder als Eingaben verwenden und darauf basierend die erforderlichen Ausgaben bereitstellen. Er läuft auf dem Modell Gemini 1.5 Pro, was ihn unglaublich leistungsstark macht.

Der Chatbot analysiert Objekte und Umgebungen in Echtzeit und kann Anfragen sehr schnell beantworten, was ihn einem menschlichen Assistenten oder Tony Starks beliebtem JARVIS sehr ähnlich macht. Project Astra funktioniert auch mit Wearables wie Smart Glasses, was bedeutet, dass es viel Potenzial für die Integration des KI-Chatbots in verschiedene Geräte gibt.

Project Astra kann den Kontext, in dem es verwendet wird, besser verstehen, Informationen schneller verarbeiten und sie für ein schnelleres Abrufen speichern. Auch seine Sprachfähigkeiten sind im Vergleich zu denen früherer Gemini-Modelle deutlich verbessert, sodass es natürlicher und menschlicher klingt.

Was kann Project Astra? In der kurzen Demo, die Google vorführte, scheint es, als könne Project Astra viel leisten. Es kann Objekte und Orte durch die Kameralinse und das Mikrofon beobachten und erfassen und Ihnen Informationen darüber liefern. Sie können beispielsweise Ihr Telefon einfach auf einen Codeabschnitt richten und ihn mit dem Chatbot besprechen oder ihn bitten, ein Objekt und seine Verwendung zu identifizieren.

Dank der Standorterkennungsfunktionen kann Project Astra Informationen über Ihren Standort liefern, indem es einfach Ihre Umgebung betrachtet. Es kann auch angezeigte Informationen speichern, was sehr praktisch sein kann, wenn Sie verlegte Gegenstände wiederfinden möchten, wie in der Demo gezeigt wurde, als es dem Benutzer half, seine Brille zu finden.

Sie können den KI-Assistenten auch um kreative Ideen bitten, genau wie bei Gemini auf Ihrem Telefon. Sie können ihn beispielsweise bitten, sich einen Liedtext, einen Namen für eine Musikband oder etwas anderes auszudenken. Im Grunde zielt Project Astra darauf ab, ein universeller KI-Assistent zu sein, der Ihnen in Echtzeit und auf sehr gesprächige Weise Informationen liefern kann.

Wann wird Project Astra verfügbar sein? Bis jetzt hat Google keine Ankündigungen zur Verfügbarkeit von Project Astra gemacht. Die in der Demo gezeigte Version ist ein früher Prototyp, aber Google deutete an, dass diese Funktionen zu einem späteren Zeitpunkt in die bestehende Gemini-App integriert werden könnten.

Mit Project Astra strebt Google danach, die Entwicklung von KI-Assistenten voranzutreiben, damit diese noch nützlicher und benutzerfreundlicher werden. Google ist jedoch nicht der einzige Anbieter, der dieses Ziel verfolgt. OpenAI hat kürzlich auch GPT-4o angekündigt, wodurch ChatGPT multimodal wird und seine Fähigkeiten und Effizienz verbessert werden. Der neue Sprachmodus von ChatGPT (der bald veröffentlicht wird) kann bei der Interaktion mit Benutzern auch Videoeingaben von der Kamera des Geräts verwenden.

Der Unterschied zwischen beiden besteht derzeit darin, dass GPT-4o bald auf allen Geräten mit ChatGPT verfügbar sein wird, während Project Astra voraussichtlich irgendwann in der Zukunft als Gemini Live verfügbar sein wird, obwohl es derzeit noch kein Veröffentlichungsdatum gibt. Da GPT-4o-basiertes ChatGPT früher verfügbar war, bleibt abzuwarten, ob Googles Project Astra gut genug sein wird, um mit dem beliebteren Chatbot von OpenAI mitzuhalten.

Schreibe einen Kommentar