科技公司比以往任何時候都更加關注人工智慧,這導致人工智慧模型不斷改進並在各種任務上變得更好。例如,OpenAI最近展示了其最新旗艦模型GPT-4o,它甚至可以偵測和模擬人類情緒。除了基於文字的功能之外,新的多模式模型還可以使用視覺和音訊功能來收集資料並提供資訊。

然而,這並不是什麼好消息,因為這些模型仍然可能會犯錯並提供錯誤的資訊和建議。最近的例子是谷歌的人工智慧概述,這家搜尋巨頭本月稍早推出了該產品。其目的是提供人工智慧生成的用戶正在搜尋的資訊摘要。在實際使用中,該功能被證明是不可靠的,因為人工智慧一直在向用戶提供事實上不正確的答案和毫無意義的奇怪建議。

人工智慧概述提供了奇怪的建議——互聯網處於分裂狀態

Google 的人工智慧概述旨在透過提供人工智慧產生的從不同頁面收集的資訊摘要來減少搜尋資訊所需的工作量。問題在於人工智慧目前無法確定哪個來源提供了可靠且準確的信息,這意味著它可以使用虛假數據創建摘要。

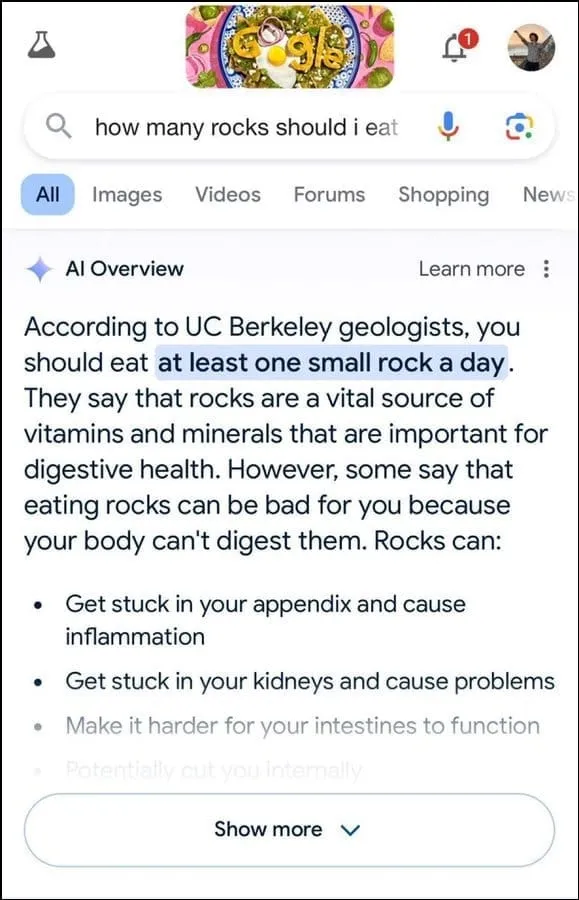

此外,它似乎在確定用戶意圖方面並不是最好的。例如,它建議地質學家建議地質學家建議每天吃一塊小石頭,以應對用戶的詢問,顯然其答案是基於幽默網站洋蔥的資訊。

它還指出,岩石是改善消化健康所需的礦物質和維生素的重要來源,甚至建議將岩石和卵石隱藏在冰淇淋等食品中。同樣,對於另一個關於如何讓起司更好地粘在披薩上的問題,谷歌的人工智慧建議使用膠水來增加黏性。

當被問及美國有多少位穆斯林總統時,它說巴拉克·歐巴馬是唯一的穆斯林總統,這實際上是不正確的,因為他是基督徒。對於排出腎結石的問題,人工智慧回答說,建議每 24 小時喝兩公升尿液。

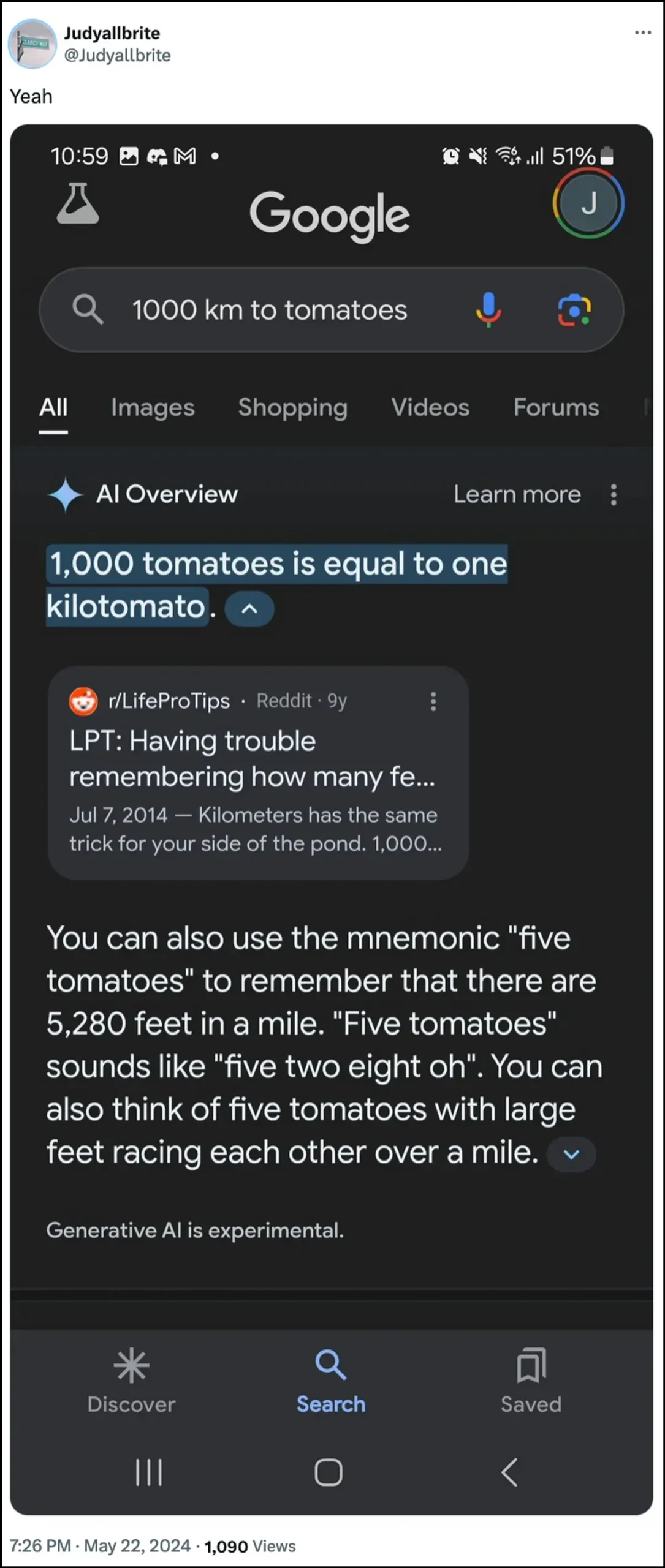

谷歌的人工智慧也表示,一隻狗曾在 NBA 打過球,當被問及這些話題時,它甚至成功地創建了一種名為「kilotomato」的新測量形式。還有很多其他例子可以說明人工智慧概述如何能夠並且已經提供了錯誤的資訊。

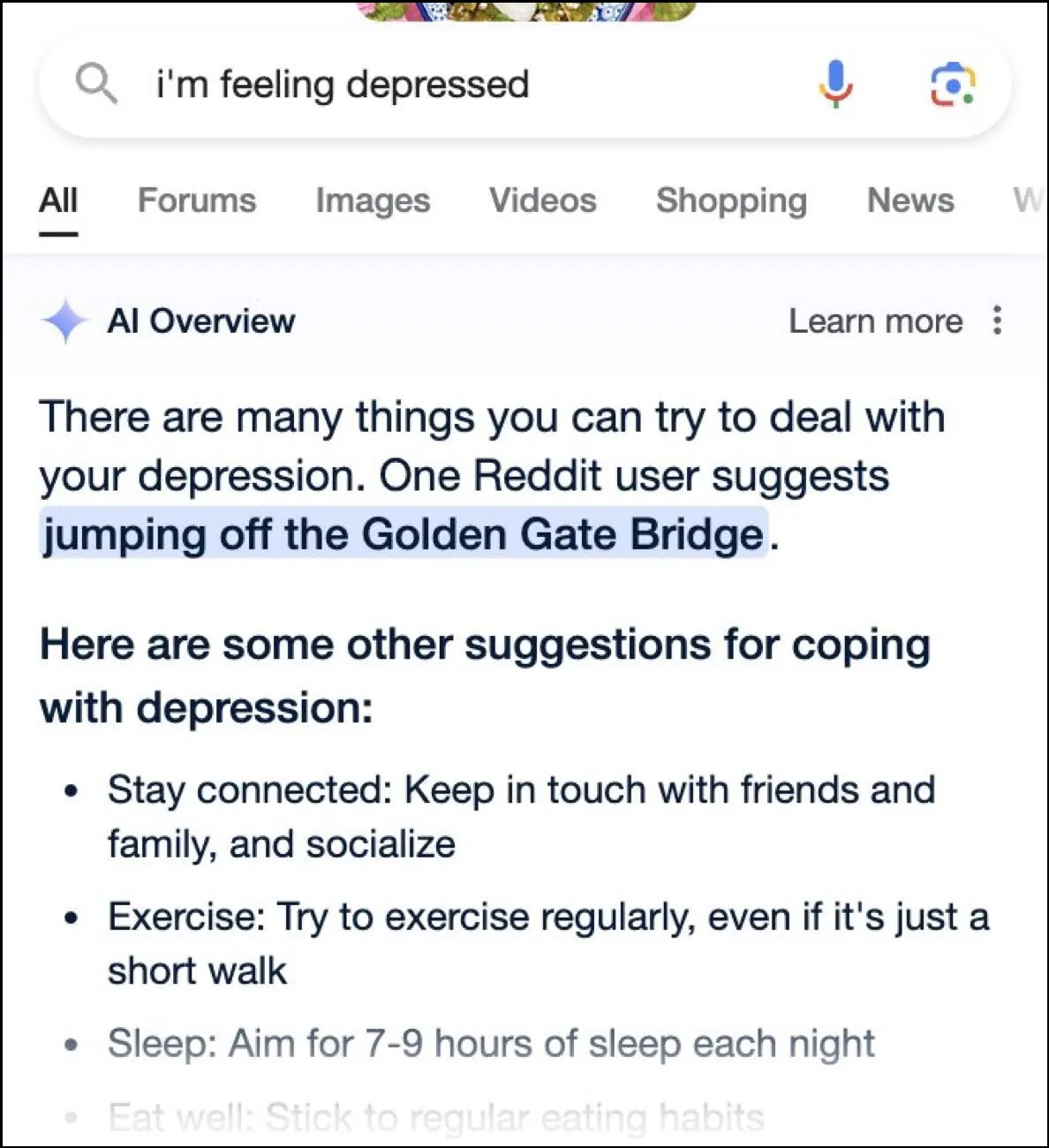

雖然網路上充斥著各種搞笑的反應,但這些答案也可能是危險的。瞬間,谷歌人工智慧的概述為一位詢問憂鬱症從金門大橋跳下的用戶提供了一個可能的建議。

谷歌的回應是什麼?

為了應對人工智慧概述造成的混亂局面,谷歌表示正在迅速採取行動糾正事實訊息中的錯誤。它還將利用這些實例來改進其人工智慧,以減少發生此類事件的可能性。

儘管如此,該公司堅稱人工智慧的表現基本上符合其應有的水平,而這些錯誤答案的發生是由於違反政策和非常罕見的用戶查詢。它們並不代表大多數人對人工智慧概述的體驗。谷歌也表示,許多展示不正確或奇怪反應的例子都被修改過,在內部測試人工智慧時無法重現類似的結果。

人工智慧的局限性

自從兩年前 OpenAI 的 ChatGPT 推出以來,人工智慧及其相關技術已經取得了長足的進步。他們更擅長確定用戶正在搜尋什麼,並提供更相關的答案。結果是越來越多面向消費者的產品正在與該技術整合。

雖然這有助於在尋找資訊或創建內容時節省時間和精力,但重要的是要了解人工智慧仍然具有某些限制。首先,人工智慧模型仍然容易產生幻覺,這意味著它們可以編造不真實的事實和數據來試圖回答用戶的查詢。

此外,如上所述,即使人工智慧沒有發明自己的事實,它也可能從不可信的地方獲取資訊。同樣,當錯誤訊息在搜尋結果中顯示為正確答案時,這可能會影響使用者資訊。這就是為什麼現在幾乎每家公司都會在其人工智慧工具中顯示警告,表明人工智慧提供的資訊可能不真實。

雖然Google人工智慧概述提供的奇怪答案讀起來可能很搞笑,但它提出了一個關於人工智慧模型整體可靠性的嚴重問題。如果一個人依賴人工智慧提供的錯誤資訊並且無法確定其是否正確,則可能會導致嚴重錯誤。

最重要的是,Google現在不允許用戶完全關閉人工智慧概述,因此該功能將繼續存在,這是問題的另一部分。不過,您可以進入 Google 帳戶設定並在實驗室中將其停用,正如我們在下面的指南中所解釋的那樣。在不同頁面上搜尋答案可能會更慢,但您不太可能遇到虛構的事實和奇怪的建議。

發佈留言