如果您想在電腦上執行大型語言模型或 LLM,最簡單的方法之一就是透過 Ollama。 Ollama 是一個功能強大的開源平台,提供可自訂且易於存取的 AI 體驗。它可以輕鬆下載、安裝各種法學碩士並與之交互,無需依賴基於雲端的平台或需要任何技術專業知識。

除了上述優點之外,Ollama 相當輕量級且定期更新,這使得它非常適合在本機上建置和管理 LLM。因此,您不需要任何外部伺服器或複雜的配置。 Ollama 還支援多種作業系統,包括 Windows、Linux 和 macOS,以及各種 Docker 環境。

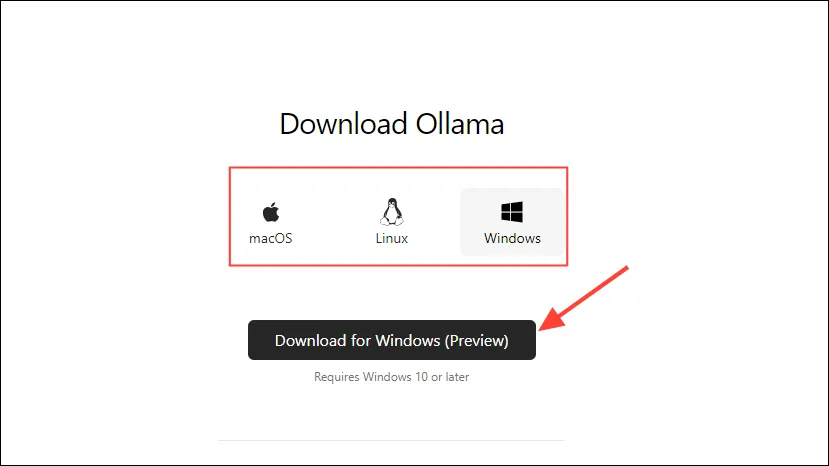

下載並安裝 Ollama

- 首先,造訪 Ollama 下載頁面並選擇您的作業系統,然後按一下「下載」按鈕。

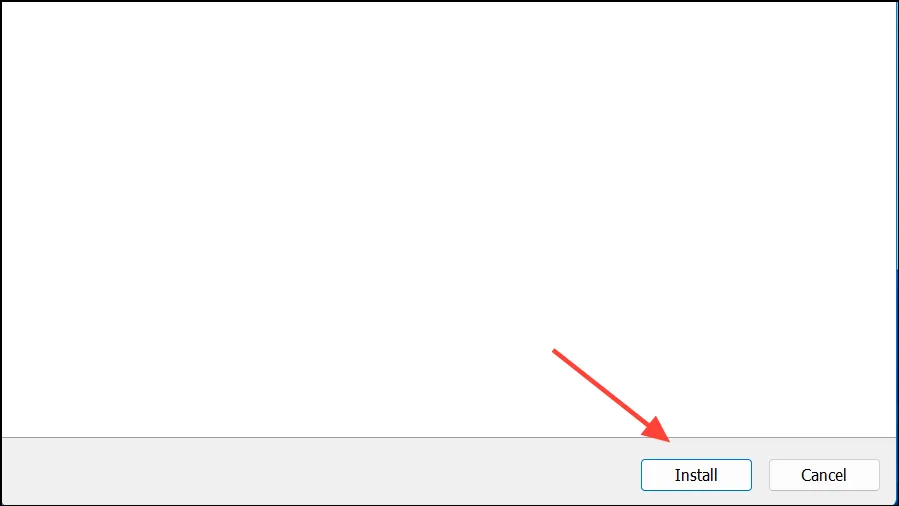

- 下載完成後,打開它並將其安裝到您的電腦上。安裝完成後,安裝程式將自動關閉。

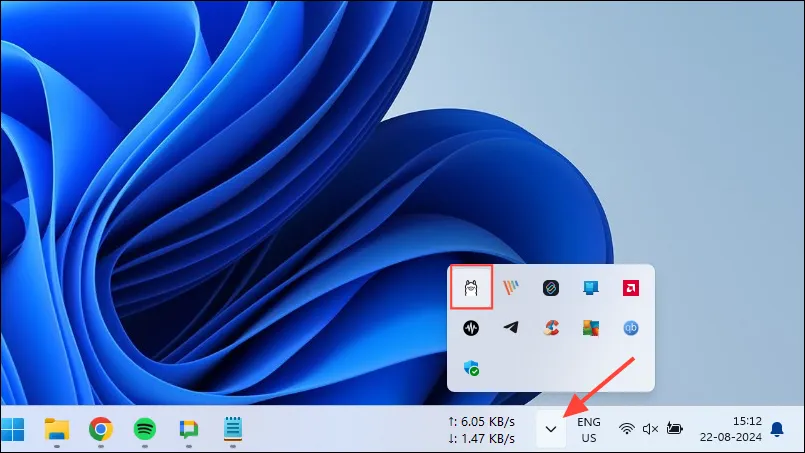

- 在 Windows 上,您可以透過點擊工作列溢位按鈕來查看隱藏圖示來檢查 Ollama 是否正在執行。

客製化和使用Ollama

一旦 Ollama 安裝在您的電腦上,您應該做的第一件事就是更改它儲存資料的位置。預設情況下,儲存位置是C:\Users\%username%\.ollama\models,但由於 AI 模型可能非常大,因此您的 C 碟很快就會被填滿。為此,

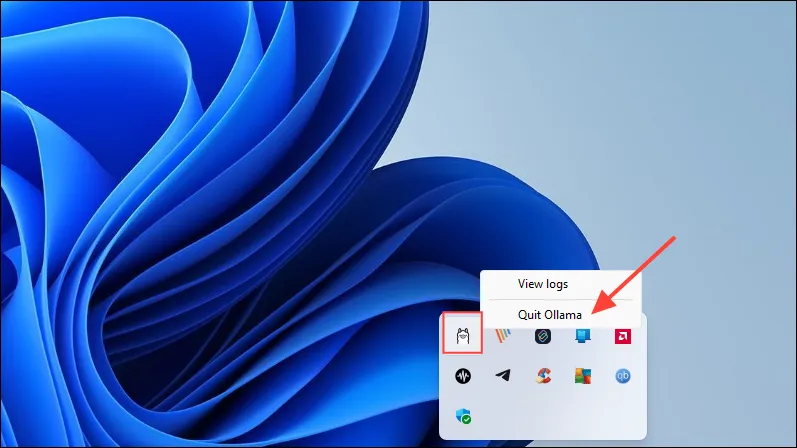

- 首先,按一下工作列中的 Ollama 圖標,然後按一下「退出 Ollama」。

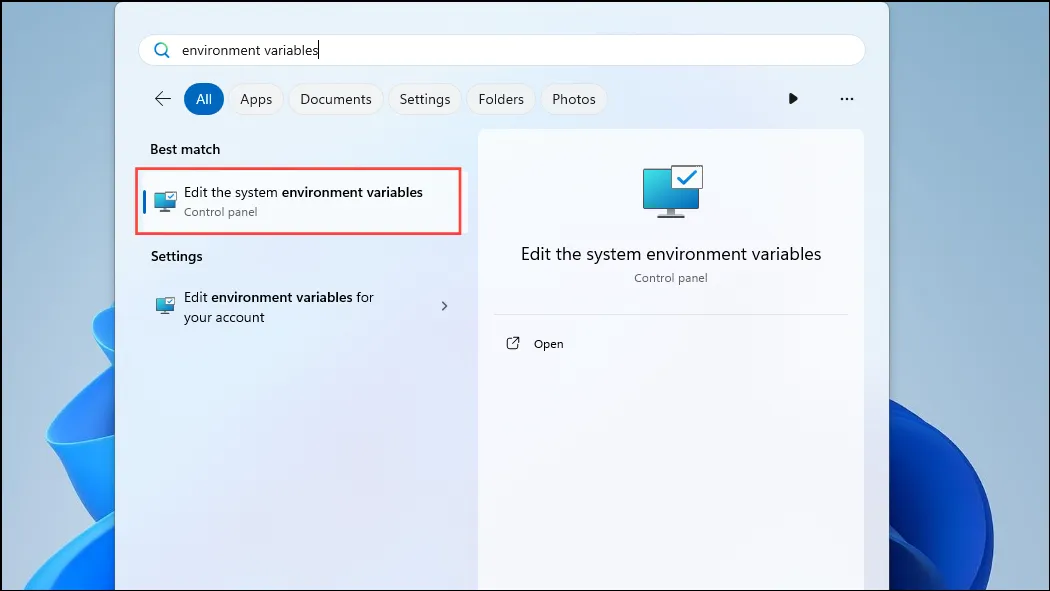

- Ollama 退出後,開啟「開始」功能表,鍵入

environment variables並按一下「編輯系統環境變數」。

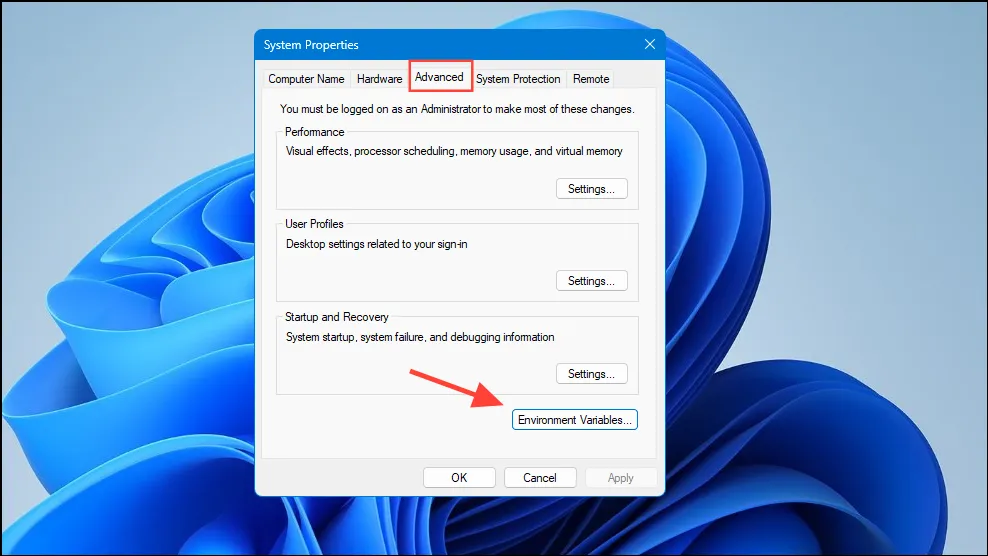

- 當「系統變數」對話方塊開啟時,按一下「進階」標籤上的「環境變數」按鈕。

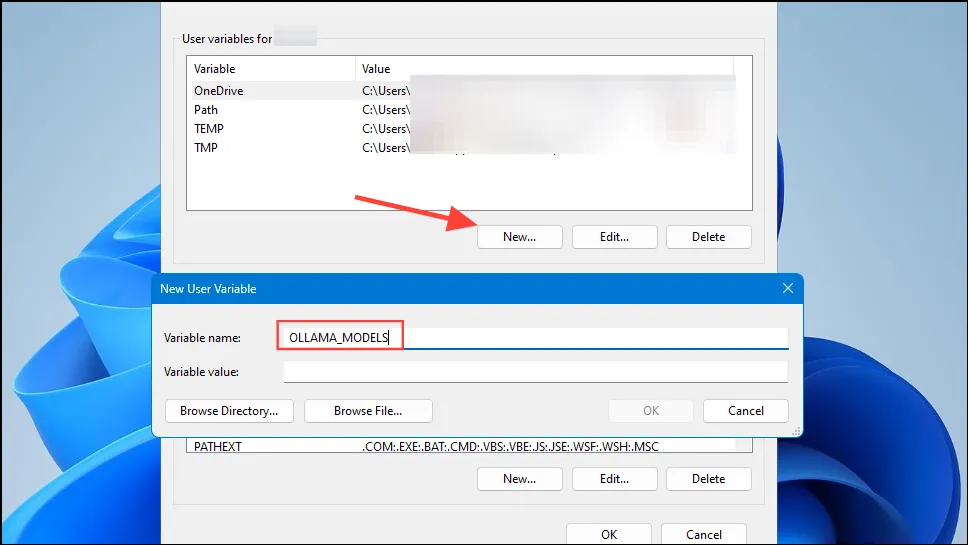

- 按一下您的使用者帳戶的「新建」按鈕,然後建立一個

OLLAMA_MODELS在「變數名稱」欄位中命名的變數。

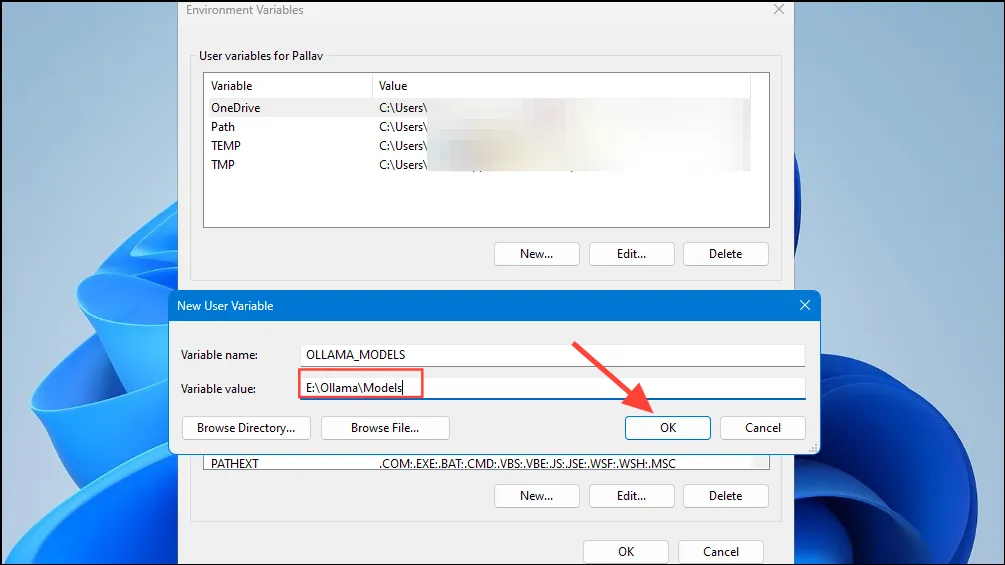

- 然後在「變數值」欄位中輸入您希望 Ollama 儲存其模型的目錄位置。然後按一下「確定」按鈕,然後從「開始」功能表啟動 Ollama。

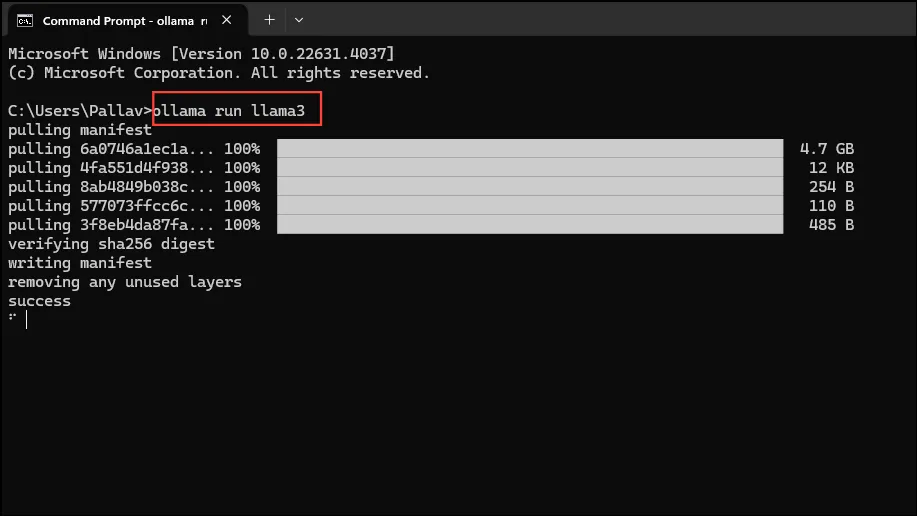

- 現在您已準備好開始使用 Ollama,您可以使用 Meta 的 Llama 3 8B(該公司最新的開源 AI 模型)來完成此操作。若要執行模型,請從「開始」功能表啟動命令提示字元、Powershell 或 Windows 終端機視窗。

- 命令提示字元視窗開啟後,鍵入

ollama run llama3並按 Enter。該型號接近5 GB,因此下載需要時間。

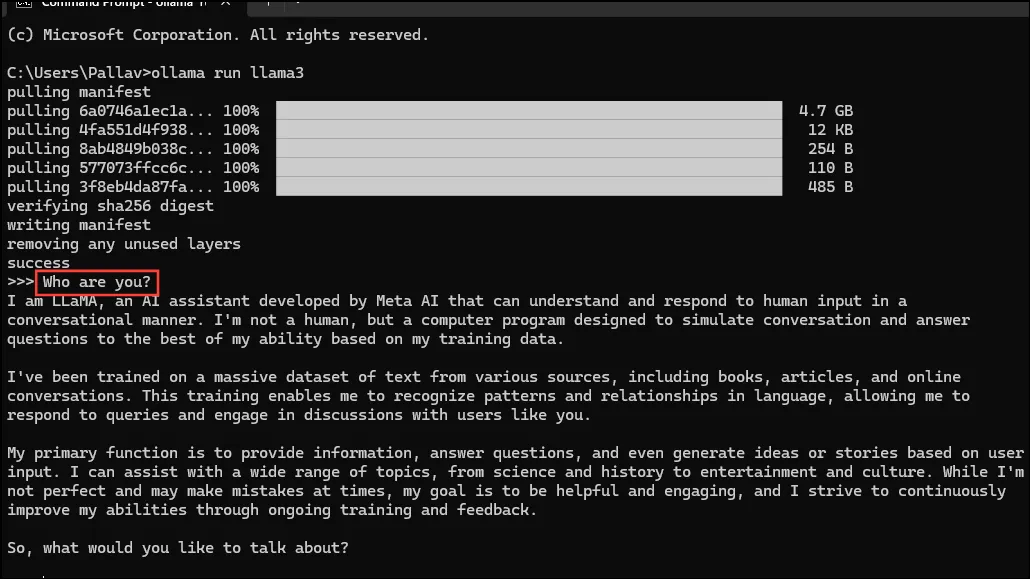

- 下載完成後,您就可以開始使用 Llama 3 8B 並直接在命令列視窗中與之對話。例如,您可以詢問模型

Who are you?並按 Enter 以獲得答案。

- 現在,您可以繼續對話並向 AI 模型詢問各種主題的問題。請記住,Llama 3 可能會犯錯並產生幻覺,因此使用時應小心。

- 您也可以造訪 Ollama 模型庫頁面來嘗試其他模型。此外,您可以執行各種命令來嘗試 Ollama 提供的不同功能。

- 您也可以在執行模型時執行各種操作,例如設定會話變數、顯示模型資訊、儲存會話等。

- Ollama 還允許您利用多模式 AI 模型來識別影像。例如,LLava 模型可以辨識 DALLE-3 產生的影像。它可以詳細地描述圖像。

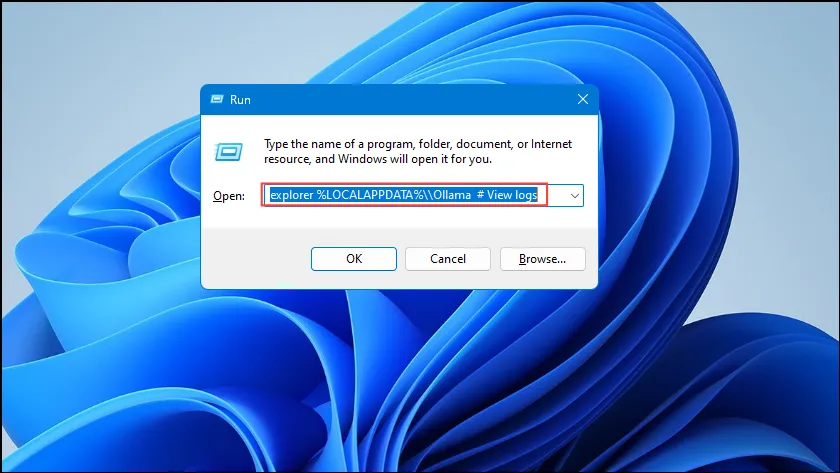

- 如果您在執行 Ollama 時遇到錯誤,您可以檢查日誌以找出問題所在。使用

Win + R捷徑開啟「執行」對話框,然後explorer %LOCALAPPDATA%\\Ollama # View logs在按 Enter 鍵之前在其中鍵入內容。

- 您也可以使用其他命令(例如

explorer %LOCALAPPDATA%\\Programs\\Ollama和 )explorer %HOMEPATH%\\.ollama來檢查二進位檔案、模型和配置儲存位置。

要知道的事情

- Ollama 會自動偵測您的 GPU 來執行 AI 模型,但在具有多個 GPU 的機器中,它可能會選擇錯誤的 GPU。為了避免這種情況,請開啟 Nvidia 控制面板並將顯示設為「僅限 Nvidia GPU」。

- 顯示模式可能並非在每台電腦上都可使用,且當您將電腦連接到外部顯示器時也不存在。

- 在 Windows 上,您可以使用工作管理員檢查 Ollama 是否使用正確的 GPU,工作管理員將顯示 GPU 使用情況並讓您知道正在使用哪一個。

- 雖然在 macOS 和 Linux 上安裝 Ollama 與 Windows 有點不同,但透過它運行 LLM 的過程非常相似。

發佈留言